论文标题:GLIDE: Towards Photorealistic Image Generation and Editing with Text-Guided Diffusion Models

论文链接:https://arxiv.org/abs/2112.10741

代码链接:https://github.com/openai/glide-text2im

文本图像合成(text-to-image)是近来多模态学习领域中大火的话题。对于计算机视觉系统,要想机器真正的理解视觉世界,不仅需要模型能够自动识别图像,同时需要生成图像。文本图像合成等工作相较于之前更为常见的图像描述(image captioning)任务而言,图像所包含的信息更为复杂,生成的难度也更大。

本文通过将指导扩散(guided diffusion)作用于文本图像合成,训练了一个包含35亿参数的扩散模型,该模型使用文本编码器以自然语言描述作为条件,然后分别使用了两种指导扩散模型到文本prompt的方法:CLIP引导和无分类器引导(classifier-free)。经过一系列的评估,作者发现使用后者引导后的模型效果更佳。此外,GLIDE还可以通过微调来执行图像修复,从而实现强大的文本驱动图像编辑能力。

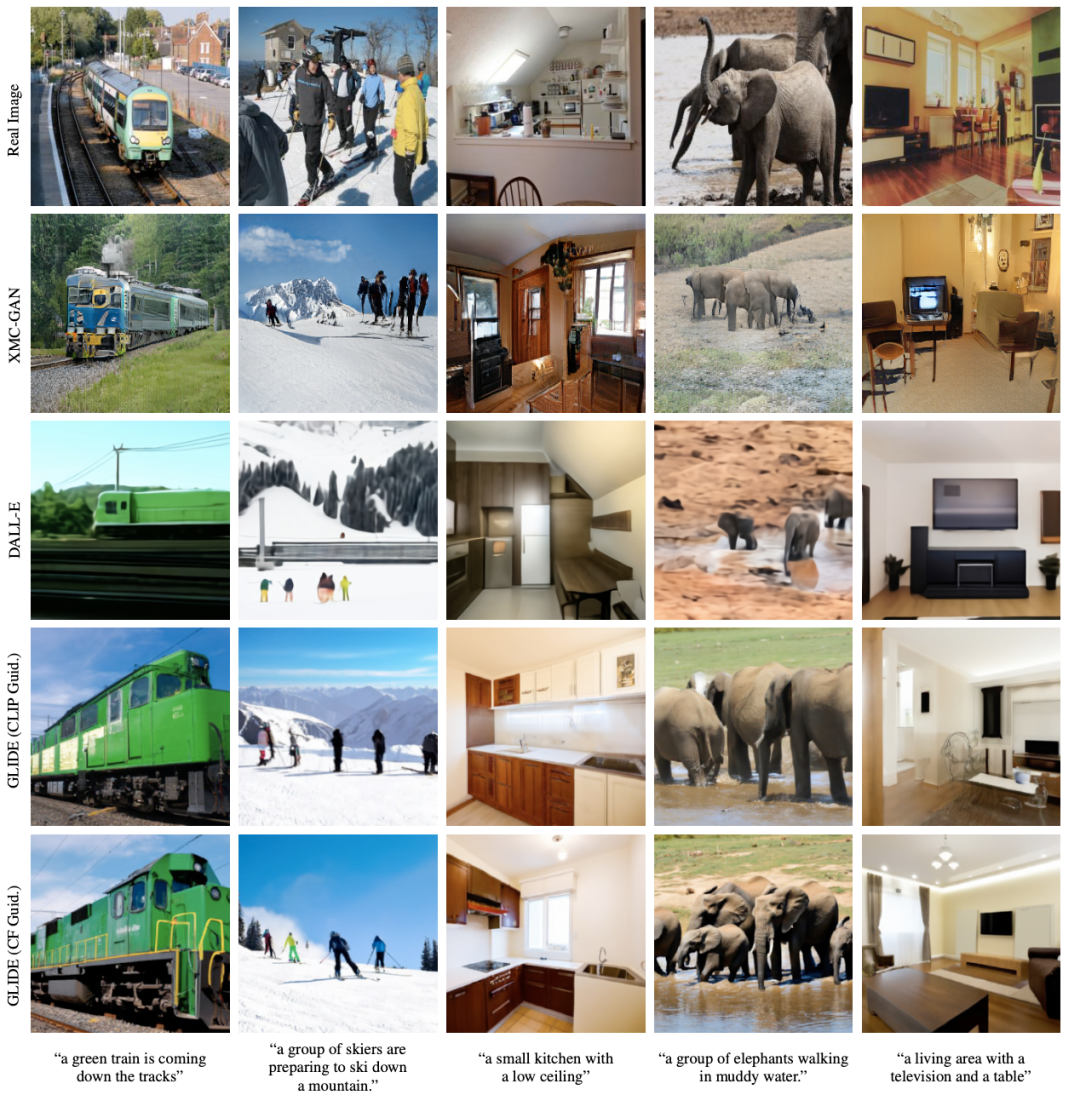

下图展示了直观比较CLIP引导和无分类引导方式的生成效果,可以发现来自无分类引导得到的样本(最后一行)在视觉感官上相比CLIP(倒数第二行)更加真实。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢