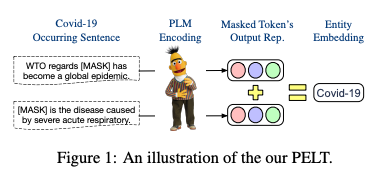

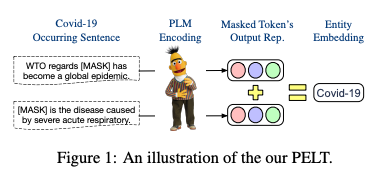

标题:清华、微信|A Simple but Effective Pluggable Entity Lookup Table for Pre-trained Language Models(一个用于预训练语言模型的简单但有效的可插拔实体查找表)

https://github.com/thunlp/PELT

https://arxiv.org/pdf/2202.13392.pdf

内容中包含的图片若涉及版权问题,请及时与我们联系删除

https://github.com/thunlp/PELT

https://arxiv.org/pdf/2202.13392.pdf

内容中包含的图片若涉及版权问题,请及时与我们联系删除

沙发等你来抢

评论

沙发等你来抢