人工智能系统或许能够快速完成任务,但这并不意味着它们总是公平地完成任务。如果用于训练机器学习模型的数据集包含有偏置的数据,那么系统在实践中做出决策时可能会表现出同样的偏置。

例如,如果数据集主要包含白人男性的图像,那么使用这些数据训练的面部识别模型对于女性或具有不同肤色的人来说可能不太准确。

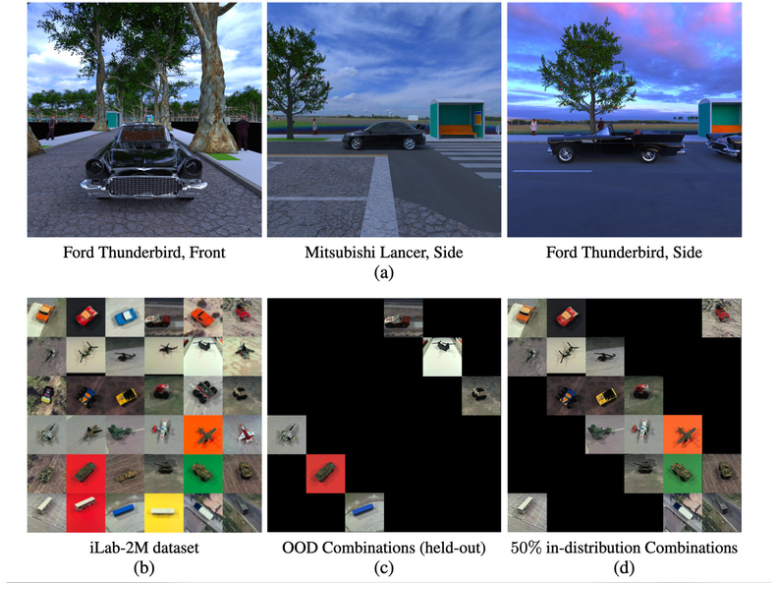

麻省理工学院的一组研究人员与哈佛大学和富士通有限公司的研究人员合作,试图了解机器学习模型何时以及如何能够克服这种数据集偏差。他们使用神经科学的一种方法来研究训练数据如何影响人工神经网络是否能够学会识别它以前从未见过的物体。神经网络是一种机器学习模型,它模仿人脑的方式,其中包含处理数据的互连节点或“神经元”层。

新结果表明,训练数据的多样性对神经网络是否能够克服偏差有重大影响,但同时数据集的多样性会降低网络的性能。他们还表明,神经网络是如何训练的,以及在训练过程中出现的特定类型的神经元,可以在它是否能够克服有偏置的数据集方面发挥重要作用。

“神经网络可以克服数据集偏差,这是令人鼓舞的。但这里的主要内容是我们需要考虑数据的多样性。我们需要停止认为,如果您只收集大量原始数据,那您就会有所收获。我们首先需要非常小心地设计数据集,”大脑与认知科学系 (BCS) 和大脑、思维和机器中心 (CBMM) 的研究科学家 Xavier Boix 说,并且论文的高级作者。

合著者包括前麻省理工学院研究生 Timothy Henry、Jamell Dozier、Helen Ho、Nishchal Bhandari 和目前正在哈佛大学攻读博士学位的通讯作者 Spadan Madan;Tomotake Sasaki,前访问科学家,现为富士通研究院高级研究员;Frédo Durand,麻省理工学院电气工程和计算机科学教授,计算机科学与人工智能实验室成员;哈佛工程与应用科学学院计算机科学系 An Wang 教授 Hanspeter Pfister。该研究今天发表在Nature Machine Intelligence上。

论文链接:https://arxiv.org/pdf/2007.08032.pdf

代码链接:

https://github.com/Spandan-Madan/generalization_biased_category_pose

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢