作者:Zhenhailong Wang, Hang Yu, Manling Li,等

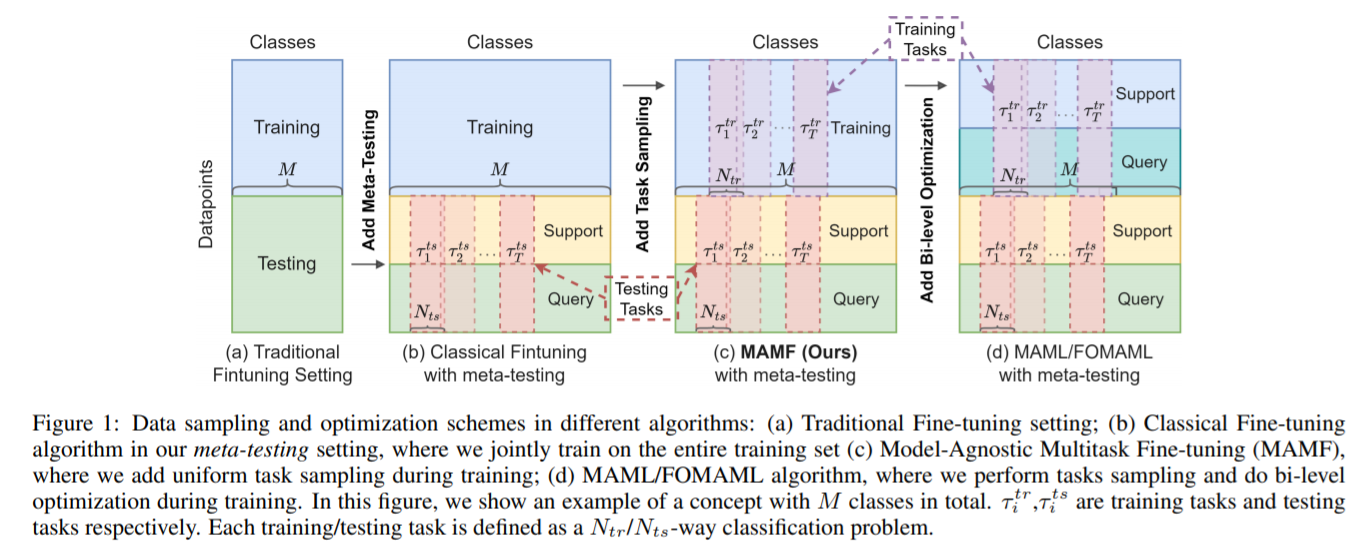

简介:本文研究小样本视频预训练模型的微调策略。尽管实现了最先进的零样本性能,但现有的视觉语言模型,例如 CLIP,仍然无法满足特定领域的分类任务,例如真菌分类。在少样本迁移学习的背景下,传统的微调无法阻止高度表达模型利用训练数据中的虚假相关性。另一方面,尽管与模型无关的元学习 (MAML) 是迁移学习的自然替代方案,但由于隐式二阶优化导致的昂贵计算限制了其在大规模模型和数据集中的使用。在这项工作中,作者的目标是通过基于统一任务采样的简单而有效的微调策略,进一步改进现有视觉语言模型对看不见的任务的泛化。作者将作者的方法称为与模型无关的多任务微调 (MAMF)。与 MAML 相比,MAMF 摒弃了双层优化,仅使用一阶梯度,使其易于扩展且计算效率高。由于统一的任务采样过程,MAMF 在五个基准数据集上的小样本迁移学习始终优于经典微调方法。根据经验,作者进一步发现一阶 MAML 的有效性高度依赖于预训练模型的零样本性能,并且作者的简单算法可以在零样本性能较低的更具挑战性的数据集上优于一阶 MAML。

论文下载:https://arxiv.org/pdf/2203.04904

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢