标题:乔治亚理工、布鲁克海文国家实验室、台湾中央研究院等|WHEN BERT MEETS QUANTUM TEMPORAL CONVOLUTION LEARNING FOR TEXT CLASSIFICATION IN HETEROGENEOUS COMPUTING(当 BERT 在异构计算中遇到用于文本分类的量子时间卷积学习)

作者:Chao-Han Huck Yang, Jun Qi, Samuel Yen-Chi Chen, Yu Tsao, Pin-Yu Chen

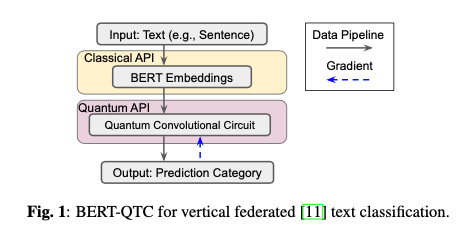

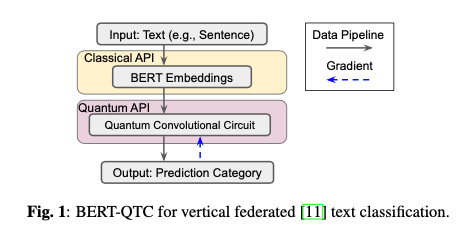

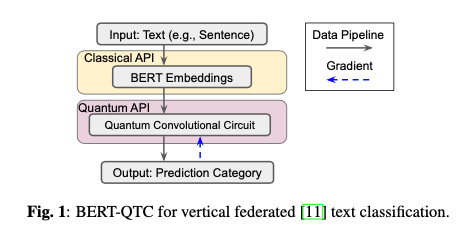

简介:本文将量子计算应用于预训练模型。量子计算的快速发展展现了量子优势的许多独特特征,例如更丰富的特征表示和对模型参数的更安全保护。这项工作提出了一种基于变分量子电路的垂直联邦学习架构,以展示用于文本分类的量子增强预训练 BERT 模型的竞争性能。特别是,作者提出的混合经典量子模型由一种新颖的随机量子时间卷积(QTC)学习框架组成,该框架取代了基于 BERT 的解码器中的一些层。作者对意图分类的实验表明,作者提出的 BERT-QTC 模型在 Snips 和 ATIS 口语数据集中获得了具有竞争力的实验结果。特别是,BERT-QTC 将现有的基于量子电路的语言模型在两个文本分类数据集中的性能提高了 1.57% 和 1.52%。此外,BERT-QTC 可以部署在现有的商用量子计算硬件和基于 CPU 的接口上,以确保数据隔离。

论文下载:https://arxiv.org/pdf/2203.03550.pdf

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢