背景

近些年,NLP 应用方面有所突破,Bert、GPT、GPT-3 等超大模型横扫各种 NLP 测试后,人们发现参数量越大的模型,在算法方面表现越好,于是纷纷开始迅速向大模型方向发展,模型体积爆炸式增长。而大模型训练给现有的训练系统带来的主要挑战为显存压力,计算压力和通信压力。

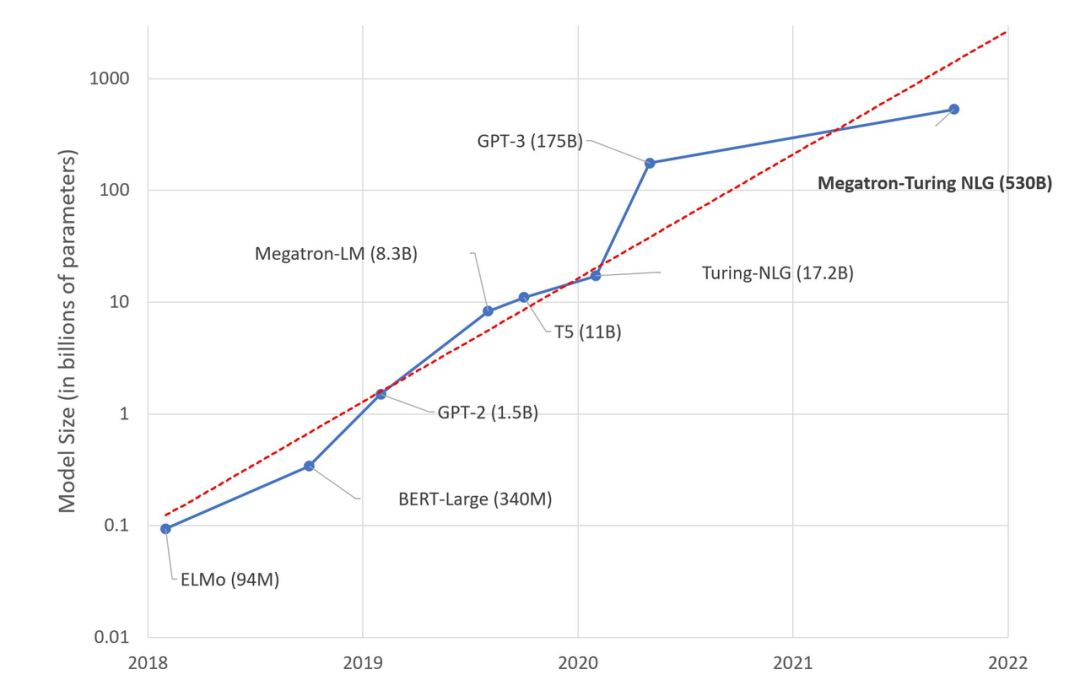

The size of language model is growing at an exponential rate (来源:https://huggingface.co/blog/large-language-models)

火山引擎大模型训练框架 veGiantModel

针对这个需求,字节跳动 AML 团队内部开发了火山引擎大模型训练框架 veGiantModel。基于 PyTorch 框架,veGiantModel 是以 Megatron 和 DeepSpeed 为基础的高性能大模型训练框架。其特点包括:

- 同时支持数据并行、算子切分、流水线并行 3 种分布式并行策略,同时支持自动化和定制化的并行策略;

- 基于 ByteCCL 高性能异步通讯库,训练任务吞吐相比其他开源框架有 1.2x-3.5x 的提升;

- 提供了更友好、灵活的流水线支持,降低了模型开发迭代所需要的人力;

- 可在 GPU上高效地支持数十亿至上千亿参数量的大模型;

- 对带宽要求低,在私有化部署无 RDMA 强依赖。

- 其中,ByteCCL 为字节跳动自研的 BytePS 的升级版,针对 A100/V100 等各种机型拓扑做了分层规约优化,并支持了 allgather、alltoall 等更全面的通讯原语。

veGiantModel 现已在 GitHub 上开源,地址如下:

https://github.com/volcengine/veGiantModel

GitHub 上详细介绍了如何使用 veGiantModel 以及如何使用 veGiantModel 快速跑起一个 GPT 的预训练。火山引擎机器学习平台原生支持了 veGiantModel,目前平台正在公测中,欢迎大家试用:https://www.volcengine.com/product/ml-platform

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢