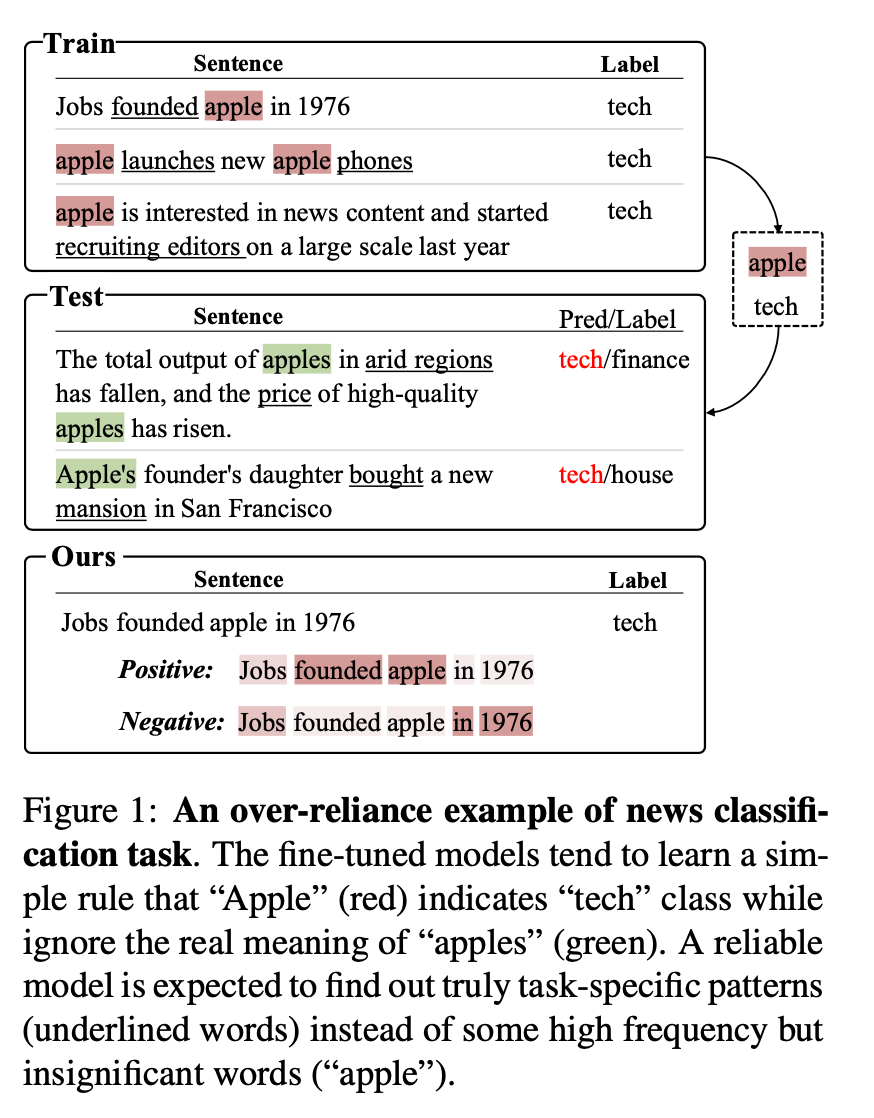

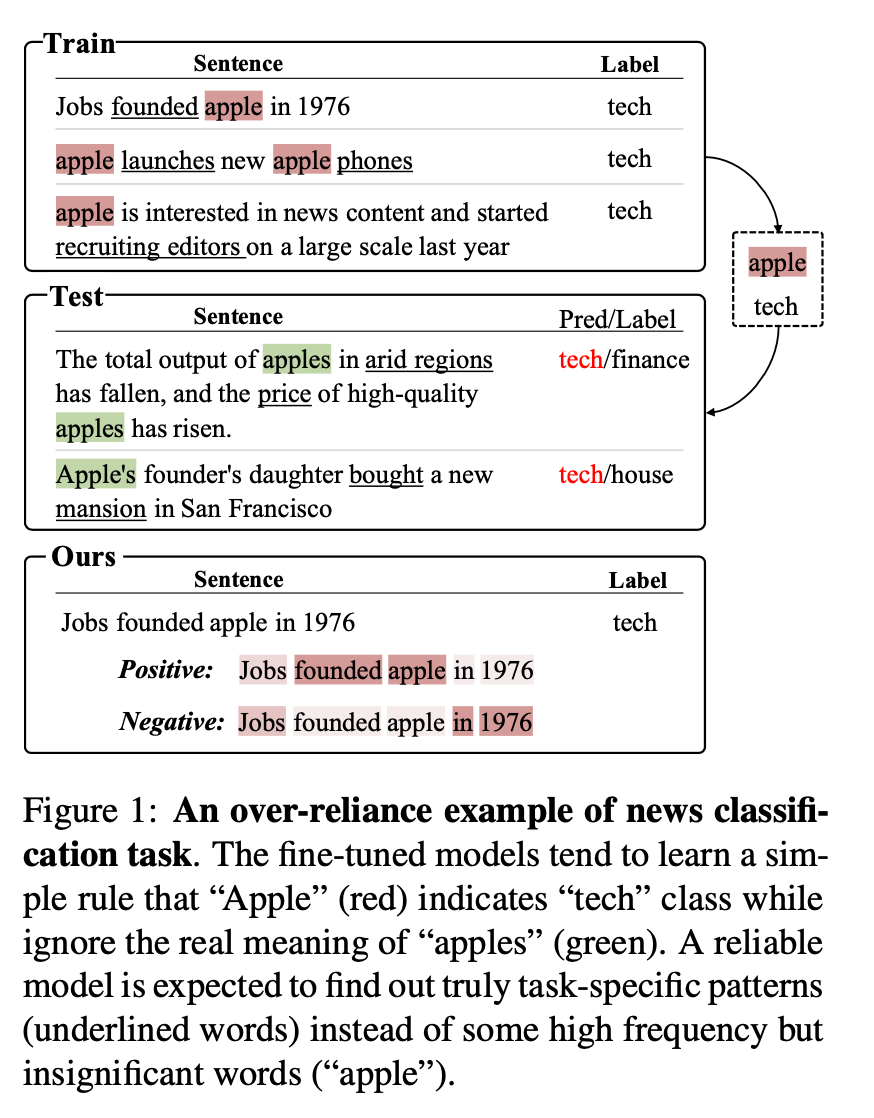

标题:腾讯、浙大|Task-guided Disentangled Tuning for Pretrained Language Models(预训练语言模型的任务引导式解纠缠调优)

https://github.com/lemon0830/TDT

https://arxiv.org/pdf/2203.11431

内容中包含的图片若涉及版权问题,请及时与我们联系删除

https://github.com/lemon0830/TDT

https://arxiv.org/pdf/2203.11431

内容中包含的图片若涉及版权问题,请及时与我们联系删除

沙发等你来抢

评论

沙发等你来抢