我会每天撰写一个AI前沿术语词知识贴,欢迎各位在评论区提出想要了解的词!如果对文章内容有任何问题或建议,也欢迎指正!

欢迎对文章多多点赞,可以关注我的主页,不错过AI前沿内容!

知识点

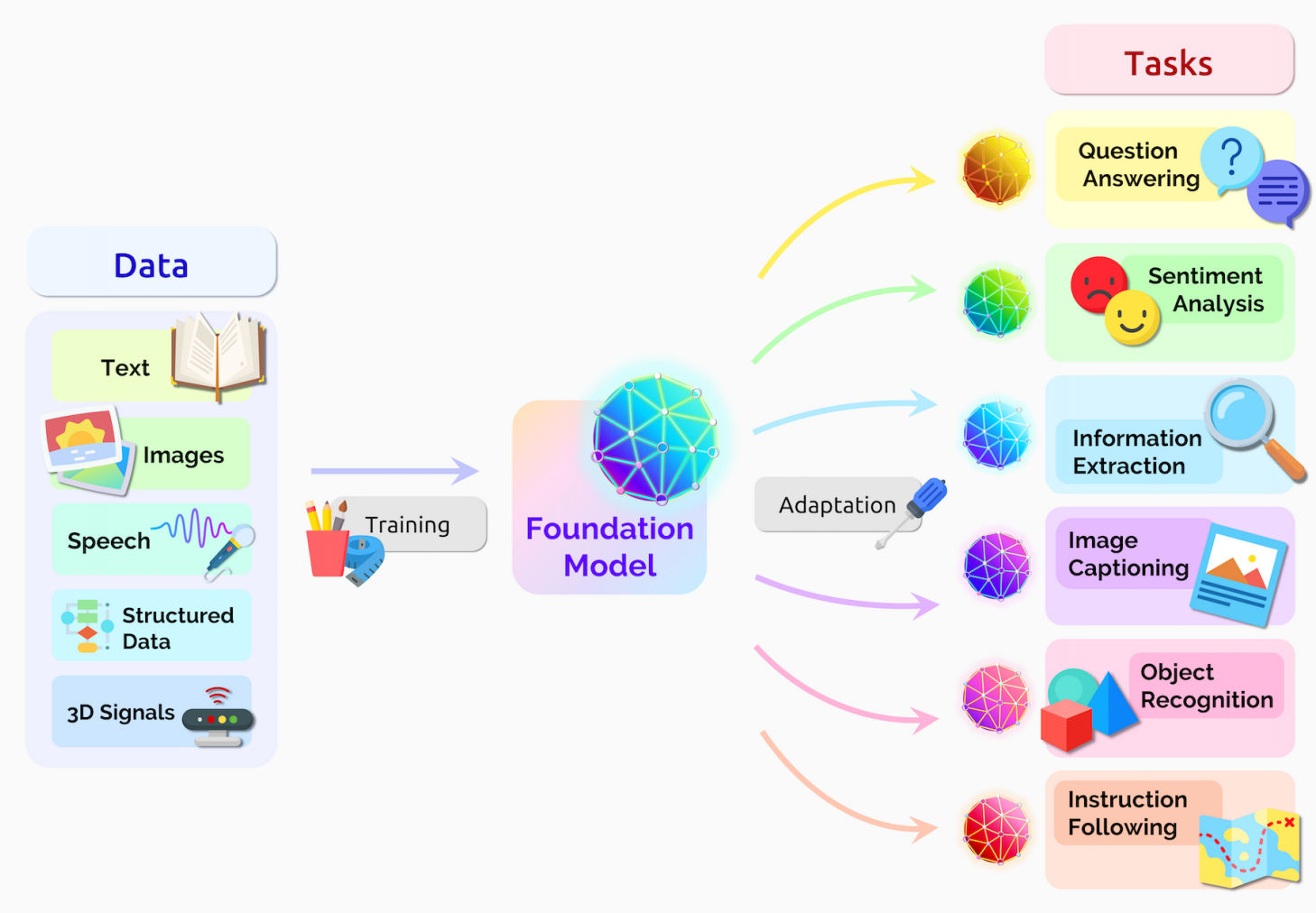

- 基础模型(Foundation Models),就指的是一种基于深度神经网络和自监督学习技术的,在大规模、广泛来源数据集上训练的AI模型。

- 基础模型主要有四个特点:基于深度神经网络和自监督学习技术;采用大规模、广泛来源的数据集进行训练;通过微调等方式,可以直接在一系列下游任务上使用;参数规模越来越大。

- 基础模型包括多种预训练模型,如BERT、GPT-3、CLIP、DALL·E等。

定义

模型是人工智能算法在数据上进行训练后的产物。AI模型可以根据输入的数据进行推断,为人类提供决策的建议或依据。

一般的人工智能模型只能完成特定的任务,例如一个情感分类模型只能对输入的句子进行情感分类,而不能完成翻译、词性标注等任务。而基础模型(Foundation Models)指的是一类通用的,能够完成一系列下游任务的模型。由于这种模型是多种下游任务模型的“基础”,因此被称为基础模型。

《基础模型的机遇与风险》(On the Opportunities and Risks of Foundation Models)[1]一文中提出,近年来在AI领域可以看到一种范式转变——AI系统的构建越来越以一种通用的模型为基础,因此可以被称为是基础模型。

基础模型主要有以下特点:

1.基于深度神经网络和自监督学习,但不限于单一的一种架构:深度神经网络,意味着其于当前的传统深度学习模型“同宗同门”,在算法层面没有太大的差异。自监督学习技术,则让基础模型不需要太多的带标注数据——它可以不依赖标签就学习到数据集中的特征。

2.采用大规模、广泛来源的数据集进行训练,而不是小数据集、单一数据集或专用数据集:基础模型需要在大规模、广泛来源数据集上训练。这样才能够让模型具有更为通用的能力——只有看到的数据足够丰富多样,模型才能够应对多种情形。

3.通过微调、零样本学习等方式,可以直接在一系列(而不是单一一种)下游任务上使用,并取得一定的性能表现:微调指的是:在训练好基础模型后,让它学习很少量的单一领域或任务上的数据,使模型进行一定的调整,从而在下游任务(如情感分类、命名实体识别、翻译、语言理解等)中使用。零样本学习则是直接将模型应用于下游任务中,不再需要再学习一些数据。

4.参数规模越来越大:基础模型的参数规模逐年扩大,比传统的AI模型高很多个数量级。

基础模型这一概念由美国斯坦福大学基础模型研究中心(Center for Research on Foundation Models,CRFM)提出,主要研究者包括Percy Liang、李飞飞等。

基础模型包括预训练语言模型,如BERT、GPT-3等,以及多模态预训练语言模型,如CLIP、DALL·E等。[1]

基础模型带来的机遇和挑战

机遇

基础模型在语言、视觉、机器人、推理与检索、交互、理解等方面都具有发展的潜力。以语言为例,过去的NLP研究主要关注构建在特定任务(如翻译、情感分析、词性标注等)上的最佳模型。这使得NLP领域的模型种类繁多,但缺乏通用能力。而基础模型可以同时解决多种NLP问题,研究者可以更关注构建更为通用且综合性能更强的基础模型。在下游任务上,只需要给模型少量的标注数据,就可以获得比过去更强的性能。

基于基础模型,研究者和开发者可以构建各种下游应用,如医疗、法律、教育等方面的应用。

此外,由于基础模型仍处于快速发展的阶段,有一系列的技术领域需要探索。目前基础模型所涉及的技术子领域包括:模型的构建、训练、微调、评价、加速、数据、安全、稳健性、与人类的匹配(Alignment)、模型理论、可解释等。

挑战

在推动AI技术发展的同时,基础模型也带来了一系列社会层面的挑战。社会方面的挑战则包括不平等性、滥用、环境问题、法律问题、经济问题和伦理问题等。例如,在语言方面,基础模型可能会生成具有误导性、事实性错误的句子,甚至在推理过程中带有性别和种族歧视等问题。此外,基础模型由于学习了庞大的数据,其有可能将数据中的真实信息泄露出来,如家庭住址、信用卡账号密码,邮箱等。

参考链接

[1]Bommasani, R., Hudson, D. A., Adeli, E., Altman, R., Arora, S., von Arx, S., ... & Liang, P. (2021). On the opportunities and risks of foundation models. arXiv preprint arXiv:2108.07258.

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢