作者:Xavier Amatriain

来源:https://xamat.medium.com/transformers-models-an-introduction-and-catalogue-2022-edition-2d1e9039f376

整理:炼丹小生(炼丹笔记)

很多人的“记忆”并没那么好,特别是对名字。这些年各种各样的transformer涌现出来,各有各的优势,但是他们的名字却不能直白的看出该版本的transformer到底做了什么。这篇文章的目的就是把所有流行的transformer进行清晰简单的分类,以便大家对transformer家族快速梳理。

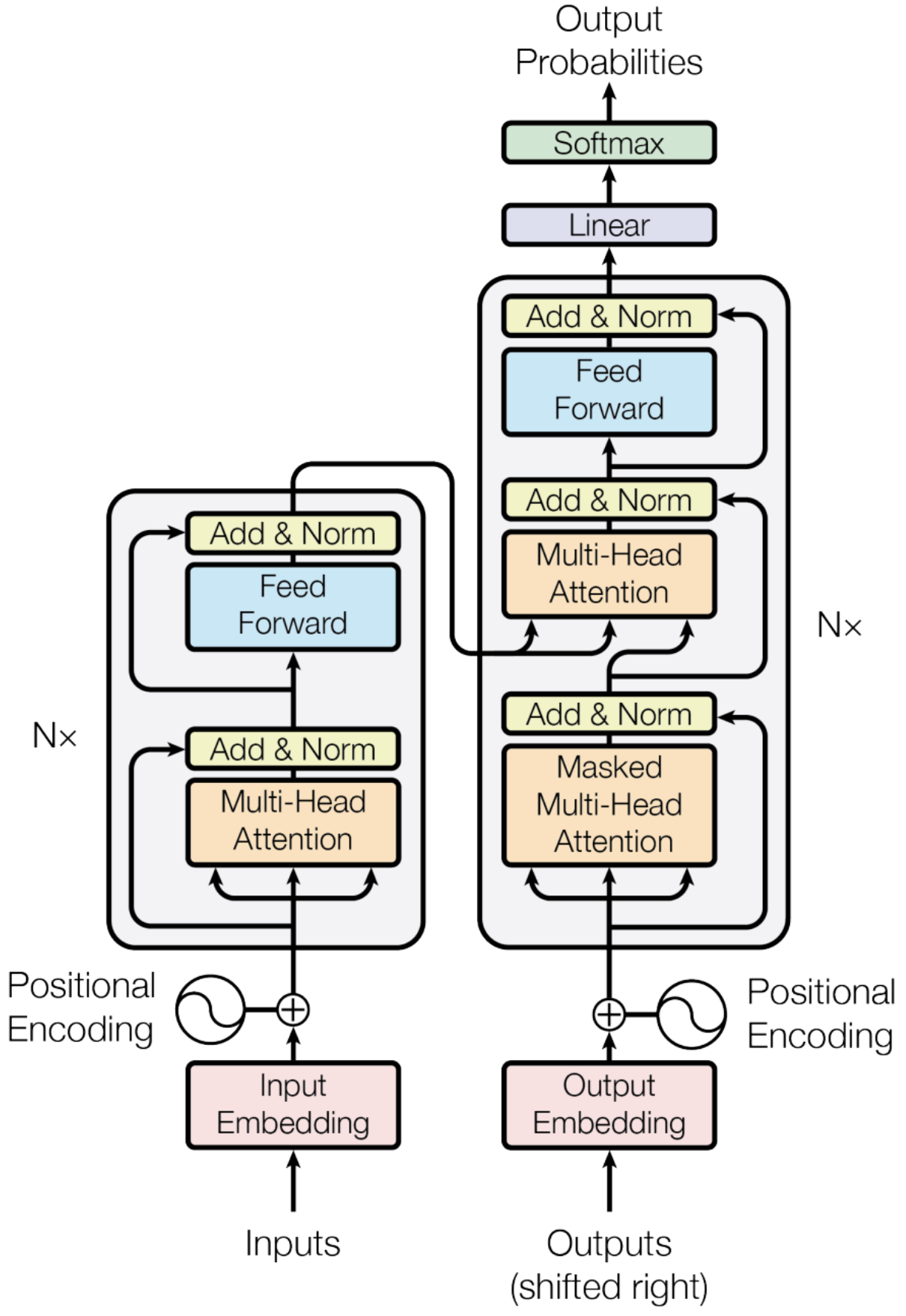

Transformer是什么就不用多说了,2017年开始至今引用量将近4w的论文<Attention is All you Need>(https://arxiv.org/abs/1706.03762)提出了一个encoder-decoder的模型取代了历年一直用的LSTM或者其他RNN,正如标题所述该论文最重要的就是Attention结构了。Transformer最基础的结构如下所示:

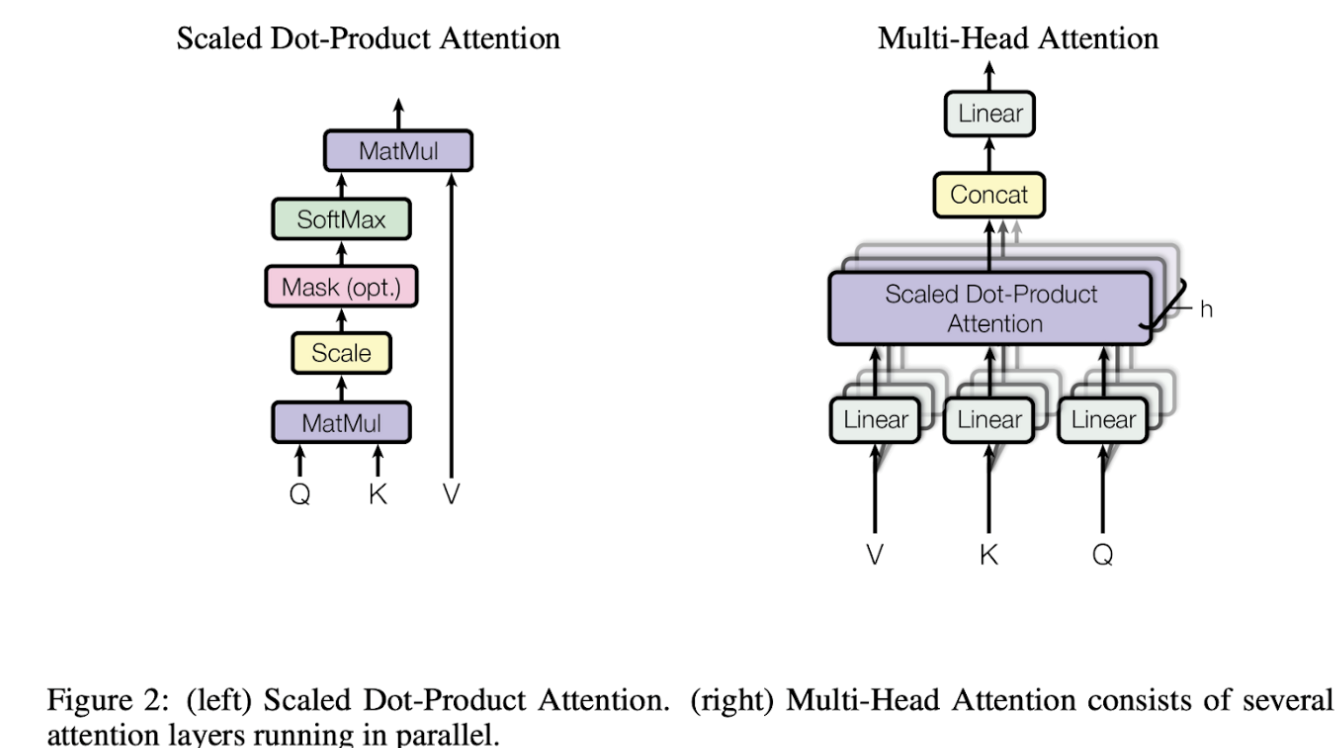

顺便温习一下最"核心"的multi-headed attention结构,该结构"匹配"query和key-value对,并且输出value的权重和,value的权重来自于query和key的attention值。Transformer结构使用了多头机制,并行计算特定的attention值,计算方式采用的是Scaled Dot-Product Attentio,如下图所示:

总结transformer主要由以下几个部分组成:

预训练架构: Encoder-Decoder

预训练任务:

-

Language Modeling(LM) 预测下个token

-

Masked Language Modeling(MLM) 完形填空

-

Permuted Language Modeling(PLM) 对句子做排列

-

Denoising Autoencoder(DAE): 句子中做随机采样,或者随机删除一些token,又或是打乱句子顺序,目标是恢复之前的输入

-

Contrastive Learning(CTL): 各种对比学习方法

应用:问答、情感分析、实体识别等.

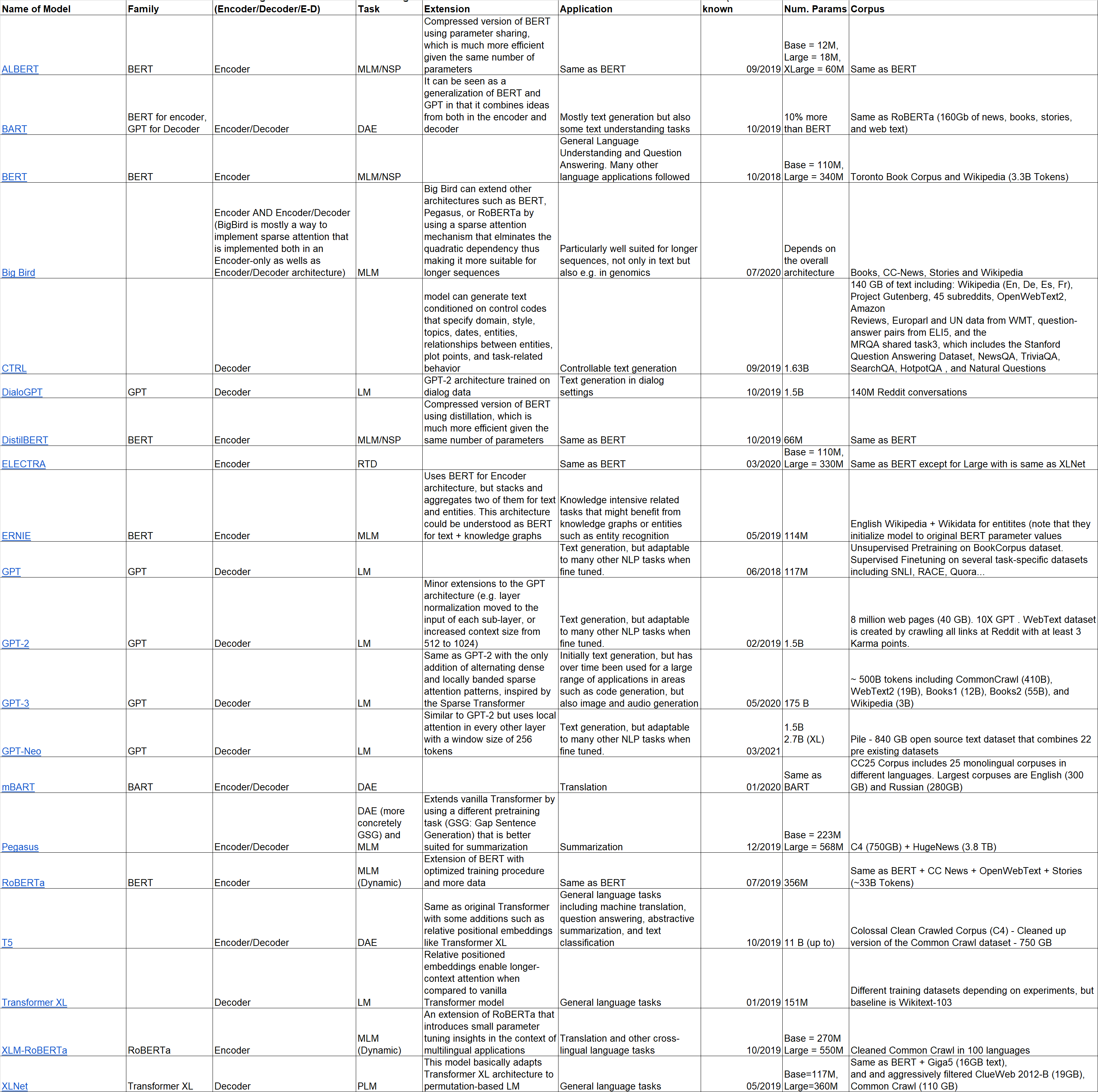

看不清点击图片查看高清大图,或者打开下方谷歌文档原文件地址:

https://docs.google.com/spreadsheets/d/1ltyrAB6BL29cOv2fSpNQnnq2vbX8UrHl47d7FkIf6t4/edit#gid=0

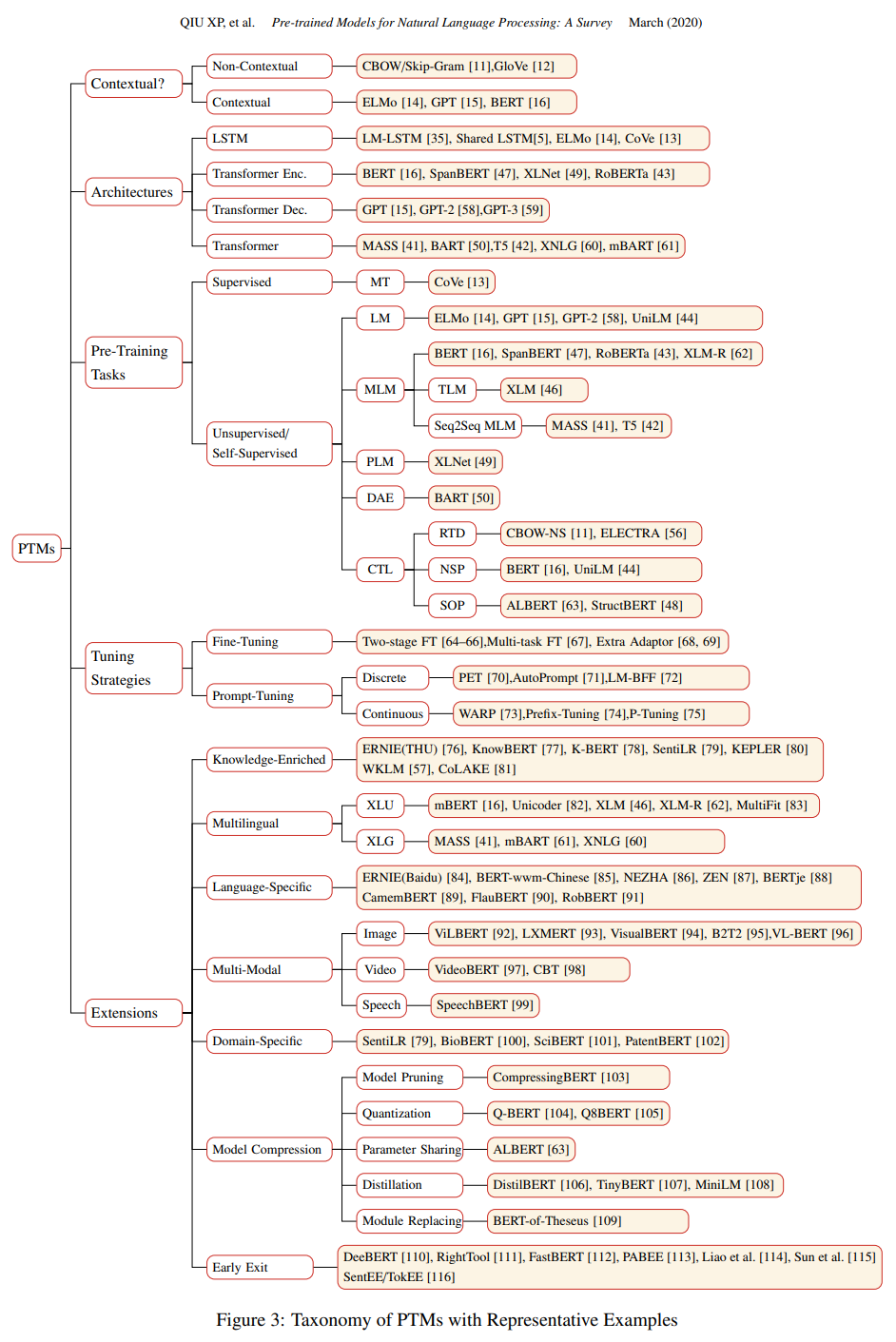

族谱

时间线(https://huggingface.co/course/chapter1/4)

其他资料及推荐阅读:

- Huggingface的Transformers电子书和课程:https://huggingface.co/course/chapter1/1?fw=pt

- Transformers的一份2021年综述:https://arxiv.org/abs/2106.04554(170 多个参考文献和完整的分类法)

- NLP预训练模型的综述:https://arxiv.org/pdf/2003.08271.pdf

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢