作者:Michihiro Yasunaga, Jure Leskovec, Percy Liang

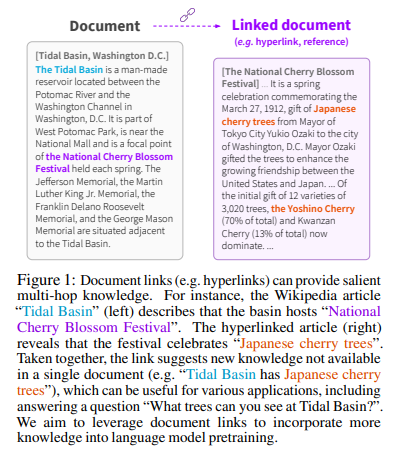

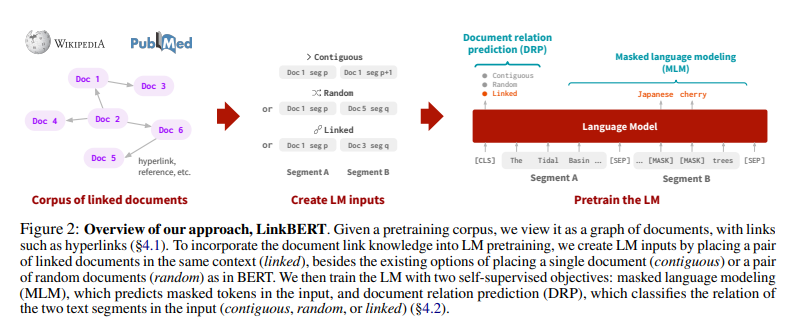

简介:本文研究通过文档链接突破BERT只能对单文档建模的议题。语言模型(LM)预训练可以从文本语料库中学习各种知识,帮助下游任务。但是,BERT 等现有方法对单个文档进行建模,并且不捕获跨文档的依赖关系或知识。在这项工作中,作者提出了 LinkBERT:一种利用了文档之间的链接(例如超链接)的 LM 预训练方法 。给定一个文本语料库,作者将其视为文档图,并通过将链接的文档放置在相同的上下文中来创建 LM 输入。然后,作者使用两个联合自我监督目标对 LM 进行预训练:(1)掩码语言建模、(2)作者新提议的文档关系预测。作者表明,LinkBERT 在跨两个领域的各种下游任务上优于 BERT:通用领域(在 Wikipedia 上使用超链接进行预训练)和生物医学领域(在 PubMed 上使用引文链接进行预训练)。LinkBERT 对于多跳推理和小样本 QA 尤其有效(HotpotQA 和 TriviaQA 的绝对改进提高了 5%),作者的生物医学 LinkBERT 在各种 BioNLP 任务上创造了新的技术水平(BioASQ 和 USMLE 提高了 7%)。

论文下载:https://arxiv.org/pdf/2203.15827.pdf

代码下载:https://github.com/michiyasunaga/LinkBERT

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢