主页:http://raywzy.com/Old_Film/

论文:https://arxiv.org/pdf/2203.17276.pdf

导读

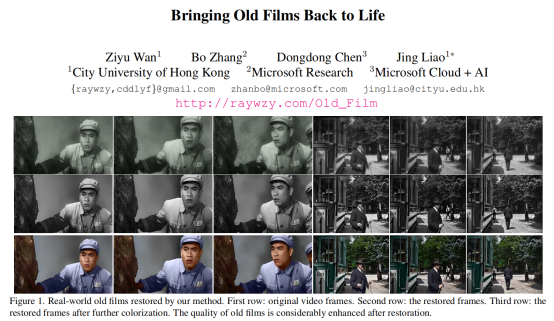

本文提出一个基于学习的框架——循环Transformer网络(RTN)以恢复严重退化的旧电影,RTN不会对每个视频帧执行恢复,而是利用相邻帧中的隐藏时间信息知识,建模视频序列中大量遮挡相关的信息以去除复原帧中的不真实伪影,同时确保输入、输出视频序列的时间一致性。此外,RTN以无监督的方式对当前帧的表示和隐藏的知识进行推断并定位帧中的划痕位置,该缺陷定位可以很好地应用于处理真实视频的退化。为了更好地解决混合退化并补偿帧对齐期间的流量估计误差,RTN利用更具表现力的transformer进行空间恢复。实验结果证实本文所提出的 RTN 相对于现有解决方案在性能、效率上具有显著优势。此外,这一框架可以有效地将颜色从关键帧传播到整个视频,最终产生令人愉悦的电影修复效果。

贡献

许多经典电影至今仍能够引起广大年龄段观众的共鸣和思考,然而,由于当时拍摄条件的限制,大部分经典电影的视觉效果都不如新电影一般引人入胜。此外,由于老电影保存过程中出现的胶卷老化等问题,经典电影中经常出现低分辨率和随机伪影的问题。

进来,电影修复技术提出以使老电影能够得到新的视觉效果。然而,这一系列技术仍具有较大的局限性,这是因为现在的修复都是数字化操作,需要艺术家们仔细检查每一帧,手工修饰瑕疵、修复闪烁、逐帧上色,使得整部旧胶片的修复会带来了难以承担的费用。 因此,人们希望有一种算法能够自动执行所有这些繁琐的任务,从而使旧电影能够以现代风格重现。

经典电影通常会受到多种退化现象的影响,但目前只有少数研究旨在解决这一问题。最近,文献[45, 52]提出了高阶退化模型来表征电影在真实场景下的退化,但这些工作主要考虑光度退化,例如模糊、噪声,而不是结构化缺陷(划痕、裂缝等)。文献[40]试图解决老式照片中的复杂退化问题,但它对旧电影的逐帧处理并不能确保输出视频的时序紧密性。相比之下,DeepRemaster [17] 以视频恢复和着色为目标,但这项工作无法充分利用具有显式帧对齐的时间信息和具有远程相关性的空间信息,因此无法修复大的裂缝区域。

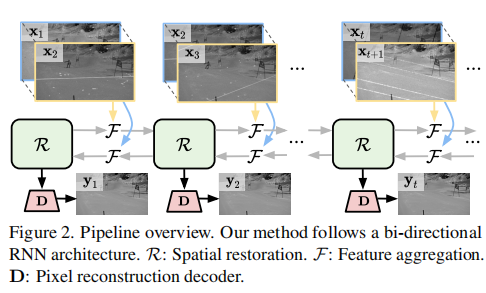

在这项工作中,作者们寻求将电影修复任务与时空修复任务的单一框架进行结合,主要动机可以阐述为:旧电影中的大多数退化,尤其是结构化缺陷,都是随时间变化的,即在一帧中被遮挡的结构化缺陷可能会在连续帧中显示其内容。因此,作者建议通过利用图2所示的时空上下文而不是依赖幻觉(hallucination)来修复退化。

本文的主要贡献可以总结如下:

- 提出了一种双向的循环神经网络进行经典电影中每帧的时空上下文信息;

- 将Transformer模块与该双向循环神经网络进行了结合,并实现了较好的任务扩展性;

- 在多个数据集上取得了SOTA的性能。

方法

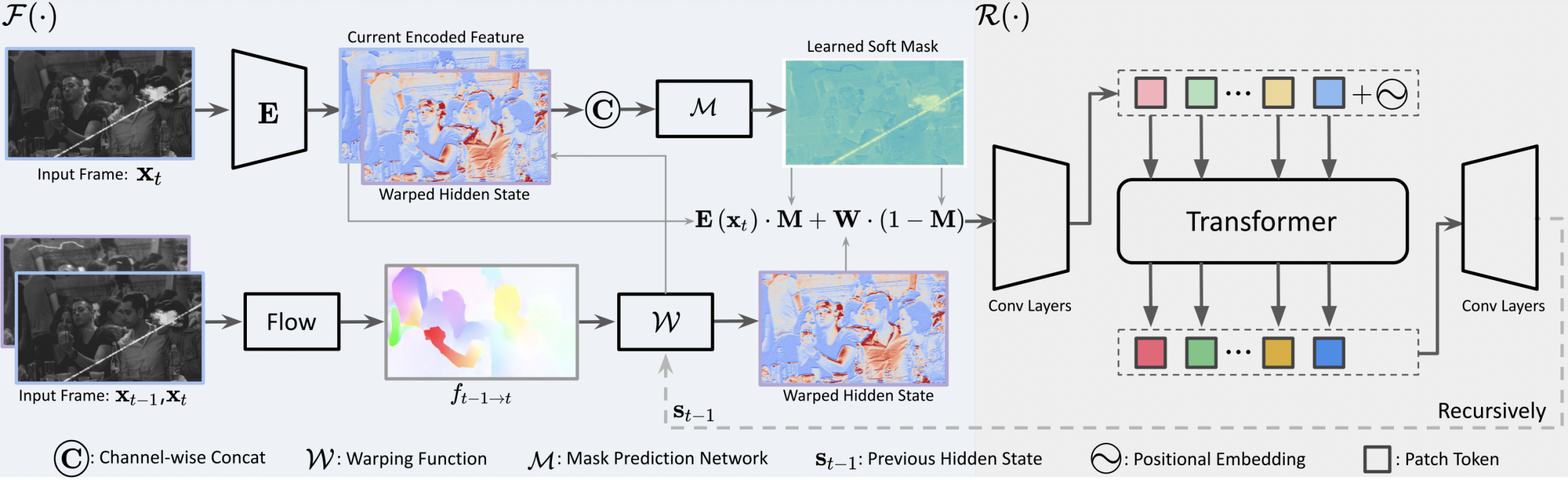

如上图所示,RTN的主要模块包括时域叠加模块F与空域修复模块R。

时域叠加模块

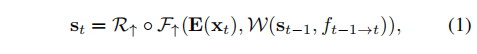

给定在t时刻的两个视频帧xt-1与xt,它们之间的光流f可以通过诸多算法进行评估以建模时域信息。接着,xt-1对应的隐状态(hidden state,这一概念来自于循环神经网络的机制)st-1可以通过映射函数W对齐至当前时刻的隐状态st:

其中E负责将视频帧映射为深度特征,F负责将隐状态进行叠加,R负责进一步提炼st。在上式中,当前帧xt只与历史帧进行了联立,而实际上,它与未来帧xt+1之间的时域联系同样可以进行建模:

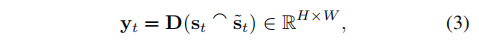

前、后两种时域联系接着可以拼接在一起进行当前帧的解码及修复:

空域修复模块

在上一步骤中,RTN对双向时域信息进行了建模,这不可避免地会带来一定的计算损耗和误差。因此,作者接下来提出使用一种轻量化的Transformer模块进行当前帧的解码及修复。

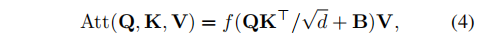

这一Transformer模块与Swin Transformer模块类似,均采用了基于窗口的注意力机制。给定特征h,它首先通过步长为2的卷积操作将空间尺寸减半,接着计算注意力机制:

损失函数

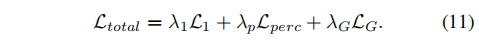

RTN的损失函数共由三部分组成:

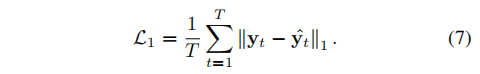

上式中,三个超参数分别为1.0、1.0、0.01。其中L1负责在LAB空间中计算当前帧xt的复原效果:

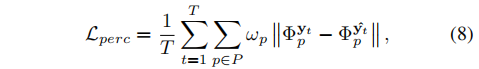

第二项代表感知损失函数:

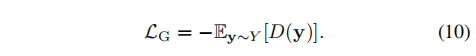

第三项通过具有3D卷积的判别器计算对抗损失:

实验

本文主要在REDS数据集上进行实验对比。

定量对比

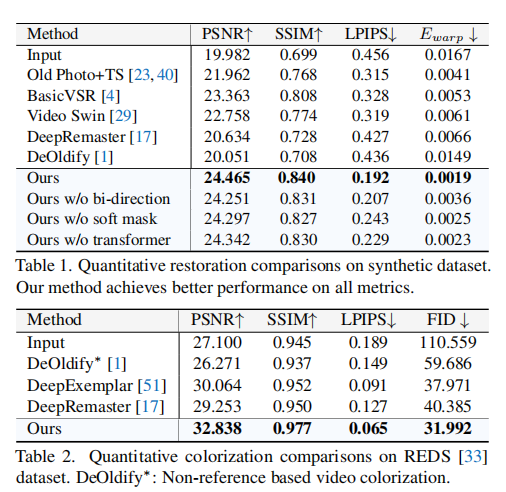

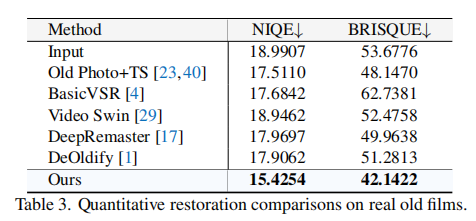

定量实验使用到了多种指标函数:具有参照的PSNR、SSIM指标,无参照的LPIPS、Ewarp指标等。主要实验结果如下表所示,不难看出,RTN在合成的数据集、真实数据集上均取得了一流的性能。

定性对比

定性实验主要包括两部分,首先是对真实的经典电影进行修复,其效果如下图所示。

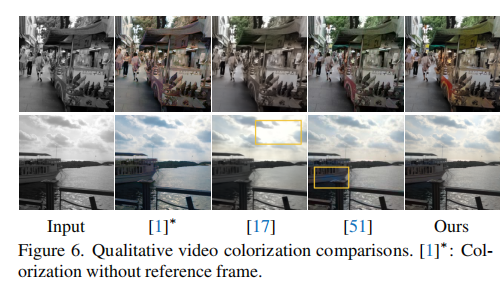

第二部分定性实验针对的是将RTN用于视频着色任务。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢