【标题】Visual-Tactile Multimodality for Following Deformable Linear Objects Using Reinforcement Learning

【作者团队】Leszek Pecyna, Siyuan Dong, Shan Luo

【发表日期】2022.3.31

【论文链接】https://arxiv.org/pdf/2204.00117.pdf

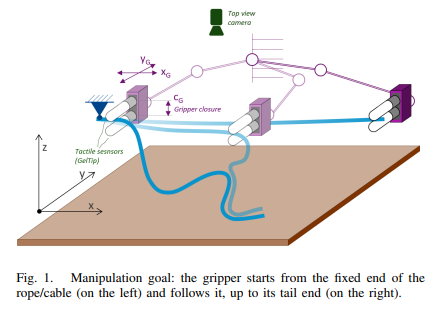

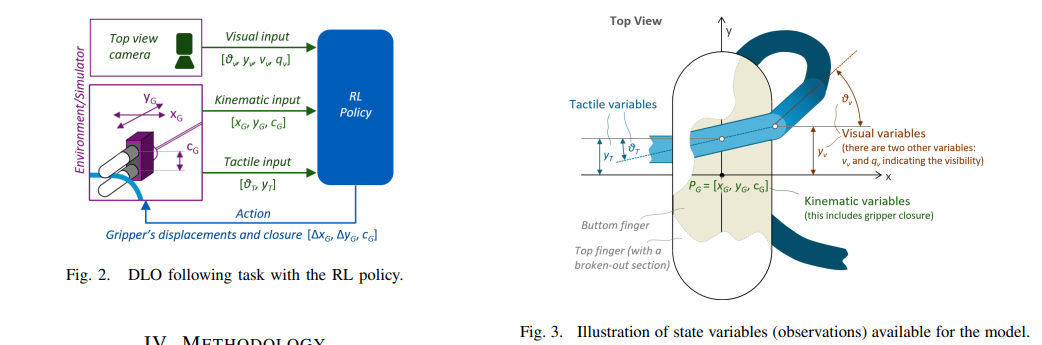

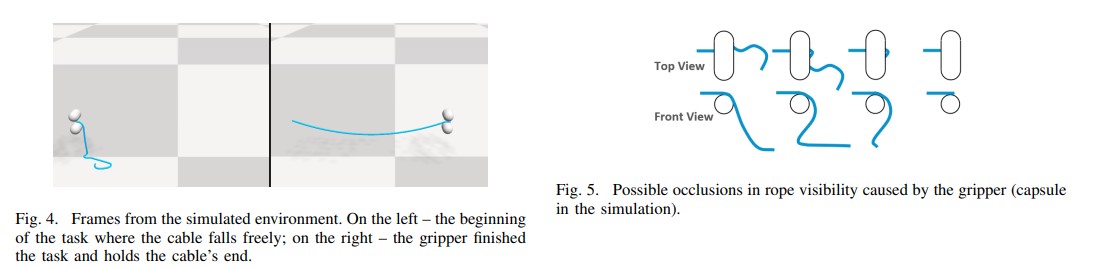

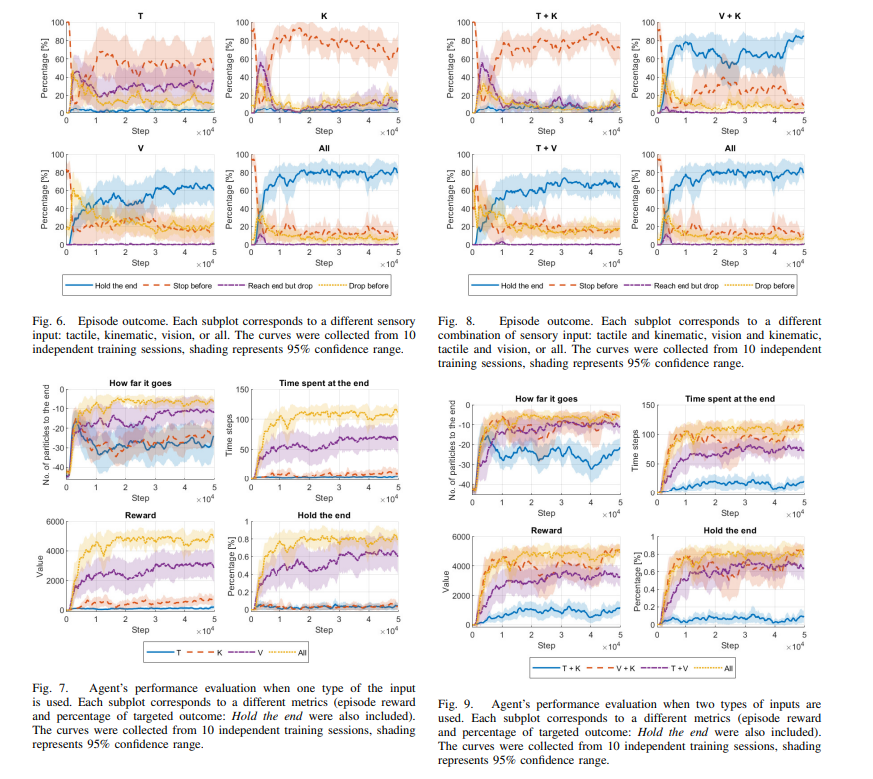

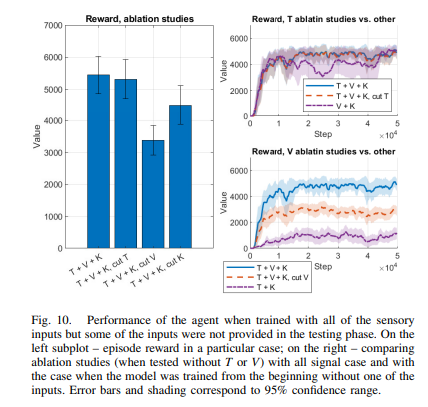

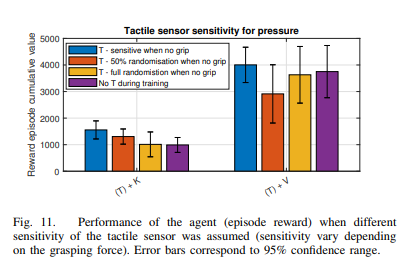

【推荐理由】对机器人来说,操纵可变形物体是一项具有挑战性的任务。使用单一感官输入来跟踪这类物体的行为是有问题的:视觉可能会受到遮挡,而触觉输入无法捕捉对任务有用的全局信息。其首次研究了视觉和触觉输入来完成跟踪可变形线性物体的问题。本文使用不同感知模式的强化学习代理,并研究了与使用单一感知模式相比,如何使用视觉-触觉融合来增强其行为。提出了模拟基准,用于使用多模态传感输入操纵可变形线性对象。智能体的策略使用炼的信息,在视觉和触觉视角下的对象姿势,而不是原始的感知信号,因此可以将其直接传输到真实环境中。其将感知系统和学习的控制策略分离开来。通过大量实验表明,使用视觉和触觉输入,再加上本体感觉,可以让智能体在高达92%的情况下完成任务,而只有一个信号时,这一比例为77%。本文的研究结果可以为未来触觉传感器的设计和可变形物体的操纵提供有价值的见解。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢