作者:Hongyi Yuan, Zheng Yuan, Ruyi Gan,等

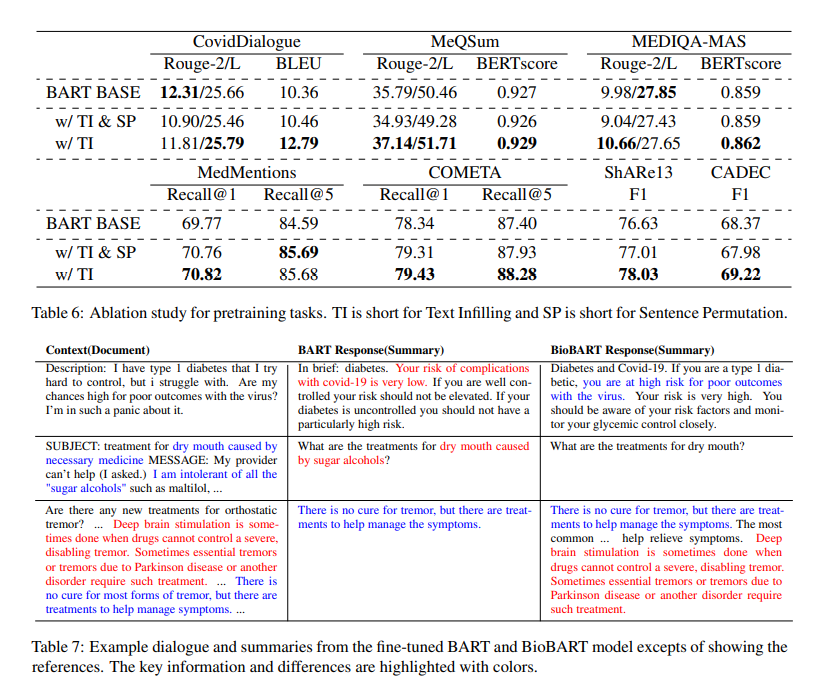

简介:本文将BART模型引入在生物医学领域(domain adaption)的研究。预训练的语言模型已成为自然语言处理的重要支柱。最近,专业域内预训练已被证明有益于各种特定领域的下游任务。在生物医学领域,自然语言生成 (NLG) 任务至关重要,但尚未得到充分研究。将自然语言理解任务作为 NLG 通过受约束的语言生成或语言提示在一般领域实现令人满意的性能。作者强调生物医学领域缺乏域内生成语言模型和不系统的生成下游基准,阻碍了研究界的发展。在这项工作中,作者提出:通过以 BART 适应生物医学领域的生成语言模型 BioBART。作者整理了各种生物医学语言生成任务,包括对话、摘要、实体链接和命名实体识别。与 BART 相比,在 PubMed 摘要上进行预训练的 BioBART 具有更高的性能,并在多个任务上设置了强大的基线。此外,作者对 BioBART 的预训练任务进行消融研究并发现句子排列对下游任务有负面影响。

论文下载:https://arxiv.org/pdf/2204.03905.pdf

源码下载:https://github.com/GanjinZero/BioBART

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢