作者:Zhiyi Fu, Wangchunshu Zhou, Jingjing Xu,等

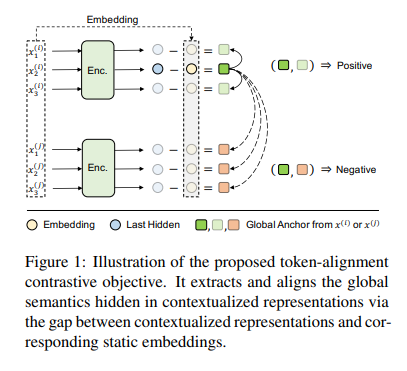

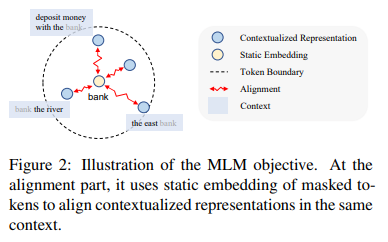

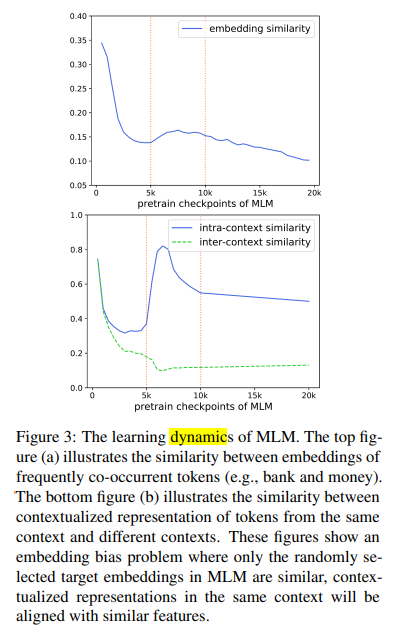

简介:本文研究以建模全局语义的方法通过BERT等预训练模型的限制。像BERT 这样的掩码语言模型(MLM)是如何学习上下文表示的?在这项工作中,通过聚焦分析MLM上下文表示学习的动态信息,作者发现:MLM采用采样嵌入作为锚来估计并向表示注入上下文语义,这限制了MLM的效率和有效性。为了解决这些问题,作者提出了一种简单而有效的表示学习方法TACO(Token-Alignment Contrastive Objective),来直接建模全局语义。TACO提取并对齐隐藏在上下文化表示中的上下文语义,以鼓励模型在生成上下文化表示时关注全局语义。在GLUE基准上的实验表明,与现有MLM相比,TACO实现了高达5倍的加速,平均提高了1.2个点。

论文下载:https://arxiv.org/pdf/2204.04163

代码下载:https://github.com/FUZHIYI/TACO

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢