标题:斯坦福|BUILD A ROBUST QA SYSTEM WITH TRANSFORMER-BASED MIXTURE OF EXPERTS(建立一个基于专家混合变换器的健壮对话系统)

作者:Yu Qing Zhou, Xixuan Julie Liu, Yuanzhe Dong

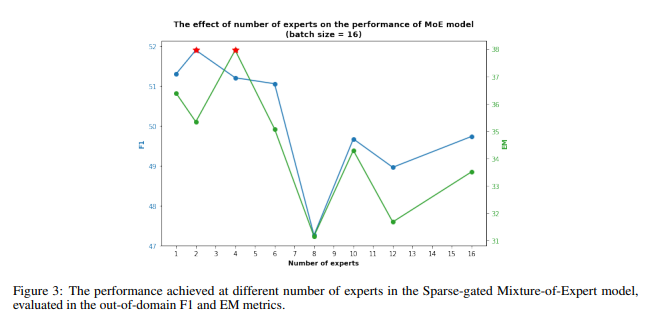

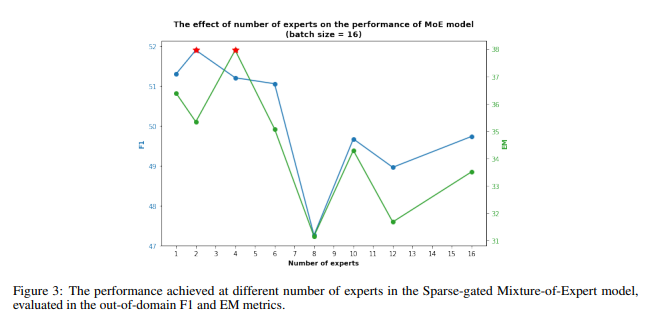

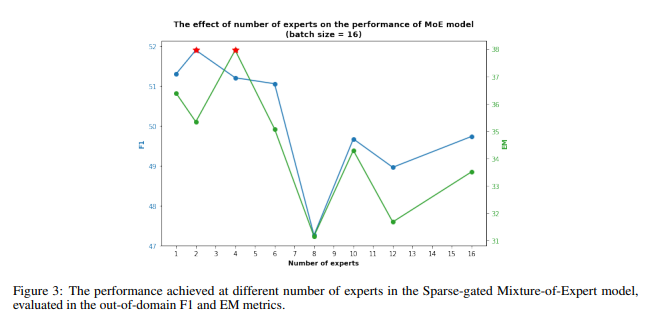

简介:本文提出一种对话建模方法。在本文中,作者的目标是构建一个能够适应域外的健壮问答系统数据集。单个网络可能会过度拟合训练分布中的表面相关性,混合专家 (MoE) 模型允许作者训练一个可以泛化到域外数据集的多任务学习器。作者还探索了将 MoE 层带到中间的可能性DistilBERT并用稀疏激活的开关 FFN 替换密集前馈网络层,类似于Switch Transformer架构,它简化了 MoE 路由算法减少通信和计算成本。除了模型架构,作者还探索数据增强技术,包括简易数据增强和反向翻译,以在小的域外训练数据之间创造更有意义的差异,从而提升作者模型的性能和稳健性。在本文中,作者展示了作者的最佳组合架构和数据增强技术在域外实现了53.477的F1分数评估,这比基线提高了9.52%。在最终的测试集上,作者报告了一个更高的 59.506的F1和41.651的EM。作者成功证明了Robust QA 任务中的架构混合专家的有效性。

论文地址:https://arxiv.org/pdf/2204.09598.pdf

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢