标题:伯克利、三星|A Fast Post-Training Pruning Framework for Transformers(一个快速的训练后变换器修剪框架)

作者:Woosuk Kwon, Sehoon Kim, Amir Gholami等

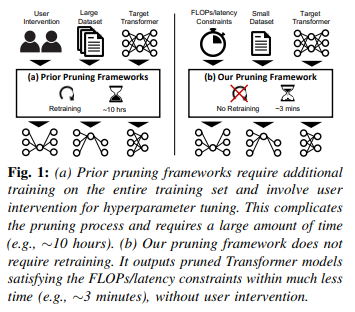

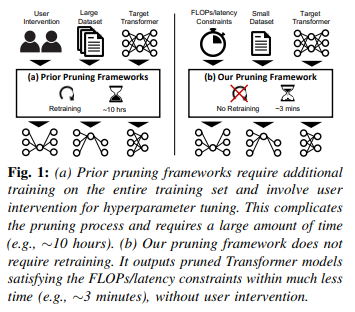

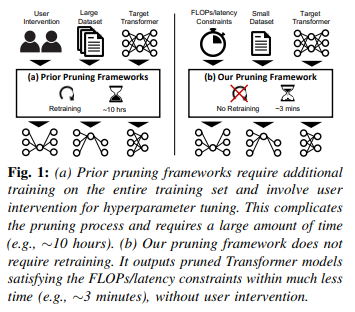

简介:本文介绍了一种推理加速方法。修剪是一种有效的减少大型 Transformer 模型的巨大推理成本。然而,先前关于模型修剪的工作需要重新训练该模型。这可能会增加高成本和模型部署复杂性,使其难以在许多情况下使用实际情况。为了解决这个问题,作者提出了一个用于变换器的快速训练后修剪框架,不需要任何再训练。给定资源限制和一个样本数据集,作者的框架会自动修剪使用结构化稀疏方法的变换器模型。到在不重新训练的情况下保持高精度,作者介绍三个新技术:(i)轻量级掩码搜索算法根据Fisher信息; (ii) 掩码重排补充搜索算法; (iii) 掩模调整重建每一层的输出激活。作者对 BERTBASE 和 DistilBERT 应用此方法,作者评估它在GLUE 和 SQuAD 基准测试中的有效性。作者的框架实现了高达2.0倍的FLOP节省和推理延迟提高1.56 倍,同时保持精度损失<1%。重要的是,作者的变换器框架修剪在单个GPU上不到 3 分钟,这比现有的重新训练的修剪方法快两个数量级以上。

论文下载:https://arxiv.org/pdf/2204.09656.pdf

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢