关于首个大规模桌面物体数据集TO_Scene,从产品设计逻辑到团队背景,你想知道的一切都在这里,或许能帮助你正在进行的算法训练,提高模型3D语义分割和对象检测任务质量。

做人工智能的都知道,算法训练离不开数据集,斯坦福李飞飞老师的ImageNet驱动图像领域快速发展;ScanNet在三维视觉领域也带动了不少经典算法的产生;而在更为垂直的桌面物体数据领域,TO_Scene算是一批黑马,构建了首个大规模三维桌面物体数据集,对ScanNet缺失的桌面物体数据进行了补充。那么它的诞生过程是怎样的?为此整数智能采访了TO_Scene团队,对产品设计逻辑进行了更为深入的了解。

首先我们需要了解TO_Scene具体是什么,它是一个大规模的三维桌面物体数据集,共计20,740 多桌面场景,52个小物体类别,平均每个桌面摆放了约10个物体,包含台灯、碗、杯子、鼠标、耳机等真实桌面会放置的物体模型,可支持室内三维场景全尺度全方位物体检测和分割任务。由香港中文大学(深圳)助理教授韩晓光所带领的GAP-Lab团队推出。

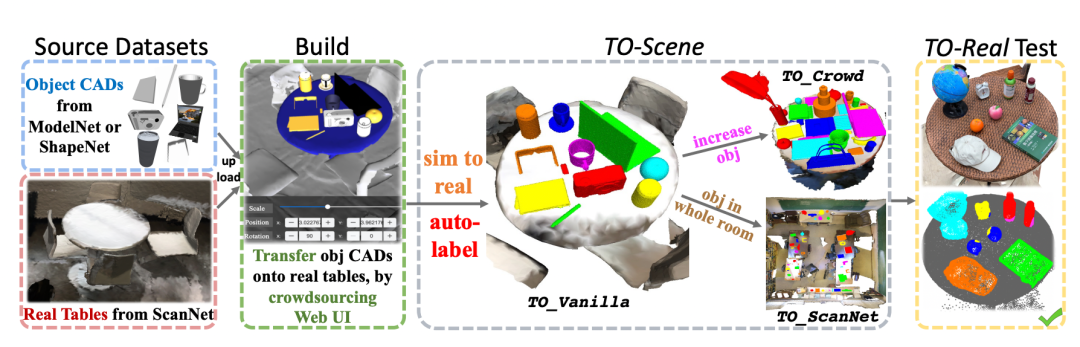

注:TO_Scene数据集概览

“人工智能这么多年的发展告诉我们一个事实,数据集是非常重要的。”在 3D 室内场景解析应用中,理解桌面场景必不可少,韩晓光团队在研究中发现,目前在业界,3D 数据集中很少有关于小物体的数据集,哪怕最经典的3D据集ScanNet也只是专注在桌子、椅子等大物体,而桌面、床头、茶几或者厨房台面上基本都很空,这和我们真实生活的场景区别较大,这引起了韩晓光的兴趣。他调研过后发现,目前很少有团队去研究桌面三维场景,即便有,数据集规模也非常小,所以韩晓光当时下定决心做一个相对大规模的数据集,但是如何操作?

· 物体怎么来的问题:可以通过ShapeNet和ModelNet这两个专门的物体模型的数据集获取;

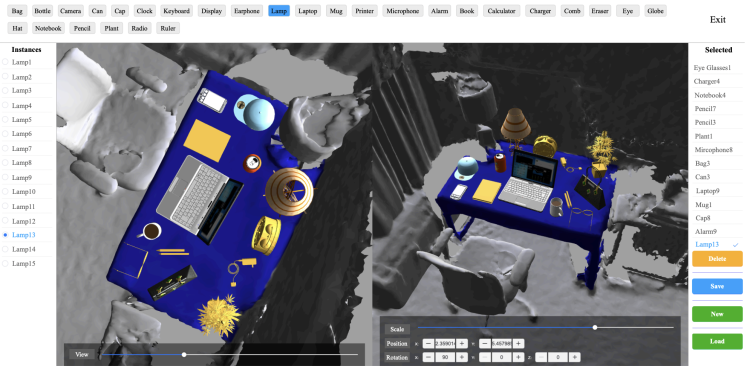

· 怎么摆的问题:一个比较好的方式是设计一个交互的UI界面,以方便合作伙伴整数智能「提供人工智能数据服务的公司」将从ShapeNet和ModelNet数据集里找到的模型放到从在ScanNet数据集里找到的桌面上,但是物品也不能乱放置,标注员(由整数智能提供)需要根据自己的经验和逻辑去判断该放置在什么地方。

注:方便标注员放置模型的交互界面

· 整洁的家:床头柜上就有只有一盏台灯、一个遥控器,或者一本书;

· 杂乱的家:在这种场景下,都是毫无逻辑的物品混杂,比如床头柜上会将碗筷和其他东西搁在一起。

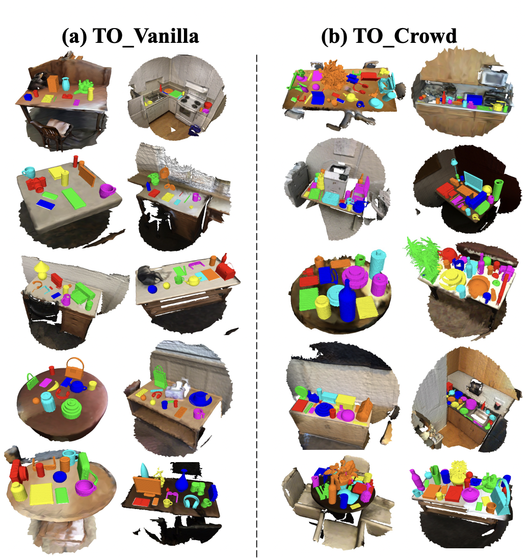

整洁的和混杂拥挤的数据标注,难度差别很大。一旦拥挤,采集到的数据遮挡会变的严重,而且点云就会缺失很多,对于理解更具有挑战性。所以,韩晓光团队除了设计了一个满足基本场景的TO_Vanilla数据集,还增加了一个更为复杂的、可能不遵循任何逻辑的TO_Crowd数据集。

注:两组合成的数据集TO_Vanilla及TO_Crowd

然而,考虑到TO_Vanilla及TO_Crowd这两个都是数据集来自模型的数据,是合成的场景而非我们真实的生活场景,韩晓光教授当时想,如何证明在合成场景训练的模型也可以适用于真实场景呢?解决办法就是用合成数据集去训练模型,用真实数据集去测试数据集。

TO_Real这个真实采集的三维桌面物体数据集的角色,就是测试TO_Scene的真实价值,为此韩晓光教授团队也同时采集了100多个真实的桌面场景。

因为三维物体标注比较垂直,市面上很难直接找到现有的数据标注平台提供相应的服务,毕竟这类标注平台的需求非常细分,整数智能做了长期的数据标注服务,也只碰上了这一个科研项目需要这样特殊的标注工具,而如果采用动辙几个G的专业桌面软件,会非常不方便且拖慢项目进度。

在了解韩晓光团队的需求以后,整数智能认为,既然TO_Real对TO_Scene如此重要,不妨为韩晓光团队定制化专门的三维实物标注服务。决定开发以后,整数智能研发人员决定全情投入,为这个能推动桌面数据集发展的项目尽可能做力所能及的任何事。

本次合作中,整数智能提供了专业的标注团队以及部分标注工具,帮助韩晓光团队完成了数据集TO_Scene中的数据处理工作。

注:整数智能为TO_Real提供专业的数据标注服务

在放三维物体的过程中牵出一个问题:桌面上到底要放多少物体才能让训练出来的模型更精准,又更贴合现实场景?这里To_Scene团队和数据服务商的合作有一个很有意思的化学反应,会互相基于对方的专业度会提出更为复杂的研究。

最开始韩晓光团队本来只想放置6个物体,但是在和整数智能合作的过程当中,团队发现原来整数智能的数据标注服务可以做到超出预期的程度,不仅能定制化上面所提及的三维标注工具,且标注员配合程度又非常高,交付效率、数据质量及团队专业度是其他数据服务所不能比的,基于这种信任,韩晓光团队就提出将放置的物体数量再增加到十个左右,给训练更加精确的模型以更多可能性。

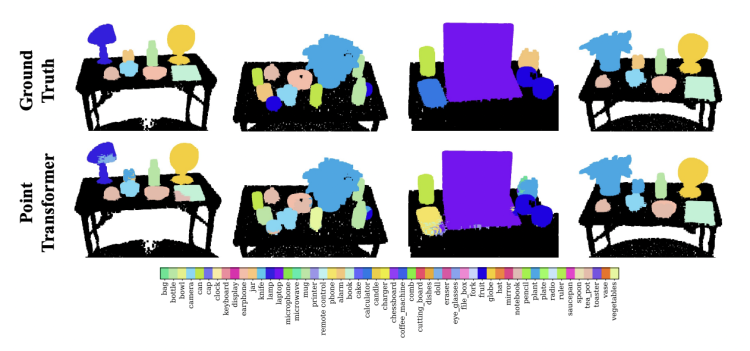

测试下来后发现,在 TO-Scene 上训练的算法确实适用于真实的测试数据,而韩晓光团队的提出的桌面感知学习策略大大提高了最新技术 3D 语义分割和对象检测任务的结果。

注:TO_Real上的3D语义分割测试结果

在计算机视觉里有一种非常经典的做法,就是将公开数据集用于测试,而非公开的数据集用于训练,且非公开类数据集有一个线上评估系统,提交完毕后就会产生一个相应的榜单,以方便大家进行评估。像ScanNet上就会有这类榜单推动一些经典算法的发展,比如用于语义分割的 PointConv,KPConv, FPConv 等,以及用于检测的VoteNet等经典算法。

未来TO_Scene也有做榜单的打算,以方便AI科研人员或从业者人去TO_Scene的评测系统里去评测算法。另外,TO_Scene场景、 TO-Real 以及 Web UI 都将公开可用。

在采访最后,韩晓光教授表示,做科研的人除了关心学术上的贡献,也会希望自己的研究能为产业做一些前沿探索。“TO_Scene比较理想的应用也许会在智能家居领域,比如服务机器人能实时感知桌子椅子在什么地方,桌面上有什么物体。” 或许在将来某一天,在TO_Scene的推动下,我们真的可以宅家只负责撸猫打游戏,刷碗擦桌子取耳机之类的琐事,机器人帮忙解决。

期待TO_Scene可以帮助到更多模型训练,解放更多人类劳动力,去做更有意义的事。

韩晓光博士,香港中文大学(深圳)理工学院与未来智联网络研究院助理教授,校长青年学者,同时兼任深圳市大数据研究院研究科学家。他于2017年获得香港大学计算机科学专业博士学位。研究方向包括计算机视觉和计算机图形学等,在该方向著名国际期刊和会议发表论文40余篇,包括顶级会议和期刊SIGGRAPH(Asia), CVPR, ICCV, ECCV, NeurIPS, ACM TOG, IEEE TPAMI等。他获得2021年度吴文俊人工智能科学技术奖-优秀青年奖,他的工作还曾获得CCF图形开源数据集奖(DeepFashion3D),2019年和2020年连续两年入选计算机视觉顶级会议CVPR最佳论文列表(入选率分别为0.8%和0.4%),IEEE VR 2021 最佳论文荣誉提名, 计算机图形学顶级会议Siggraph Asia 2013新兴技术最佳演示奖。

更多细节详见

https://mypage.cuhk.edu.cn/academics/hanxiaoguang/

上述TO_Scene提到,整数智能的数据标注服务可以做到超出预期的程度,不仅研发人员能定制韩晓光团队所需要的三维标注工具,且标注员配合程度又非常高,交付效率、数据质量及团队专业度是其他数据服务所不能比的,以至于在项目推进过程中,会提出更为复杂的需求。

其实在以往的合作过程中,合作伙伴对整数智能也不乏「高效、专业」这样的评价,而这样的高效专业背后,不仅是团队始终如一的站在需求方角度思考问题,还有整数智能的技术实力在发挥作用。

除了便利的数据标注平台,整数智能还自研AI辅助工具以提高数据生产效率,包括光流跟踪算法、OCR预标注系统、ASR辅助音频采集等,能节省大量的人力标注时间与复核成本。

另外,整数智能标注平台可以通过多终端无缝连接,全场景满足用户需求,可对质量进行灵活抽查、动态分阶段验收,帮助AI企业随时把控数据标注质量及进度,保证信息的同步性,让数据真正可靠可控。不仅如此,为提高数据集的交付质量,整数智能对数据生产全过程实现了全方位的质量把控。在人员管理方面,涉及到数据生命周期的各级人员都参与到质量管理中,确保经手数据的每一方都能严控质量。

也正因为持续的技术能力和行业积淀,让整数智能成为了人工智能产业联盟的产业数据组专家,共同参与制定AI行业的数据标准和白皮书工作,得到中国电子技术标准化研究院和信通院的邀请参编SC42《可信赖人工智能标准化白皮书》与《人工智能研发运营一体化(Model/MLOps)能力成熟度模型》标准体系。参与制定包括过程管理、模型管理、安全与风险管理、组织结构、系统与工具等5个能力标准,致力于帮助企业提高AI研发运营管理能力,提升AI模型治理能力,为AI大规模应用提供有效路径。参与制定的TC260《AI数据采集及标注安全规范》,聚焦AI数据采集及标注过程及过程中可能出现的安全隐患,提炼、梳理相关安全技术。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢