论文:https://arxiv.org/abs/2203.04121

代码:https://github.com/StevenShaw1999/RSSA

导读

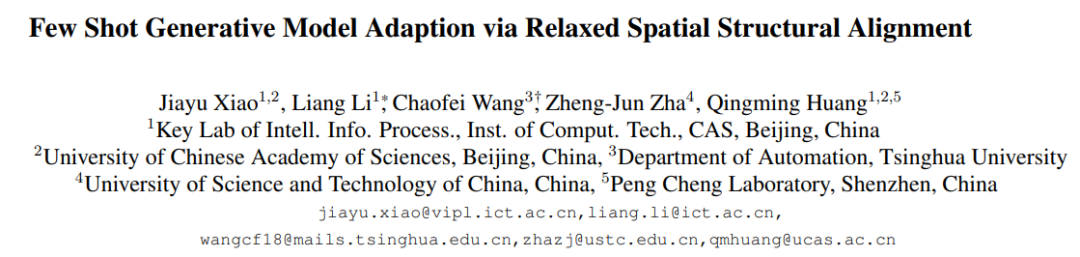

使用有限的数据训练生成式对抗网络(GAN)一直是一项具有挑战性的任务。目前,一种可行的解决方案是从在大规模源域上经过预训练的GAN作为基础,使用少量目标域样本来实现自适应迁移,这一做法被研究人员称为小样本生成的模型自适应。然而,现有的方法在极少的源域样本(小于10)设定下容易出现模型过拟合和崩溃问题。为了解决这一问题,本文提出了一种松弛的空间结构对齐(RSSA)方法来在自适应过程中校准生成模型。具体来说,本文设计了一种由自相关和干扰相关一致性组成的跨域空间结构一致性损失,它有助于对齐源域和目标域合成图像之间的空间结构信息。为了放松跨域对齐,RSSA将生成模型的原始潜在空间压缩到一个子空间,并使从子空间中生成的图像对距离更近。定性和定量实验表明,RSSA在小样本设定下始终超过了最先进的方法。

贡献

给定有限的训练样本,生成模型通常容易过拟合。一个简单有效的解决方案就是将大规模预训练的模型适配到包含少量数据的目标域上,然而,现有方法在给定及其少量样本(少于10)的时候,容易发生过拟合和模式崩塌现象。另一个方案是对训练数据进行数据增强从而提升模型的鲁棒性,然而这类方法通常也只适用于训练数据大于100的场景。

CVPR2021提出的CDC迁移方法,通过实例距离间的一致性损失,保留源域和目标域之间的相对相似度和不相似度。通过KL距离对源域生成样本的多样性适配到目标域生成样本,从而提升小样本场景下的生成多样性。然而,CDC方法仍然存在identity degredation和unnatural distortions的问题,就是说,生成的图片不能保留好的结构信息,图像中的实体或目标会在结构上发生形变,导致目标域生成样本还是存在一定偏差。因此,本文提出RSSA,利用源域样本中的丰富空间结构信息来解决上面的两个问题。

RSSA将源域丰富的结构信息适配到目标域,通过跨域空间结构一致性损失实现,具体包括两项,一个是自相关一致性损失(self-correlation consistency loss),另一个是扰动相关一致性损失(disturbance correlation consistenty loss),前者对于目标域生成器和源域生成器生成的样本对进行约束,控制其对结构信息的学习,后者有助于对齐潜在空间中相邻样本之间的空间互相关性,以约束目标域生成器对特定实例的变化趋势的一致性。

此外,直接利用跨域空间结构一致性损失将源域适配到目标域,可能会导致源域的结构主宰生成结构,且减缓模型的收敛。因此,本文进一步提出将隐空间压缩到一个子空间,子空间与target domain更靠近,这样能够让子空间中生成的样本更靠近彼此,避免将源域全部的结构迁移到目标域。

本文的主要贡献可以总结如下:

- 提出了一种松弛的空间结构对齐方法RSSA,将源域丰富的空间结构信息转移到小样本的目标域,具有更好的模型泛化性;

- 引入潜在空间压缩,通过拉动由压缩子空间产生的合成对来放松跨域对齐,并加速训练过程;

- 设计了一个度量标准从结构的角度来评估合成图像的质量,这可以作为当前度量标准的替代补充。在定性和定量上,我们的方法在各种情况下都优于现有的竞争对手。

方法

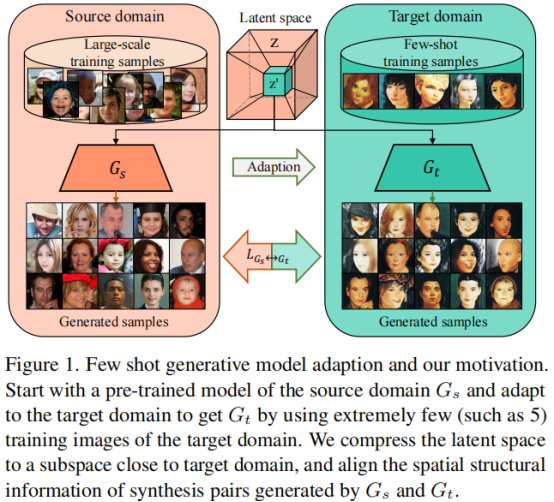

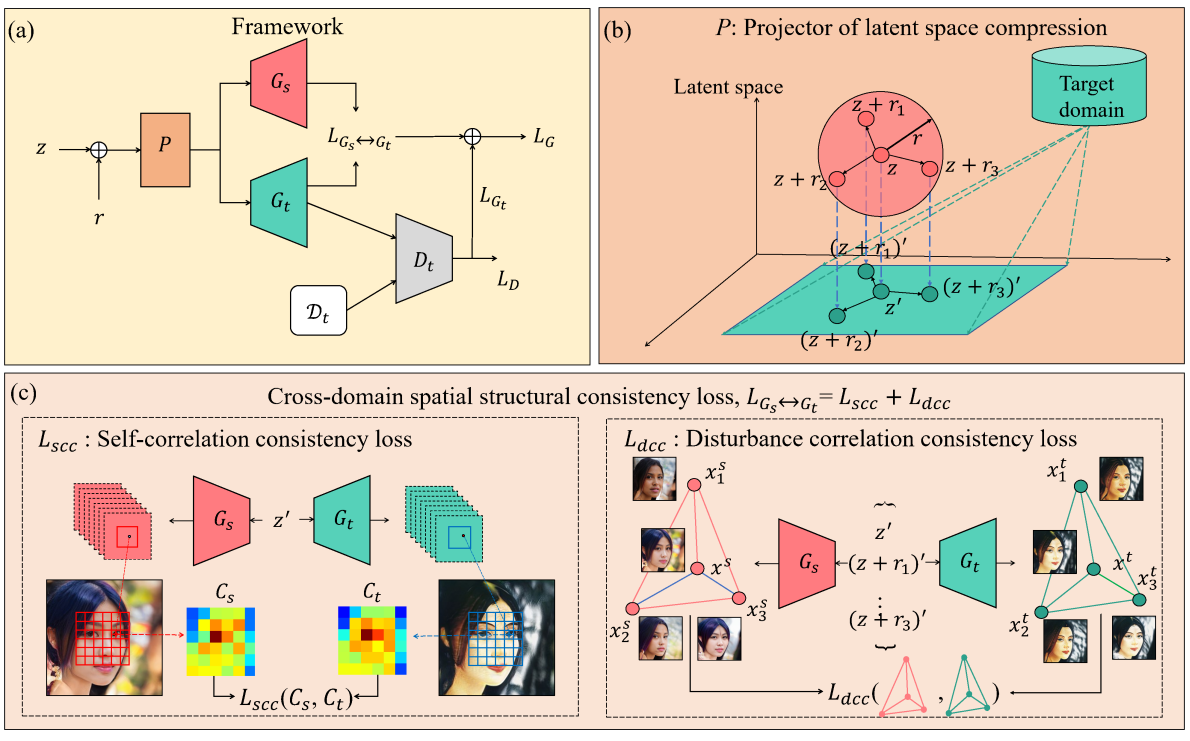

RSSA的模型框架图如上图所示,(a) 为整体框架,(b)为子空间的压缩,(c) 为跨域空间一致性损失两项示意。RSSA将源域丰富的结构信息适配到目标域,通过跨域空间结构一致性损失实现,具体包括两项,一个是自相关一致性损失(self-correlation consistency loss),另一个是扰动相关一致性损失(disturbance correlation consistenty loss)。接着进一步提出将隐空间压缩到一个子空间,使得子空间中生成的样本更靠近彼此。

Cross-domain spatial structural consistency loss

如上图所示,CDC直接对源域和目标域生成样本的一致性进行约束,迁移后的生成样本可能保留了原有的关系,但是他们的结构却发生了偏移。为了将结构信息考虑在适配过程,首先通过一个自相关一致性约束保留源域样本结构信息:

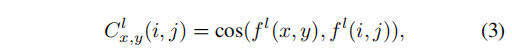

其中,Gt、Gs分别表示目标域生成器和源域生成器,C表示自相关矩阵。fl表示第 l 层的特征图, fl(x, y) 表示一个 c 维向量,计算不同位置与(x,y)之间的余弦相似度,相当于记录下了feature中各个位置之间的距离和相关性,对源域生成器和目标域生成器之间的自相关矩阵进行约束,可以实现将源域的结构适配到目标域的目的。

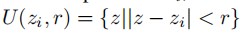

进一步的,由于潜在空间中的latent code是连续而不是离散的,所以作者认为,需要对生成图像在某些扰动下的变化趋势进行约束,具体来说,采取一个输入噪声作为锚点,在其周围采样一批输入噪声,生成的样本之间也应该是靠近且结构一致的,对于选取锚点z,以半径为r采样N个输入噪声:

并使用余弦相似度计算它们之间的空间互相关性,

![]()

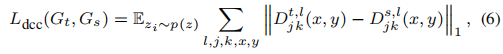

最后,通过L1距离来对源域和目标域对噪声编码扰动进行约束:

Latent space compression

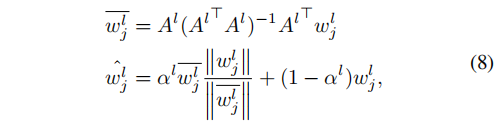

提出将前空间压缩到与目标域更近的子空间,首先将样本通过Image2StyleGAN映射到浅空间,并对其进行分解:

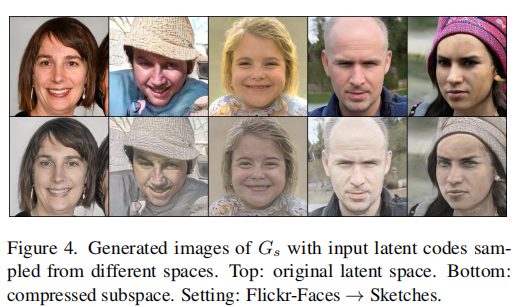

通过这样的方式,得到一个更靠近目标域的子空间,可以加速并稳定训练过程,而且从压缩子空间中生成的图片也能很好的还原原始图片的texture信息,如下图。

Structural Consistency Score

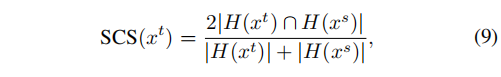

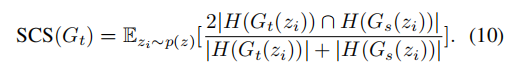

为了更好的体现本文中方法对空间结构的良好保留,进一步提出结构一致性指标:

H(·)表示HED函数,生成样本之间的SCS指标被定义为:

SCS越高,就表示有着更高的结构一致性。

实验

源域预训练模型包括三种,StyleGAN2在FFHQ、LSUN Churches、LSUN Cars预训练得到,适配到face Sketches, face paintings by Van Goph, face paintings by Moise Kisling,Haunted houses,village painting by Van Goph和wrecked/abandoned cars. 目标域的样本数设定包括10,5,1-shot。

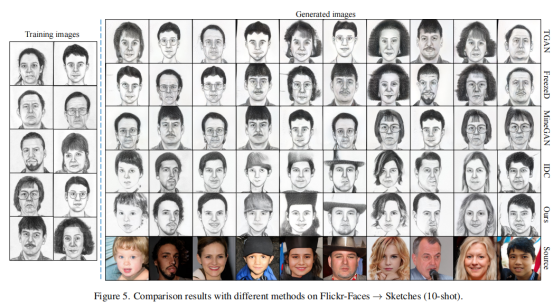

图5显示了使用不同自适应方法的FFHQ→Sketches的结果。可以观察到,TGAN与目标域的样本有强烈的过度拟合。与TGAN相比,FreezeD和MineGAN并没有改善结果。

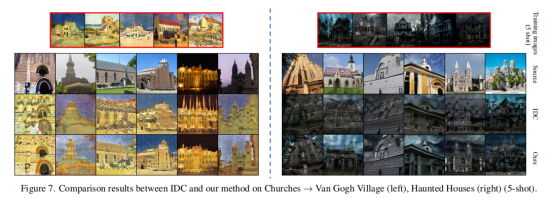

为了将IDC与RSSA进行全面比较,作者将比较实验扩展到不同少镜头设置的多个目标域,如图6和图7所示。在IDC的结果中可以观察到人脸的扭曲属性和教堂的纹理退化,但在RSSA的结果中几乎没有类似的现象。

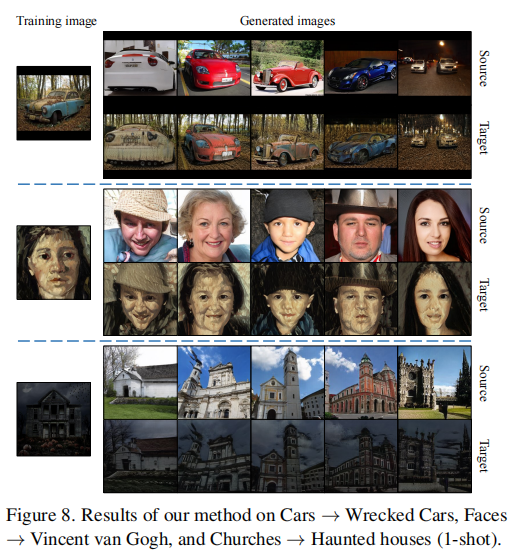

此外,作者对图8所示的单样本设定进行了大胆的尝试,得到了一些不错的结果。良好的视觉结果主要归因于潜在空间压缩和空间结构对齐的协同作用,前者有助于更快地从目标域获取属性,后者有助于从源域保存结构知识。

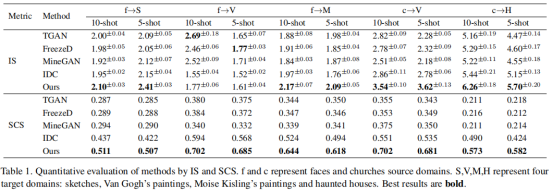

如表1所示,由于合成图像的高多样性和高质量,我们的方法在大多数情况下都获得了最好的分数。然而,TGAN、FreezeD和MineGAN在face→Van Gogh的表现都优于IDC和RSSA。原因是它们只是过度适合少数的训练样本,而IDC和RSSA生成的图像倾向于重新混合绘画的纹理和颜色。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢