论文标题:Domain-Oriented Prefix-Tuning: Towards Efficient and Generalizable Fine-tuning for Zero-Shot Dialogue Summarization

论文来源:NAACL 2022

论文链接:https://arxiv.org/abs/2204.04362

代码链接:https://github.com/Zeng-WH/DOP-Tuning

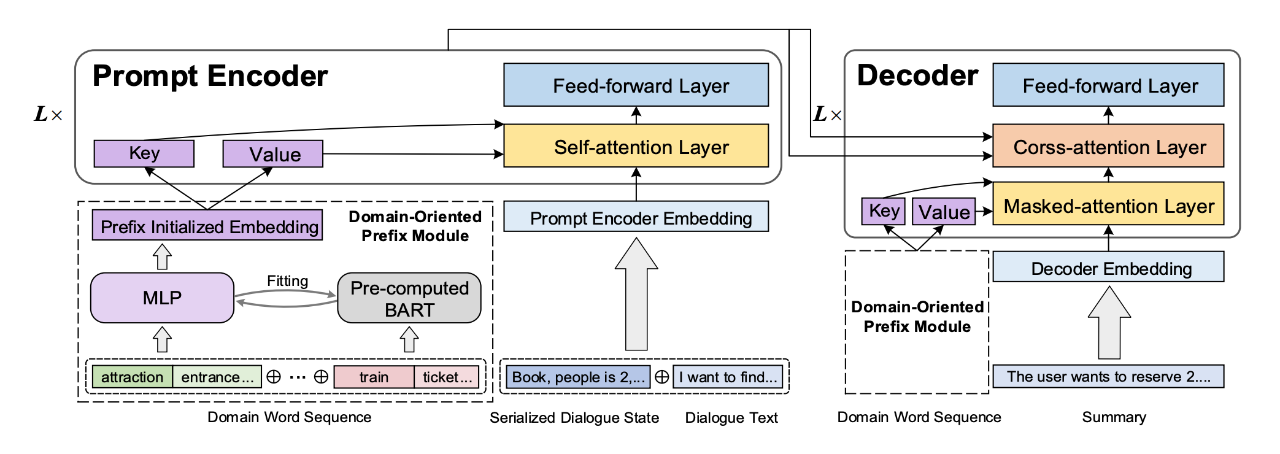

模型结构包括 Domain-Oriented Prefix,Prompt Encoder 以及 Decoder 三个部分。

模型结构图

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢