作者:Kai Hui, Honglei Zhuang, Tao Chen,等

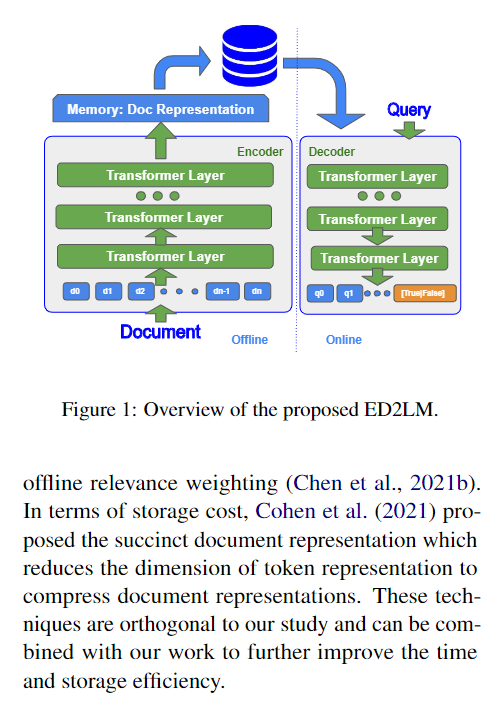

简介:本文研究预训练模型排序的效能优化。最先进的神经模型通常使用交叉注意力对文档-查询对进行编码以进行重新排序。为此,模型通常使用仅编码器(如 BERT)范例或编码器-解码器(如 T5)方法。然而,这些范例并非没有缺陷,即在推理时在所有查询-文档对上运行模型会产生巨大的计算成本。本文提出了一种用于重新排序的新训练和推理范式。作者建议使用文档形式对预训练的编码器-解码器模型进行微调以生成查询。随后,作者展示了这种编码器-解码器架构可以在推理过程中分解为仅解码器的语言模型。这导致显著的推理时间加速,因为仅解码器架构只需要在推理过程中学习解释静态编码器嵌入。作者的实验表明,这种新范式取得了与更昂贵的交叉注意力排名方法相当的结果,同时速度提高了 6.8 倍。作者相信这项工作为利用大型预训练模型的更高效的神经排序器铺平了道路。

论文下载:https://arxiv.org/pdf/2204.11458

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢