标题:清华、腾讯|On Transferability of Prompt Tuning for Natural Language Processing(论自然语言处理的即时调优的可迁移性)

作者:Yusheng Su, Xiaozhi Wang, Maosong Sun, Jie Zhou等

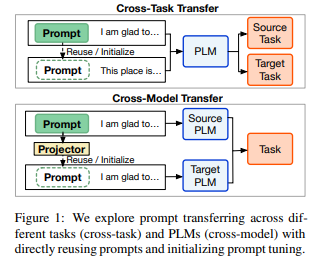

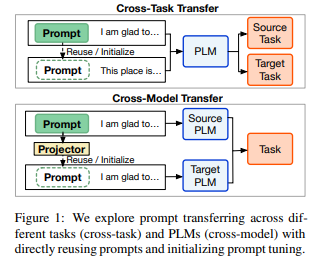

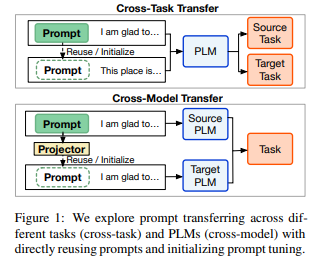

简介:本文研究了提示调优的迁移性。提示调优 (PT) 是一种很有前途的参数高效方法,可以利用超大型预训练语言模型 (PLM),只需调整一些软提示即可实现与全参数微调相当的性能。然而,与微调相比,PT 需要更多的训练时间。直观地说,知识转移有助于提高效率。为了探索作者是否可以通过提示转移来提高 PT,作者在这项工作中实证研究了软提示在不同下游任务和 PLM 之间的可转移性。作者发现(1)在零样本设置中,训练有素的软提示可以有效地转移到同一 PLM 上的类似任务,也可以转移到其他 PLM 上,并使用针对类似任务进行训练的跨模型投影仪; (2) 当用作初始化时,类似任务的训练软提示和其他 PLM 的投影提示可以显着加速训练,也可以提高 PT 的性能。此外,为了探索决定提示可转移性的因素,作者研究了各种可转移指标,发现激活神经元的重叠率强烈反映了可转移性,这表明提示如何刺激 PLM 至关重要。作者的研究结果表明,提示转移有望改善 PT,进一步的研究应更多地关注提示对 PLM 的刺激。

代码下载:https://github.com/thunlp/Prompt-Transferability

论文下载:https://arxiv.org/pdf/2111.06719v2.pdf

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢