【标题】Revisiting Gaussian mixture critic in off-policy reinforcement learning: a sample-based approach

【作者团队】Bobak Shahriari, Abbas Abdolmaleki, Arunkumar Byravan, Abe Friesen, Siqi Liu, Jost Tobias Springenberg, Nicolas Heess, Matt Hoffman, Martin Riedmiller

【发表日期】2022.4.21

【论文链接】https://arxiv.org/pdf/2204.10256.pdf

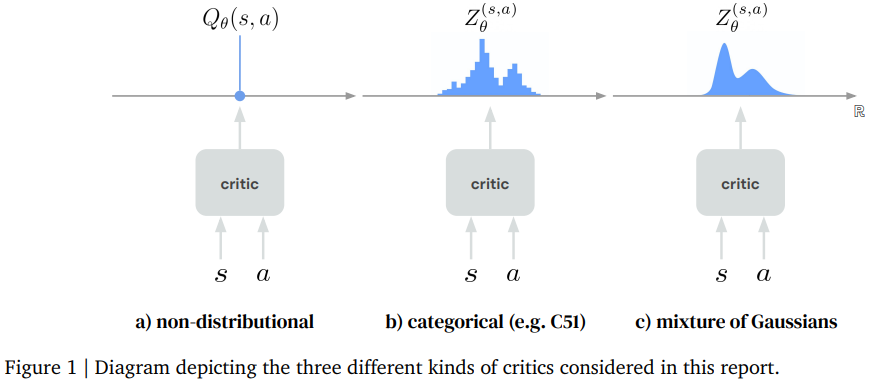

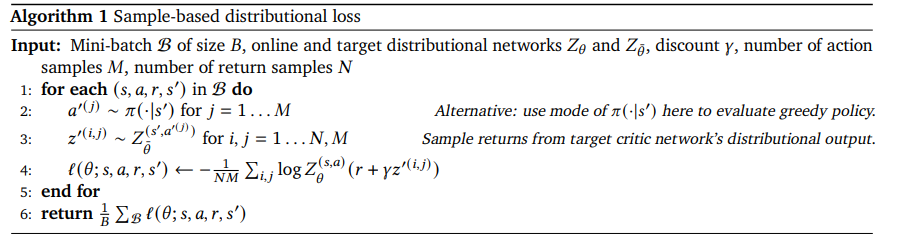

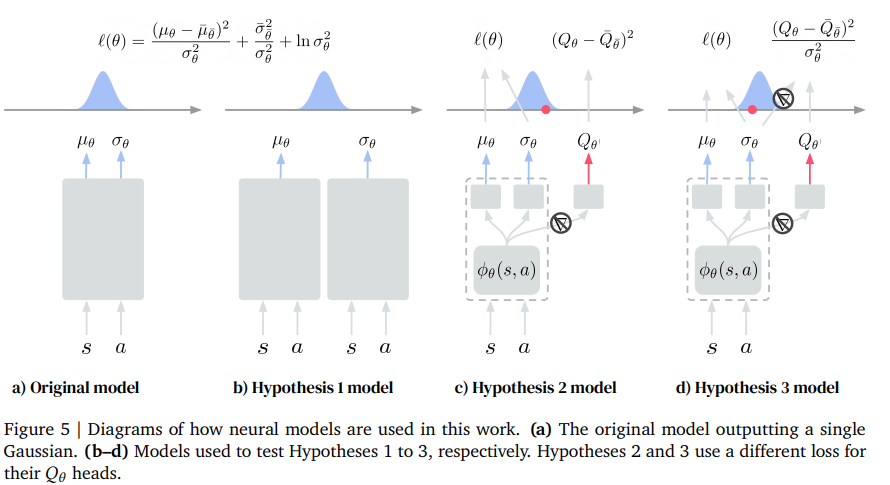

【推荐理由】在许多具有挑战性的控制任务中,使用分配策略评估的参与者批评算法经常被证明优于非分配算法。然而,这两个智能体都依赖C51批评家进行价值评估。C51方法的一个主要缺点是,它需要事先了解策略可以达到的最小值和最大值,以及使用的箱子数量,这就固定了分布估计的分辨率。虽然DeepMind control任务套件利用了标准化的奖励和事件长度,因此可以通过这些超参数的单一设置来解决整个套件,但情况往往并非如此。本文回顾了一种消除这一要求的自然替代方案,即高斯混合,以及一个简单的基于样本的损失函数,用于在非政策制度下对其进行训练。通过对其在广泛的连续控制任务中的性能进行了经验评估,并证明其消除了对这些分布超参数的需要,并在各种具有挑战性的任务(例如,仿人、狗、四足动物和操纵器领域)中实现了最先进的性能。最后,在Acme智能体库中提供了一个实现。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢