作者:Junyi Li, Tianyi Tang, Jian-Yun Nie,等

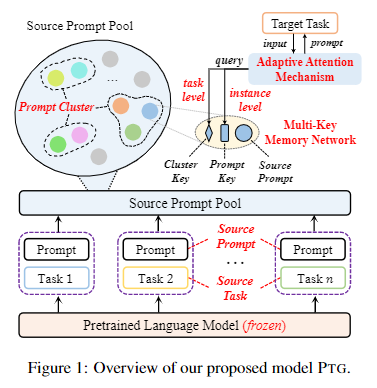

简介:在可转移的环境中生成文本领域、本文研究Prompt tuning的创新应用。预训练语言模型 (PLM) 通过微调在文本生成任务中取得了显着进展。同时,在数据稀缺的情况下微调 PLM 具有挑战性。因此,开发一个通用且轻量级的模型以适应基于 PLM 的各种文本生成任务并非易事。为了实现这个目的,最近的基于提示的学习提供了一个潜在的解决方案。在本文中,作者改进了这项技术,并提出了一种新的基于提示的方法 (PTG),用于在可转移的环境中生成文本。首先,PTG 为各种源生成任务学习一组源提示,然后将这些提示作为目标提示传输以执行目标生成任务。为了同时考虑任务级和实例级信息,作者设计了一种自适应注意机制来导出目标提示。对于每个数据实例,PTG 通过关注高度相关的源提示来学习特定的目标提示。在广泛的实验中,与微调方法相比,PTG 产生了具有竞争力或更好的结果。作者将源提示作为开放资源发布,用户可以在其中添加或重用它们以改进新的文本生成任务以供未来研究。

论文下载:https://arxiv.org/pdf/2205.01543

源码下载:https://github.com/RUCAIBox/Transfer-Prompts-for-Text-Generation

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢