作者:Mingda Chen, Jingfei Du, Ramakanth Pasunuru, 等

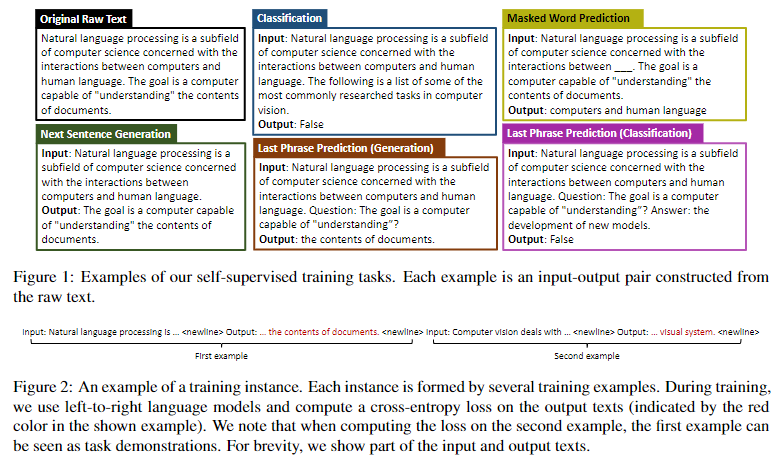

简介:本文研究预训练后新增自我监督以提升小样本学习性能。自监督预训练使许多 NLP 任务的小样本学习成为可能。但是预训练目标通常并不专门针对上下文小样本学习进行调整。在本文中,作者建议在预训练和下游小样本使用之间的中间训练阶段使用自我监督,目的是教模型在上下文中进行小样本学习。作者在两个基准上提出并评估了四个自我监督目标。作者发现中间自我监督阶段产生的模型优于强基线。消融研究表明,有多个因素会影响下游性能,例如训练数据量和自我监督目标的多样性。 人类注释的跨任务监督和自我监督是互补的。定性分析表明,自监督训练模型更能满足任务要求。

论文下载:https://arxiv.org/pdf/2205.01703

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢