【标题】Pessimism meets VCG: Learning Dynamic Mechanism Design via Offline Reinforcement Learning

【作者团队】Boxiang Lyu, Zhaoran Wang, Mladen Kolar, Zhuoran Yang

【发表日期】2022.5.5

【论文链接】https://arxiv.org/pdf/2205.02450.pdf

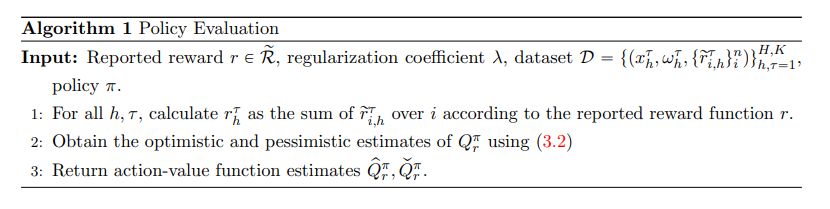

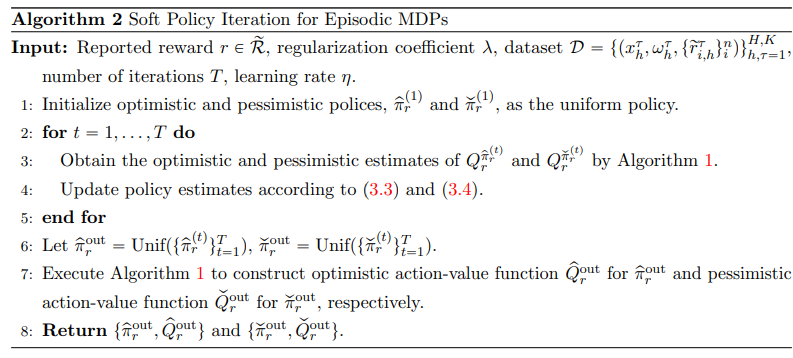

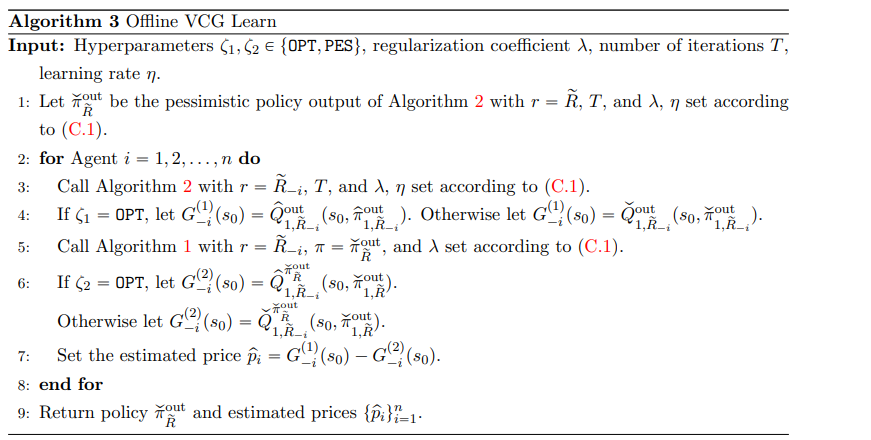

【推荐理由】近年来,动态机制设计引起了计算机科学家和经济学家的极大关注。通过允许智能体与卖方进行多轮交互,其中智能体的奖励函数可能随时间变化并且依赖于状态,该框架能够对丰富的现实世界问题进行建模。智能体和卖家之间的交互通常被假设遵循马尔可夫决策过程(MDP)。本文专注于这种 MDP 的奖励和转换函数是先验未知的设置,通过正在尝试使用先验收集的数据集来恢复最佳机制。在使用函数逼近来处理大型状态空间的设置中,对函数类的表达能力只有轻微的假设,以能够使用离线强化学习算法设计动态机制。此外,学习机制大致具有三个关键要求:效率、个体理性和真实性。该算法基于悲观原则,只需要对离线数据集的覆盖范围进行温和假设。本研究为动态机制设计提供了首个离线 RL 算法,而无需假设均匀覆盖。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢