论文:https://arxiv.org/pdf/2204.08714v2.pdf

代码:https://github.com/megvii-research/NAFNet

导读

近日,New Trends in Image Restoration and Enhancement (以下简称:NTIRE) 比赛结果揭晓,旷视研究院荣获双目图像超分辨率赛道的冠军。NTIRE 即“图像恢复与增强的新趋势”,是近年来计算机图像恢复领域最具影响力的一场全球性赛事,由苏黎世联邦理工学院计算机视觉实验室(Computer Vision Laboratory, ETH Zurich)主办,每年都会吸引大量的关注者和参赛者。

双目图像超分辨率挑战赛 (Stereo Image Super-Resolution Challenge)的目的是从低分辨率(LR)双目图像重建高分辨率(HR)双目图像。因此,已有方法大多关注于设计精细的模块、损失函数以探索双目图像之间的互补关系。这一做法导致了系统复杂度的上升,也使得新方法之间的对比分析逐渐困难。本文以NAFNet为基础,通过立体交叉注意力模块实现双目图像的超分辨任务,在仅引入少数参数的情况下取得了多个数据集上的SOTA性能,并取得了NTIRE 2022冠军成绩。

贡献

图像恢复(Image Restoration) 任务,旨在将降质的图像(如带噪声的,模糊的,低分辨率的...)恢复成清晰的图像。而本次的赛题,双目超分辨率任务,目标是用低分辨率的一对左右视角的立体图像来重建高分辨率的立体图像。与单张图像的超分辨率任务不同,双目超分辨率可以利用场景的左右两个视角提供的互补信息,从而提升图像恢复质量。

对于双目超分辨率任务,最直接的想法是将左右视角的两张图片独立的恢复成清晰图像,互不影响。而作者们的工作Nonlinear Activation Free Network for Image Restoration[2] (以下简称:NAFNet)在单张图像恢复领域提供了一个简单且强有力的基线。其效果如下图所示:

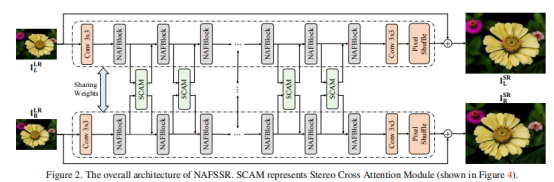

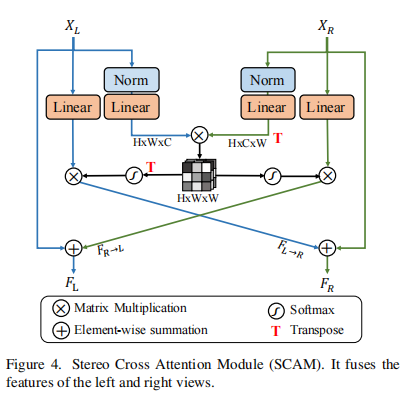

受此启发,作者直接利用 NAFNet 进行单张图像的超分辨率重建。虽然已经能取得不错的性能,但是这样的做法忽略了双目任务的特殊性:没有充分利用两个视角提供的互补信息。为此,作者在使用 NAFNet 分别提取左右两个视角的单图像特征之外,引入了立体交叉注意力模块(Stereo Cross Attention Module, 以下简称: SCAM)来融合左右视角的图像特征。

尽管NAFSSR具有强大的表征能力,但它可能会由于双目SR任务中稀少的训练数据而出现过拟合问题。因此,本文作者提出使用随机深度作为约束项,并使用RGB三通道的随机重组作为数据增强手段。此外,作者发现已有研究TLSC中存在训练数据-测试数据不连续问题。因此提出在测试阶段利用TLSC来环节上述不连续问题。

本文的主要贡献可以总结如下:

- 分析了现有方法的缺点,并提出了一种简单、易于实现的NAFSSR。它继承了NAFNet简单、有力的优点,利用立体SR任务的特点,通过一个简单的立体交叉注意模块来改进表示;

- 在NAFSSR的基础上,设计了其训练/测试策略,从而提升了其在立体SR任务上的竞争性能。这些策略和NAFSSR为这项任务构成了一个强大的基线:该基线以更少的参数和更快的推理速度实现了最先进的性能;

- 进行了大量的实验来证明NAFSSR的有效性,在NTIRE2022立体图像超分辨率挑战赛中获得了第一名。

方法

受启发与NAFNet便可以得到不错的超分辨重建性能,作者提出直接利用 NAFNet 进行单张图像的超分辨率重建。虽然已经能取得不错的性能,但是这样的做法忽略了双目任务的特殊性:没有充分利用两个视角提供的互补信息。为此,作者在使用 NAFNet 分别提取左右两个视角的单图像特征之外,引入了立体交叉注意力模块(Stereo Cross Attention Module, 以下简称: SCAM)来融合左右视角的图像特征。作者称该方法为NAFSSR: Stereo Image Super-Resolution Using NAFNet (以下简称:NAFSSR),其总体结构如下图所示:

NAFSSR中有两个核心模块设计:NAFBlock、立体交叉注意力模块(SCAM)。

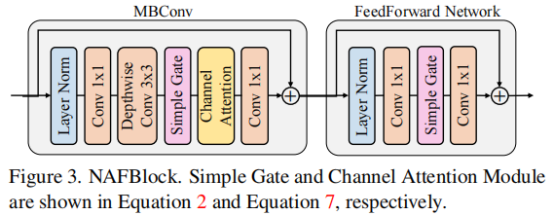

NAFBlock

NAFBlock的结构如上图所示,它包含两个部分:1)轻量级卷积模块,由1*1卷积与深度卷积构成;2)前向模块,包含两个全连接层。上述两个模块均包含LayerNorm层,它们的推理过程可以定义如下:

此外,与已有轻量级卷积模块不同,NAFBlock中的该模块使用一个门单元来替代已有模块中的非线性激活层(ReLU、GELU等)。给定输入X,门单元将它们从channel上分为均等的两部分,接着计算如下:

SCAM

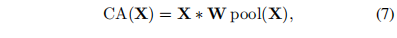

SCAM用于融合 NAFNet 提取到的左右视图特征,其计算方式可以定义如下:

Q,K,V分别代表query、key、value三种计算注意力权重的输入特征。然而,由于双目图像中左右图像的互补性,作者提出计算如下定义的立体交叉注意力:

W分别代表映射矩阵,最后以残差连接的方式得到最终表观:

训练策略

在模型设计之外,作者发现训练/测试时的统计值分布不一致问题(对于该问题,可以参考另外一项工作,TLSC[3]在双目超分辨率任务中依然存在,会降低图像恢复的质量,所以采用了 TLSC 以缓解该不一致问题:

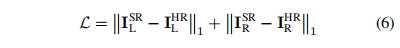

NAFSSR采用简单的L1范数分别计算左、右图像的重构误差,损失函数定义如下:

实验

为了进行公平的实验对比,作者首先设计了不同深度、不同宽度的NAFSSR,其结构如下表所示:

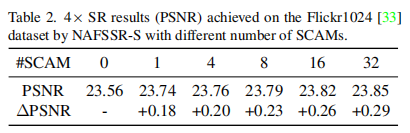

如表2中的结果所示,与基线相比,本文的SCAM提供了显著的性能改进,SCAM的数量越多,性能就越好。

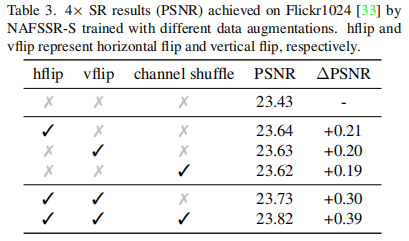

如表3所示,引入第3.2节中提到的水平随机翻转、垂直随机翻转和通道随机重构能够提高NAFSSR-S的性能。

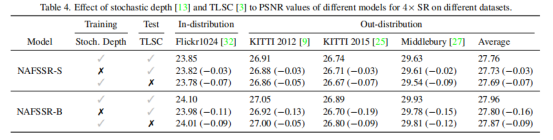

作者使用NAFSSR-S和NAFSSR-B来研究训练过程中随机深度[13]和推理过程中TLSC[3]的影响。

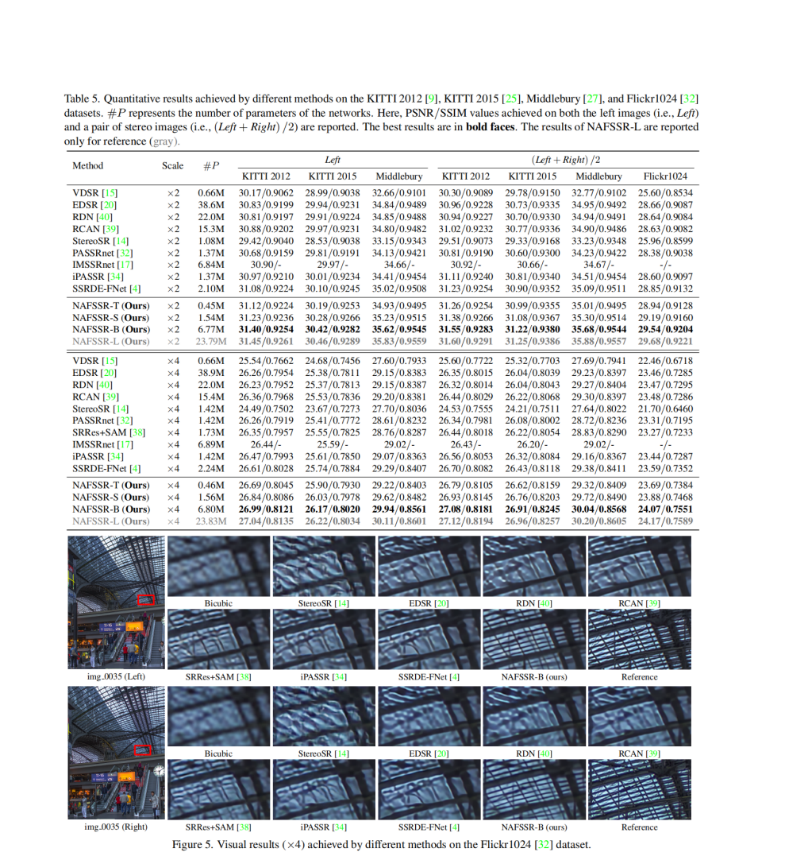

与现有SR方法的定量比较见表5。本文最小的NAFSSR-T达到了与之前最先进的(SSRDE-FNet[4])相同的竞争结果,并且本文的NAFSSR-S在所有数据集和上采样因子上都优于最先进的结果(×2,×4)。此外,本文的NAFSSR-B显著地提高了所有数据集的最新结果。

如图5所示,与SSRDE-FNet[4]相比,NAFSSR-T通过减少了79%的参数,实现了最先进的结果。这说明NAFSSR具有较高的参数效率。此外,通过扩大模型规模,NAFSSR-S明显超过了具有相似参数总数的竞争方法,而NAFSSR-B和NAFSSR-L进一步推动了最先进的立体声SR性能。这显示了NAFSSR的可缩放能力。

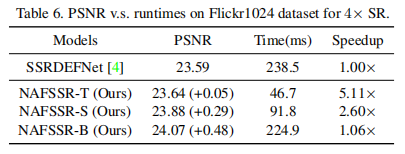

本文还报告了运行时(在RTX2080TiGPU上使用128×128输入进行评估),以比较现有的最佳模型SSRDE-FNet[4]和NAFSSR之间的计算复杂度。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢