最近,benchmanking又卷出了新高度,Allen AI 前段时间发布了史上最强基准测试——NATURAL-INSTRUCTIONSv2,涵盖了1600+个任务、70+个不同任务类型、50+种不同语言,用来测试生成模型的泛化性。

论文标题:

Benchmarking Generalization via In-Context Instructions on 1,600+ Language Tasks

论文地址:

https://arxiv.org/pdf/2204.07705.pdf

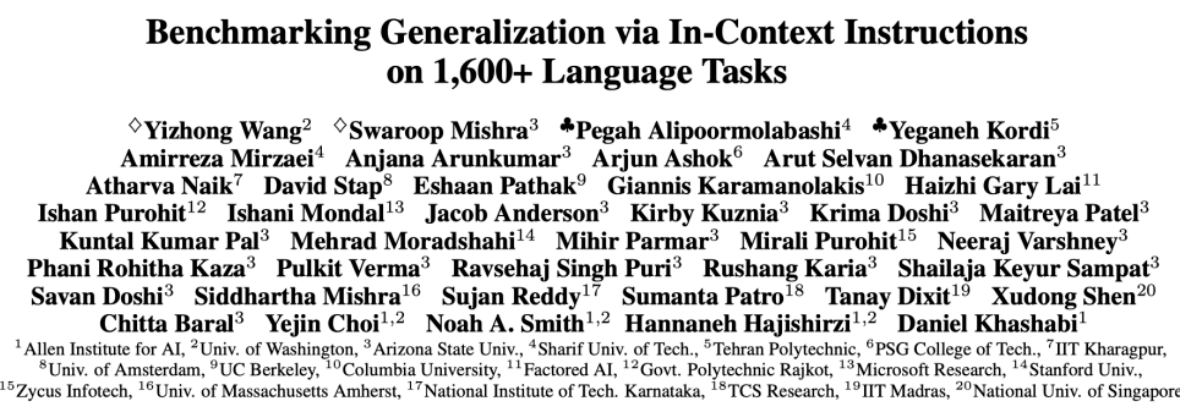

该基准是由众多NLP从业者共同创建发起,经过多次peer review后保证质量。先来直观感受下它涵盖的任务类型有多丰(恐)富(怖)

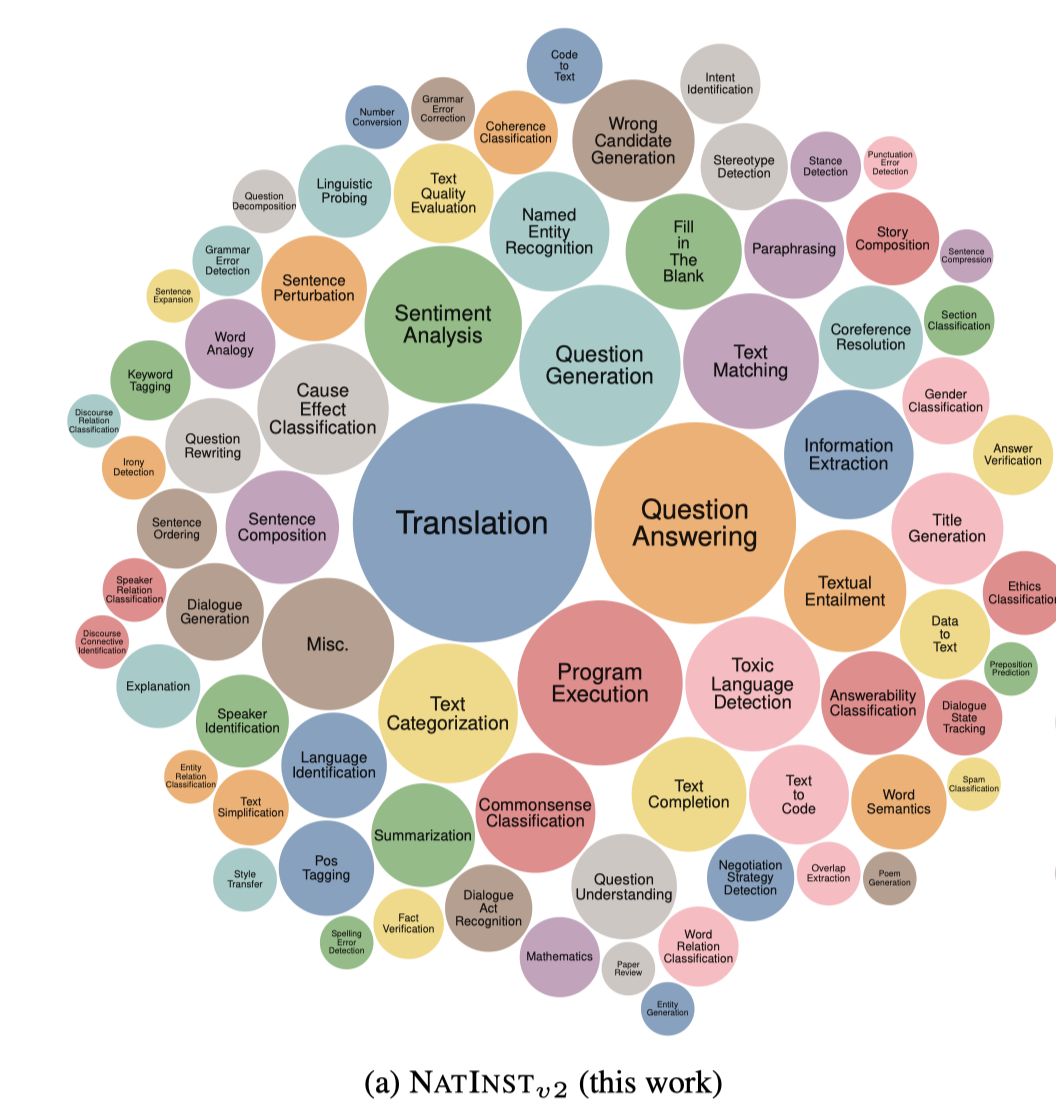

相比之下,PROMPTSOURCE(T0 subset)、FLAN、GPT3-INSTRUCT就是芝麻见绿豆了。

1616个task,76个task类型,16种推理类型, 非英文任务就有576个,每个任务平均有3k+个样本,工程如此浩大(nlper们光训练模型就已经够心累了,难道又要卡在评估上??)NATURAL-INSTRUCTIONSv2到底是何方神物,我们应该怎么使用它呢?下面从一个benchmark应该具备的3要素开始一探究竟吧~

测试目标:生成模型的泛化能力

测试工具:1616个任务

测试对象:T0、GPT3系列、T5、Tk-INSTRUCT

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢