论文链接:https://www.aliyundrive.com/s/WqWvoBkrzBi

代码链接:https://github.com/YaN9-Y/D4

导读

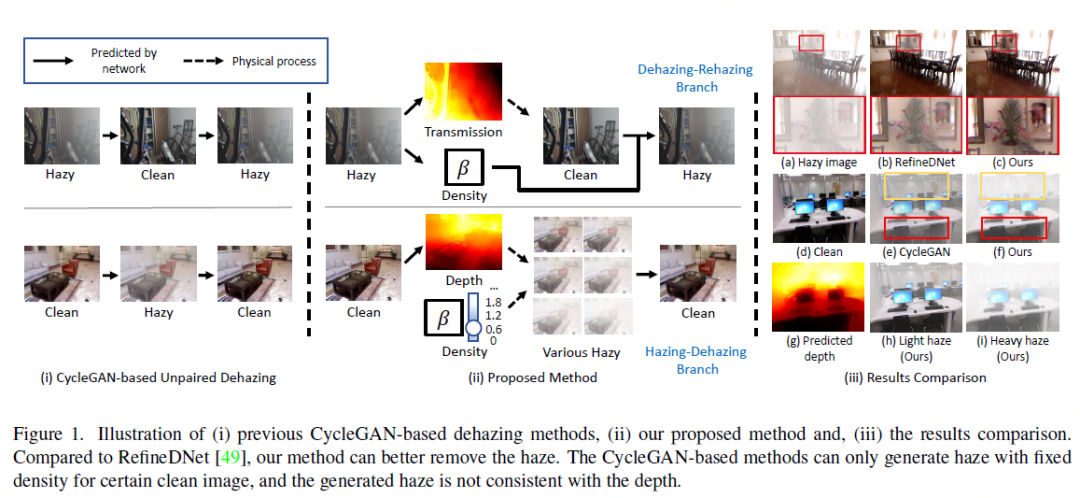

为了克服在合成数据集上训练的去雾模型的过拟合问题,许多最近的方法试图使用非成对数据进行训练来提高模型的泛化能力。然而其中大多数方法仅仅简单地遵循CycleGAN的思路构建去雾循环和上雾循环,却忽略了现实世界中雾霾环境的物理特性,即雾霾对物体可见度的影响随深度和雾气密度而变化。在本文中,作者提出了一种自增强的图像去雾框架,称为D4(Dehazing via Decomposing transmission map into Density and Depth),用于图像去雾和雾气生成。本文所提出的框架并非简单地估计透射图或清晰图像,而是聚焦于探索有雾图像和清晰图像中的散射系数和深度信息。通过估计的场景深度,本文的方法能够重新渲染具有不同厚度雾气的有雾图像,并用于训练去雾网络的数据增强。值得注意的是,整个训练过程仅依靠非成对的有雾图像和清晰图像,成功地从单个模糊图像中恢复了散射系数、深度图和清晰内容。综合实验表明,本文的方法在参数量和FLOP更少的情况下去雾效果优于最先进的非成对去雾方法。

贡献

图像去雾是计算机视觉底层任务中的重要研究方向之一,其目的是从有雾图像中恢复出清晰图像,从而提升人对图像的信息感知容易度和高级视觉任务的有效理解。在已有研究中,基于大气散射光A和透射率t,有雾图像I的每个像素可以由清晰图像J上的对应像素进行推导:

为了对数据依赖型的CNN模型进行训练,已有研究大多采用合成图像I进行训练,即确定清晰图像J,改变t、A生成不同的输入有雾图像。尽管这一训练方法促进了诸多去雾模型的设计和推广,但它们不可避免地使模型受限于真实图像与合成图像之间的域差异,容易在合成数据上出现过拟合问题。为解决这一问题,部分研究遵循CycleGAN的思路使用非成对的数据进行训练,即使用MAE相似的训练策略(如图1),但这一做法忽略了现实世界中雾霾环境的物理特性,即雾霾对物体可见度的影响随深度和雾气密度而变化。

本文聚焦于探索有雾图像和清晰图像中的散射系数和深度信息。通过深度信息的探索,模型可以对清晰图像进行不同程度的渲染提出了一种自增强的图像去雾框架,称为D4(Dehazing via Decomposing transmission map into Density and Depth),用于图像去雾和雾气生成,整个训练过程仅依靠非成对的有雾图像和清晰图像,成功地从单个模糊图像中恢复了散射系数、深度图和清晰内容。综合实验表明,本文的方法在参数量和FLOP更少的情况下去雾效果优于最先进的非成对去雾方法。

本文的主要贡献可以总结如下:

- 提出了一种新的非配对脱雾框架,它明确地模拟了散射系数(即密度)和模糊场景的深度图。所提出的基于物理的框架在很大程度上缓解了现有的未配对脱雾方法中存在的病态问题。

- 受下述直觉的启发:“空间上的雾霾厚度可以反映场景深度”,本文的模型学习了从模糊图像中预测深度信息。然后,只有未配对的模糊和干净的图像,被用于训练模型预测干净图像的深度信息。

- 通过估计的场景深度,我们的模型可以通过改变散射系数来生成不同厚度的模糊图像。这种特征可以作为一种更好地训练脱雾网络的自我论证策略。

- 在合成图像和真实图像上进行了广泛的实验,以揭示我们的设计的有效性。所提出的D4框架在泛化能力方面具有明显的优势。

方法

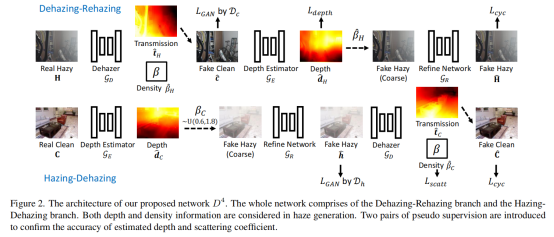

本文提出的D4模型如上图所示,整个网络由去雾-再增雾分支和生成雾-去雾分支组成。在雾霾生成过程中,同时考虑了深度信息和密度信息,并引入了两对伪监督来确定估计深度和散射系数的精度。

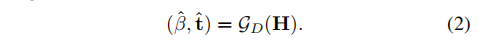

去雾网络GD

去雾模块的目的是从有雾图像中检测散射系数β和透射率t:

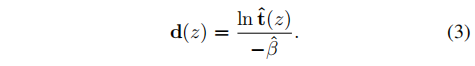

基于此,图像的深度信息可以合成如下:

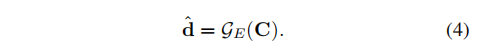

深度检测网络GE

这一模块的目的在于从深度图像中对深度信息进行直接估计:

它通过来自于GD的伪监督信息进行训练。

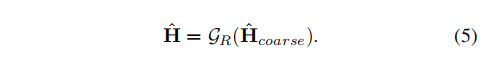

精修网络GR

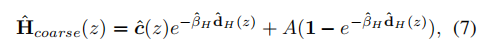

如图2所示,D4模型将图像去雾的过程建模成两个阶段,首先是从清晰图像中合成一个粗糙的有雾图像,接着采用精修网络进行雾霾表观的细化:

在上述三个网络的基础上,作者采用了两阶段的流程进行训练:

去雾-再增雾

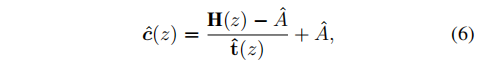

在这一阶段,作者的思路主要是将有雾图像H通过GD进行去雾复原c,这一过程通过将公式1进行反向推导得到:

在c的基础上,作者利用GE得到其深度信息d,接着利用有雾图像H中已知的检测散射系数β和透射率t再次生成有雾图像:

生成雾-去雾

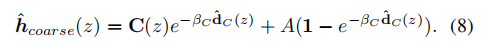

这一过程实际上是将上述过程进行反转,它们的区别是此处引入了精修网络GR:

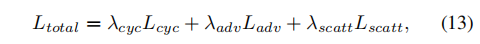

损失函数

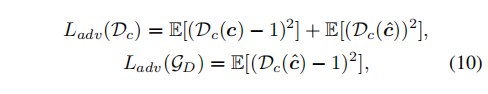

在上述训练过程和网络结构中,存在三种需要进行监督的信息:

有雾-清晰图像的重建程度

有雾-清晰图像的可分辨程度-对抗损失

潜在参数监督(散射系数β及深度信息d)

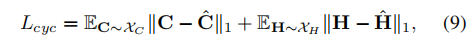

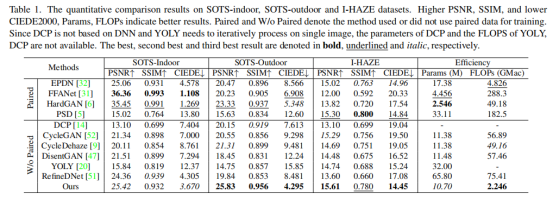

因此,总损失函数定义如下:

实验

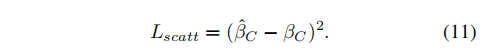

本文采用了三个数据集进行实验验证:RESIDE、I-HAZE、Fattal,并采用常用的PSNR、SSIM、CIEDE2000指标进行对比,对比方法包括EPDN、FFANet、YOLY等。

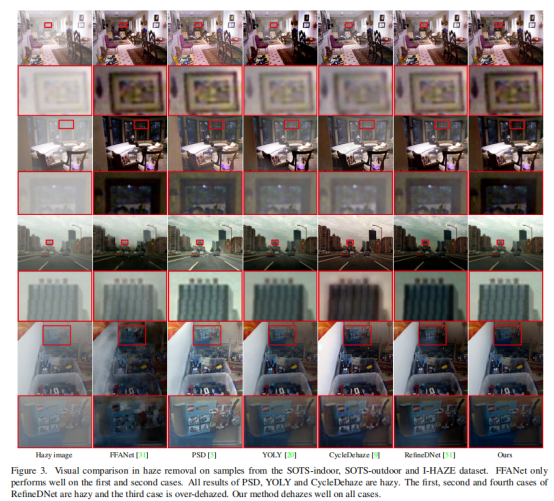

指标对比结果如下表所示,D4是在没有使用成对训练数据的方法中性能最好的。相比之下,由于SOTS-outdoor数据集和I-HAZE数据集的样本与训练数据不一致,因此FFANet和HardGAN失去了它们的主导地位。它部分地揭示了监督脱雾方法的过拟合问题。而我们的D4消除了这些缺陷,并在两个数据集上都优于其他竞争对手。

与上表对应的视觉对比效果如下图:

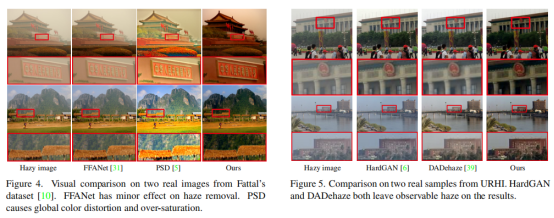

最后,作者给出了真实场景中的视觉对比:

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢