作者:Yuan Yao, Bowen Dong, Ao Zhang,等

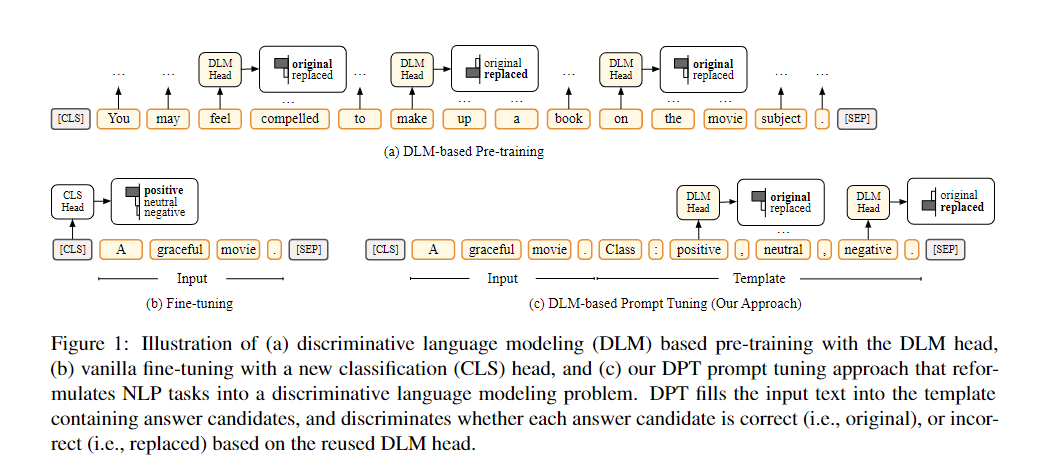

简介:本文提出判别式预训练语言模型提示调优的首个框架。最近的工作显示了在鼓励用于自然语言处理 (NLP) 任务的预训练语言模型 (PLM) 方面的提示调优的可喜结果。然而,据作者所知,现有工作专注于对生成 PLM的提示调优,这些 PLM 经过预训练以生成目标令牌,例如 BERT。目前尚不清楚区分性 PLM(例如 ELECTRA)是否以及如何能够有效地提示调优。在这项工作中,作者提出了 DPT,这是第一个用于判别 PLM 的提示调优框架,它将 NLP 任务重新定义为判别语言建模问题。文本分类和问答的综合实验表明,与普通微调相比,DPT 实现了显着更高的性能,并且还防止了在全集和低资源设置中调优大型 PLM 的不稳定问题。

论文下载:https://arxiv.org/pdf/2205.11166

源码下载:https://github.com/thunlp/DPT

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢