作者:Nigel Fernandez , Aritra Ghosh , Naiming Liu ,等

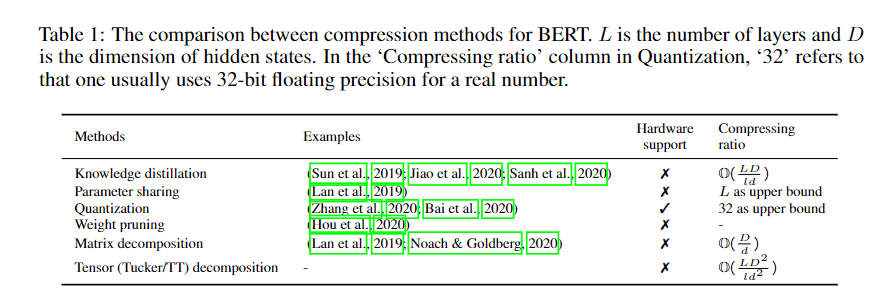

简介:本文研究探索预训练语言模型(PLM)的极限压缩比。最近的工作探索了基于Transformer 的大规模预训练模型的潜力,特别是PLM在自然语言处理中的潜力。这从不同角度引发了许多担忧,例如财务成本和碳排放。在性能损失可以忽略不计的情况下压缩像BERT这样的plm,以实现更快的推理和更廉价的部署,已经引起了人们的广泛关注。在这项工作中,作者的目标是探索PLM更大的压缩比,其中张量分解是一种潜在的但尚未研究的方法。为了提高压缩过程中的有效性和效率,进一步提出了两种分解和重构协议。作者在Transformer层中使用1/7参数的压缩BERT的性能与之相当,有时比GLUE benchmark中的原始BERT略好。一个微型版本使用1/48的编码器参数(即不包括嵌入层的参数小于2M)和2.7倍的推理速度,实现了96.7%的BERT-base性能。为了证明所提出的方法与现有的压缩方法(如知识提取)是正交的,作者还探讨了所提出的方法在经过提取的BERT上的对比优势。

论文下载:https://arxiv.org/pdf/2205.09864

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢