标题:DeepMind、谷歌|Towards Learning Universal Hyperparameter Optimizers with Transformers(基于变换器学习通用超参数优化器)

作者:Yutian Chen, Xingyou Song,Nando de Freitas等

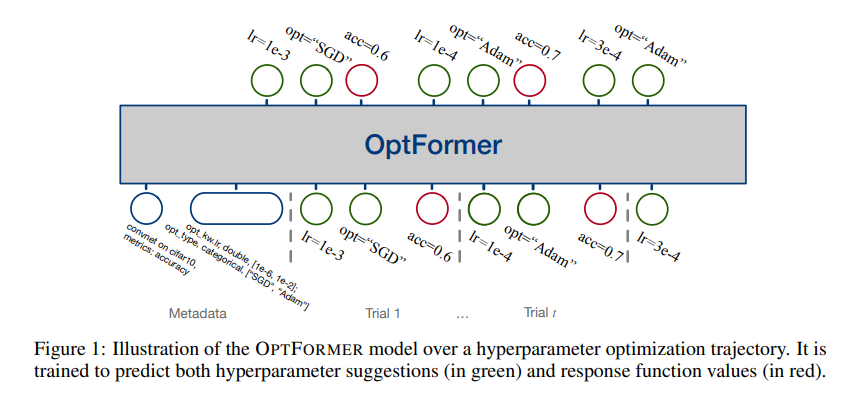

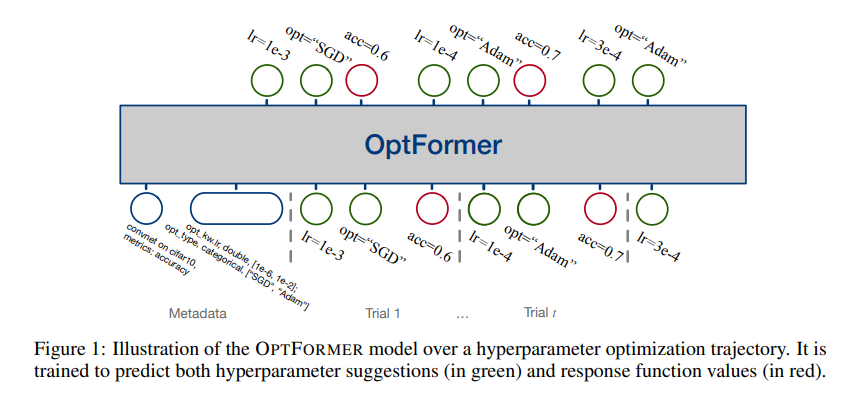

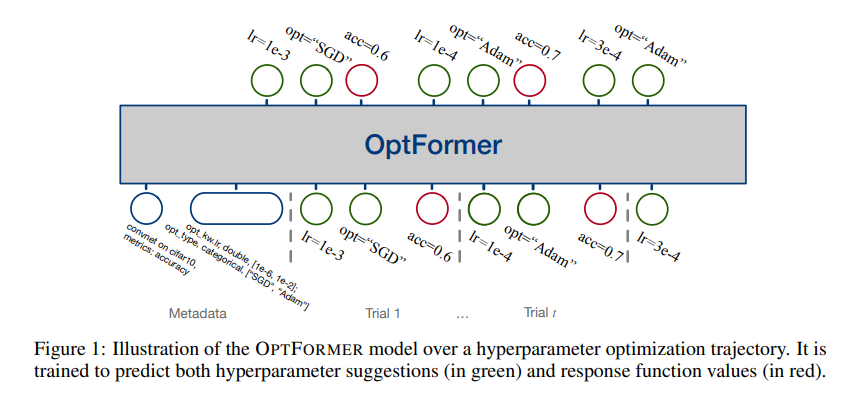

简介:本文利用了变换器模型来调优超参数。来自先前实验的元学习超参数优化(HPO)算法是一种很有前途的方法,可以提高优化效率而不是目标来自类似发行版的函数。但是,现有方法仅限于从共享同一组超参数的实验中学习。在本文中,作者介绍 OPTFORMER,这是第一个基于文本的 Transformer HPO 框架它提供了一个通用的端到端接口,用于在从域外(如Google)进行大量调优数据训练时,共同学习策略和功能预测。Vizier数据库,世界上最大的HPO数据集之一。我们广泛的实验证明 OPTFORMER 可以模仿至少 7 种不同的 HPO 算法,这可以通过其函数不确定性估计进一步改进。

论文下载:https://arxiv.org/pdf/2205.13320v1.pdf

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢