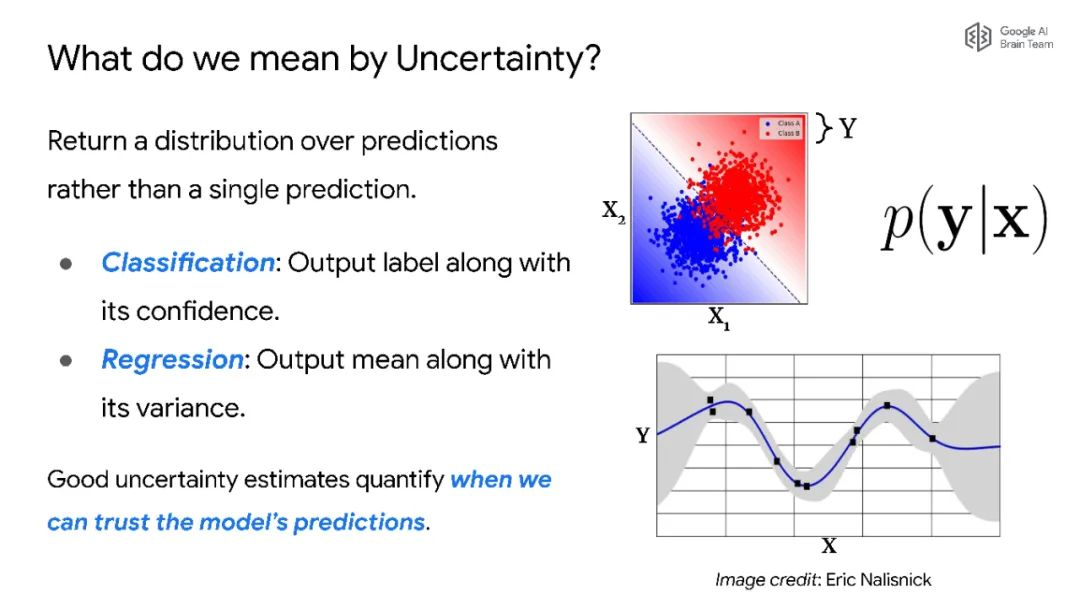

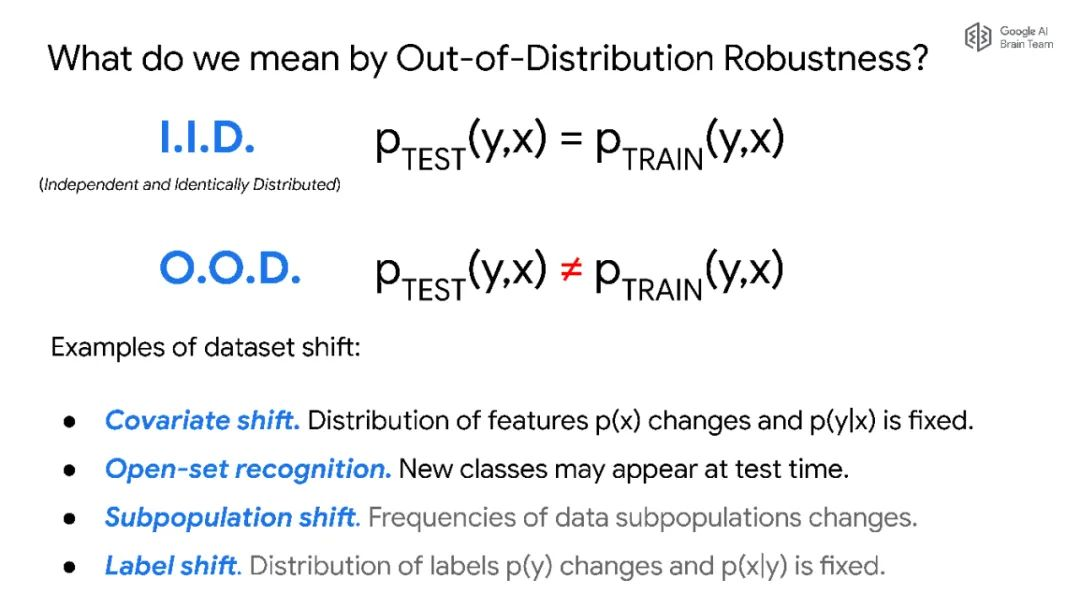

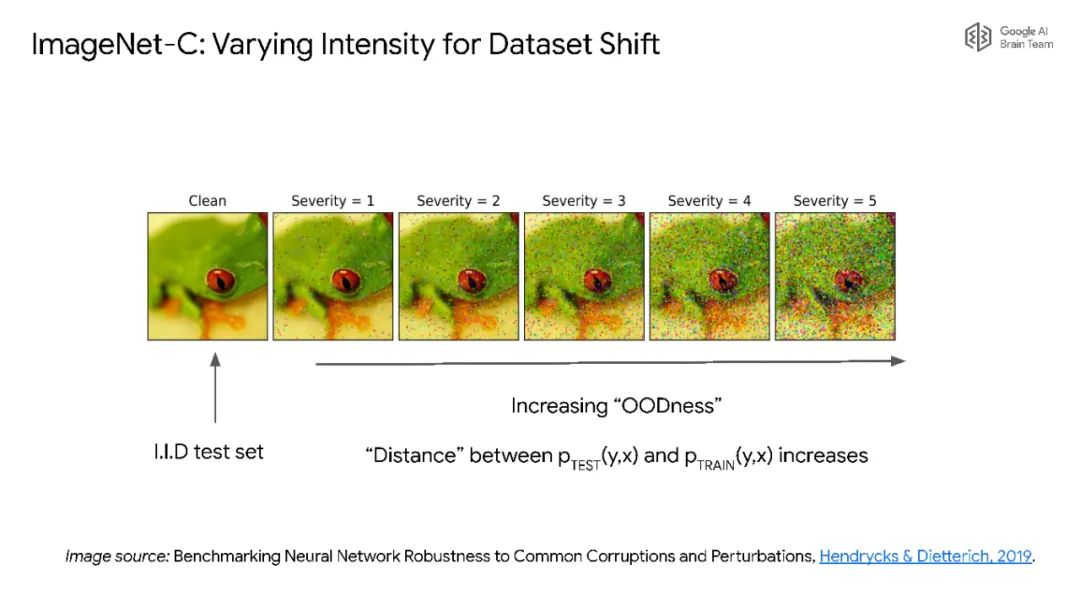

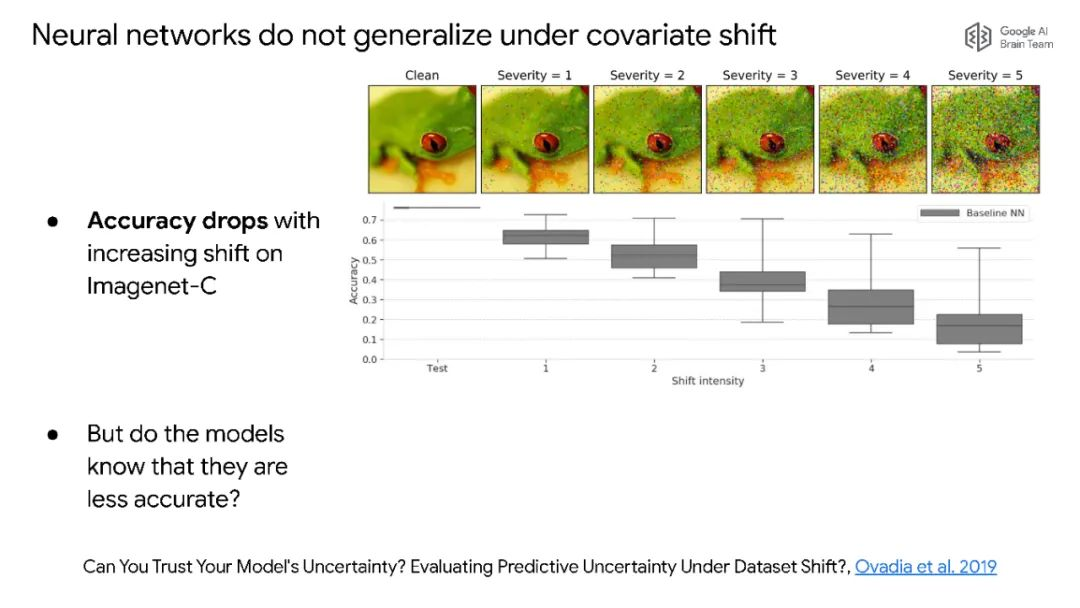

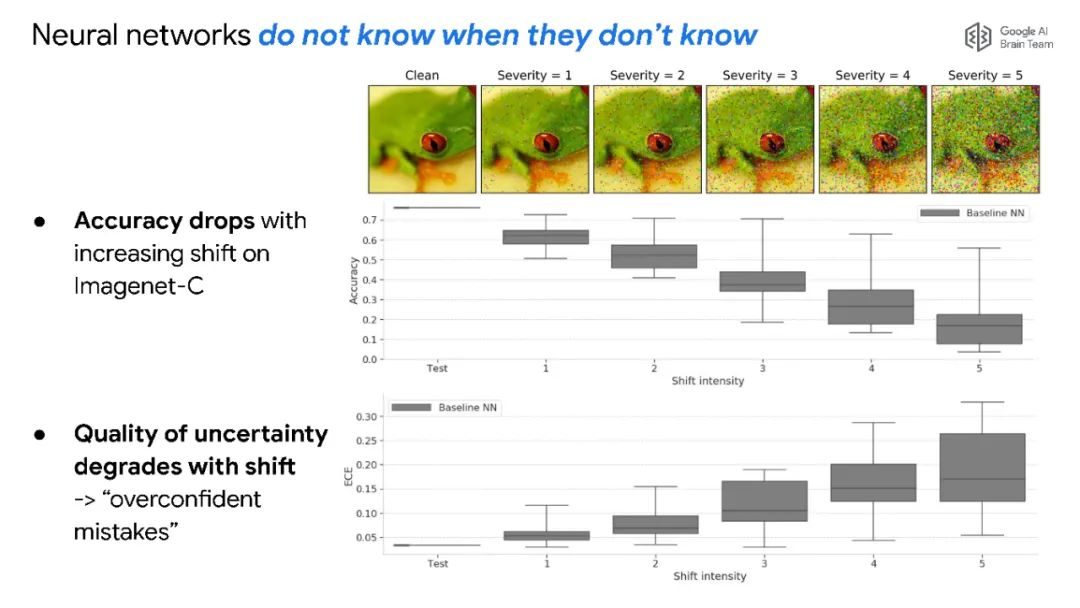

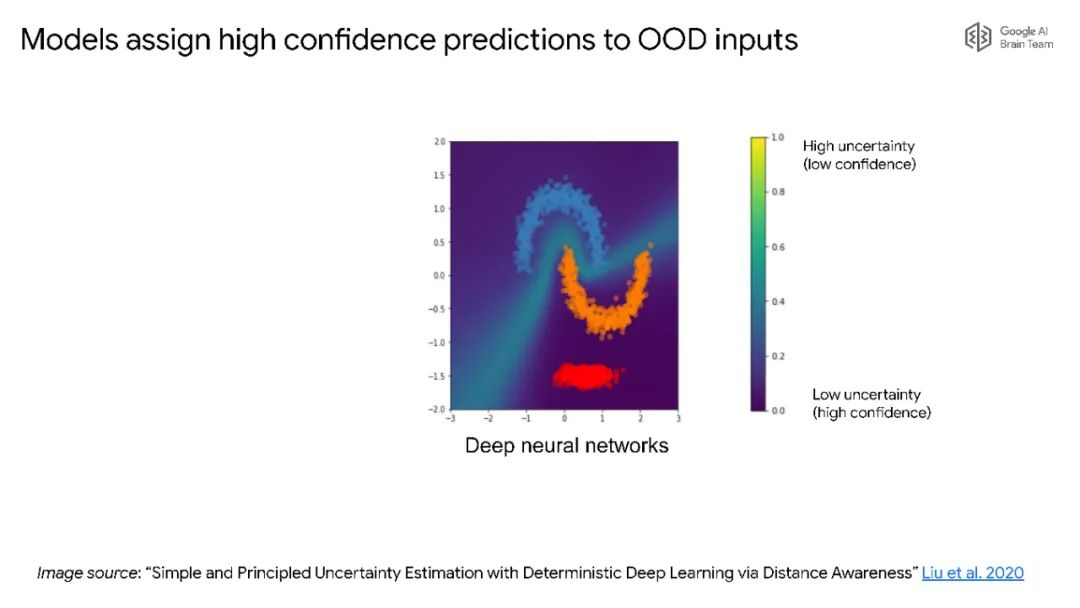

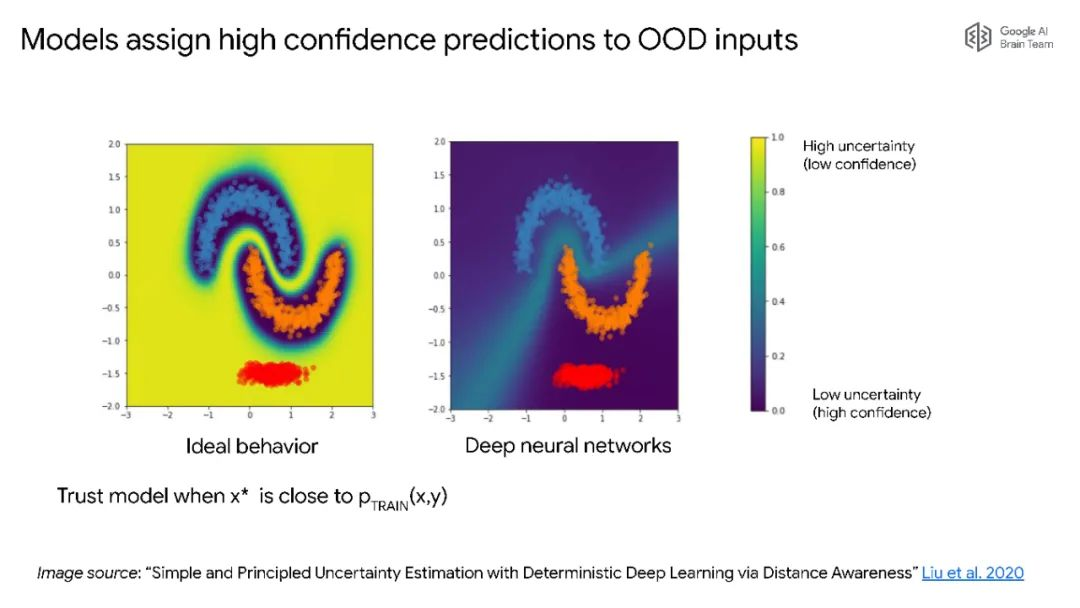

对深度学习中的不确定性进行量化是一个具有挑战性且尚未解决的问题。预测的不确定性估计对于知道何时信任模型的预测是很重要的,特别是在实际应用中,在实际应用中,训练和测试分布可能是非常不同的。报告的第一部分将集中于检测分布外输入(OOD)。深度生成模型被认为对OOD输入更鲁棒,但我将给出反例,其中生成模型可以为OOD输入分配比训练数据更高的可能性。具体来说,我们发现,在一个数据集(如CIFAR-10)上训练的深度生成模型的模型密度赋予来自另一个数据集(如SVHN)的OOD输入更高的可能性。我将讨论一些最近的后续工作,其中我们将进一步详细研究这些失效模式,并提出解决方案。演讲的第二部分将集中讨论判别模型的预测不确定性估计。我将讨论我们在数据集漂移下校准的大规模基准研究的结果,并介绍我们在推进漂移校准的最先进一些工作。

Balaji Lakshminarayanan目前是谷歌Brain的研究人员。他最近的研究集中在概率深度学习,特别是不确定性估计,非分布鲁棒性和深度生成模型。

Balaji Lakshminarayanan 个人主页:http://www.gatsby.ucl.ac.uk/~balaji/

PPT下载:http://www.gatsby.ucl.ac.uk/~balaji/balaji-uncertainty-talk-cifar-dlrl.pdf

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢