作者:Kanthashree Mysore Sathyendra, Thejaswi Muniyappa, Feng-Ju Chang,等

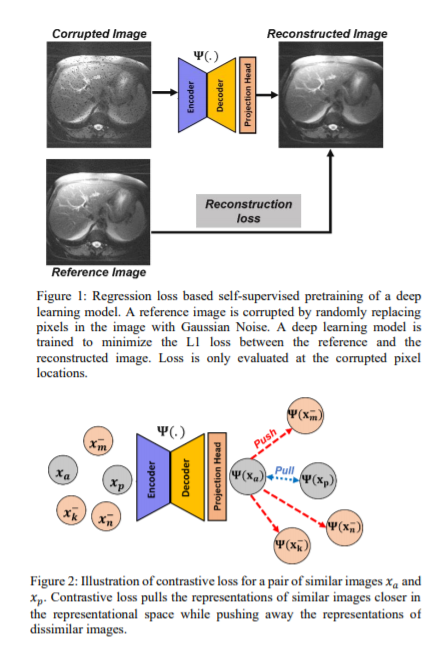

简介:本文研究利用预训练自监督技术。获取用于深度学习(DL)模型监督训练的大型数据集的手工标注是一项挑战。与标记数据集相比,大型未标记数据集的可用性促使使用自我监督的预训练来初始化DL模型,以用于后续的分割任务。在这项工作中,作者考虑两种预训练方法来驱动DL模型学习不同的表示:a)利用图像内的空间依赖性的回归损失和b)利用图像对之间的语义相似性的对比损失。使用磁共振(MR)图像在两种下游分割应用中评估预训练技术的效果:a)腹部T2加权MR图像中的肝脏分割和b)前列腺T2加权MR图像中的前列腺分割。作者观察到,使用自我监督预训练的DL模型可以微调,以获得与标记数据集较少的可比性能。此外,作者还观察到,使用基于对比损失的预训练来初始化DL模型的效果优于回归损失。

论文下载:https://arxiv.org/pdf/2205.13109

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢