作者:Matteo Boschini, Lorenzo Bonicelli, Angelo Porrello,等

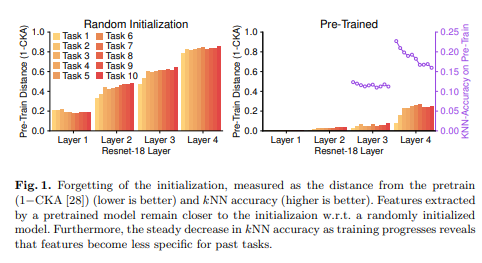

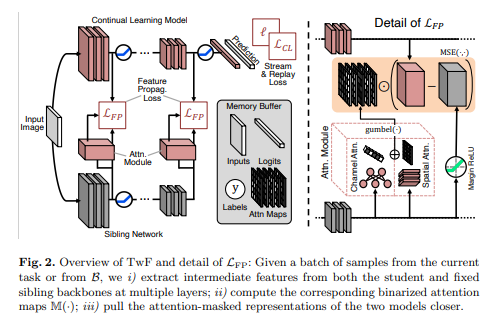

简介:本文研究了连续学习(CL)和迁移学习(TL)之间的纠缠。特别是,作者阐明了网络预训练的广泛应用,强调了它本身会受到灾难性遗忘的影响。不幸的是,这一问题导致在以后的任务中对知识转移的利用不足。在此基础上,作者提出了无遗忘迁移(TwF),这是一种基于固定预训练双网络的混合连续迁移学习方法,它通过分层损失项不断传播源域中固有的知识。作者的实验表明:TwF在各种设置下都稳步优于其他CL方法、在各种数据集和不同缓冲区大小的情况下精度平均提高4.81%

论文下载:https://arxiv.org/pdf/2206.00388

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢