本篇分享论文『Efficient Long-Range Attention Network for Image Super-resolution』,由香港理工大学、OPPO 提出ELAN:将超分网络SwinIR高效化,最快可达4.5倍。

- 作者单位:香港理工大学、OPPO

- 论文链接:https://arxiv.org/abs/2203.06697

- 项目链接:https://github.com/xindongzhang/ELAN

01 看点

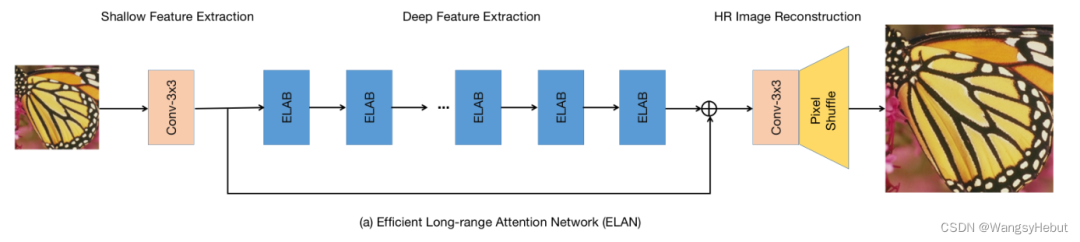

Transformer通过利用自注意(self-attention, SA)进行特征提取,取得了令人印象深刻的结果。然而SA的计算是非常昂贵的,并且一些操作对于SR任务来说可能是冗余的。本文提出了一种高效的远程注意网络(ELAN),它首先采用shift卷积在保持与1x1卷积相当的复杂度情况下有效的提取图像局部结构信息,然后提出了一种分组多尺度自注意(GMSA)模块,它使用不同的窗口大小在非重叠的特征组上计算SA。通过将两个shift卷积与GMSA模块级联,构建高效的远程注意块(ELAB),并通过共享注意机制进一步加速该模块的运行,极限情况下能比SwinIR快四倍!

02 方法

Overview

ELAN的架构如下图所示,它由三部分组成:浅层特征提取、深度特征提取和HR图像重建。其中浅层特征提取由一个3x3卷积组成,深度特征提取由堆叠的ELAB和一个残差连接组成,重建模块由一个3 × 3卷积和一个PixelShuffle操作组成,损失采用范式。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢