Google翻译自项目的GitHub页面:

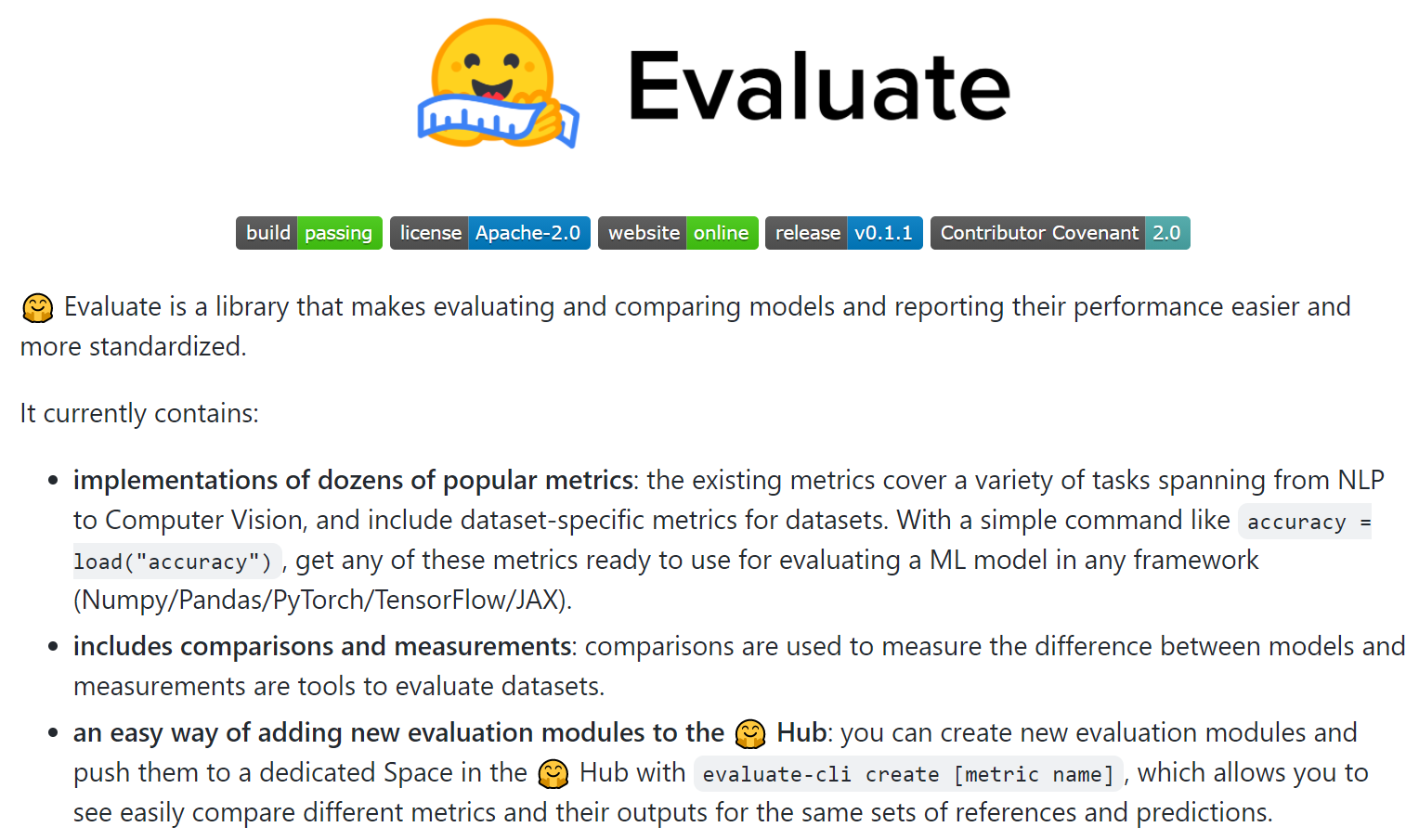

Evaluate 是一个库,它使评估和比较模型以及报告它们的性能更容易和更标准化。

它目前包含:

- 数十种流行指标的实现:现有指标涵盖从 NLP 到计算机视觉的各种任务,并包括数据集的特定于数据集的指标。 使用诸如 accuracy = load("accuracy") 之类的简单命令,准备好这些指标中的任何一个,以用于在任何框架(Numpy/Pandas/PyTorch/TensorFlow/JAX)中评估 ML 模型。

- 包括比较和测量:比较用于衡量模型之间的差异,而测量是评估数据集的工具。

- 将新评估模块添加到🤗 Hub 的简单方法:您可以创建新评估模块并将它们推送到 🤗 Hub 中的专用空间,使用 evaluate-cli create [metric name],您可以轻松查看比较不同的指标和 它们针对相同的参考和预测集的输出。

……

🤗 Evaluate 还有很多有用的功能,例如:

- 类型检查:检查输入类型以确保您为每个指标使用正确的输入格式

- 指标卡:每个指标都附带一张卡,描述值、限制及其范围,并提供其用法和有用性的示例。

- 社区指标:指标位于 Hugging Face Hub 上,您可以轻松地为您的项目添加自己的指标或与他人协作。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢