标题:北大、微软|On the Advance of Making Language Models Better Reasoners(关于使语言模型更好的推理的进展)

作者:Yifei Li, Zeqi Lin, Weizhu Chen等

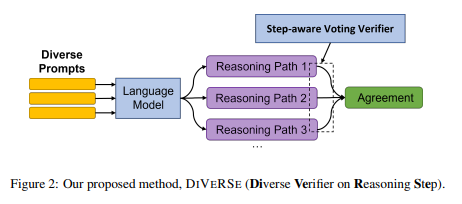

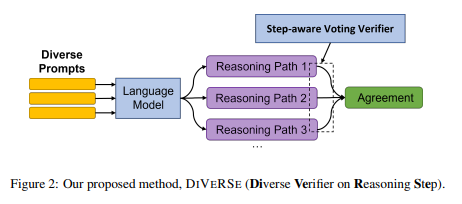

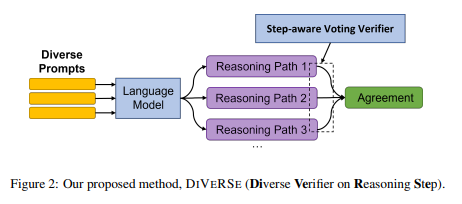

简介:本文提出了一种语言模型推理的方法。大型语言模型,如 GPT-3、PaLM在少样本学习中表现出了卓越的表现。但是,它们仍然在推理任务中挣扎,例如算术基准测试GSM8K。最近在产生最终答案之前,有意识地指导语言生成推理步骤链的模型,成功地将GSM8K基准测试从问题解决率从17.9%提升至58.1%。在本文中,作者提出了一个新的方法,多样化(推理步骤多样化验证器),以进一步提高他们的推理能力。多样化的首次探索不同的提示,以增强多样性推理路径。其次多样化引入验证器来区分好的答案从糟糕的答案中选出更好的加权投票。最后,多样化验证每个步骤的正确性,而不是所有步骤的正确性步骤一个整体。作者使用code-davinci-002最新的语言模型进行广泛的实验,并证明DIVERSE可以在八个推理基准中的六个(例如,GSM8K74.4%→83.2%)上实现新的最先进的性能,优于具有540B参数的PaLM模型。

论文下载:https://arxiv.org/pdf/2206.02336v2.pdf

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢