【标题】Towards Safe Reinforcement Learning via Constraining Conditional Value-at-Risk

【作者团队】Chengyang Ying, Xinning Zhou, Hang Su, Dong Yan, Ning Chen, Jun Zhu

【发表日期】2022.6.9

【论文链接】https://arxiv.org/pdf/2206.04436.pdf

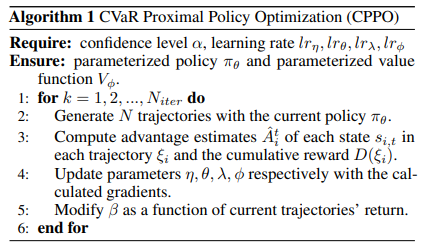

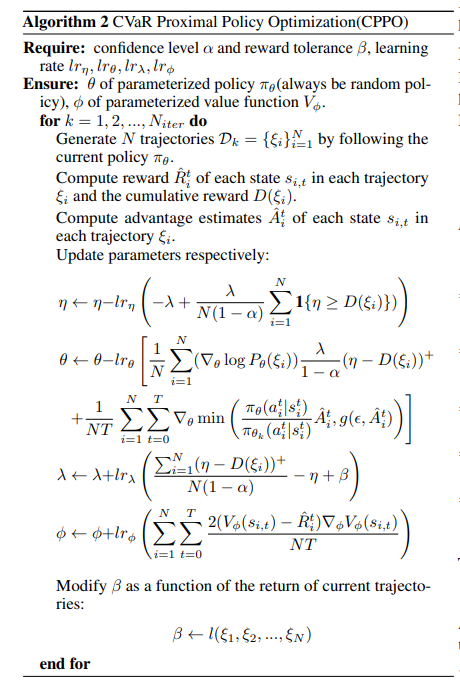

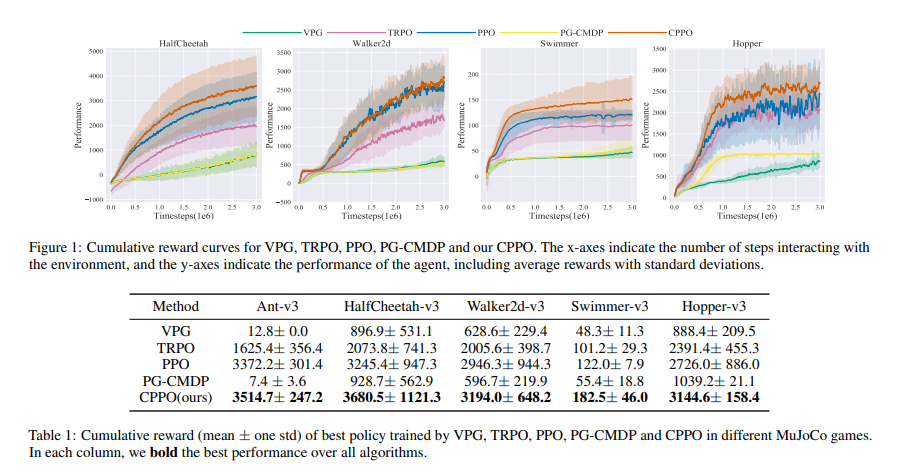

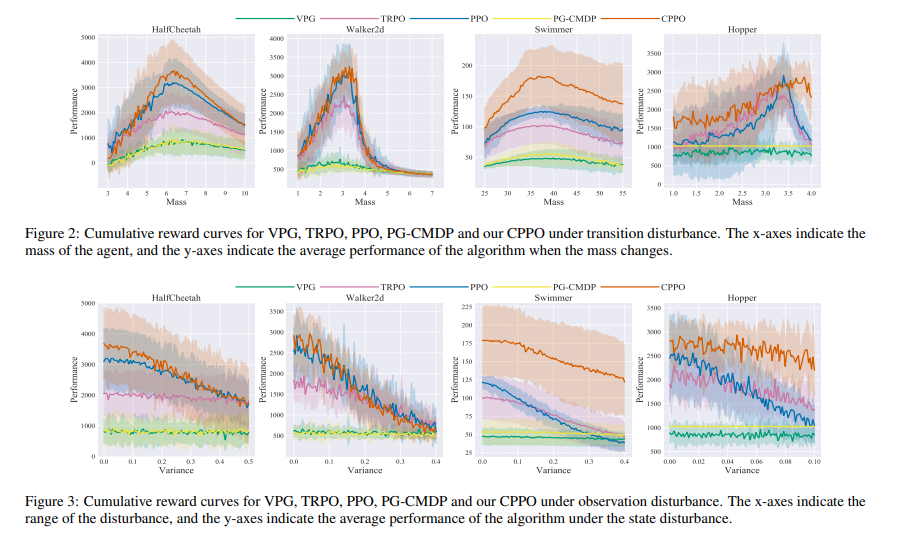

【推荐理由】虽然深度强化学习(DRL)已经取得了巨大的成功,但由于过渡和观测的内在不确定性,它可能会遇到灾难性的失败。现有的安全强化学习方法大多只能处理过渡干扰或观察干扰,因为这两种干扰影响agent的不同部分;此外,流行的最坏情况奖励可能导致过度悲观的策略。为此,本文首先从理论上证明了在过渡干扰和观测干扰下的性能退化取决于一种新的值函数范围度量(VFR),它对应于最佳状态和最差状态之间的值函数差距。进而采用条件风险值(CVaR)作为风险评估,提出了一种新的CVaR近似策略优化(CPPO)强化学习算法,通过将CVaR保持在给定阈值下,将风险敏感约束优化问题形式化。实验结果表明,在MuJoCo中,CPPO在一系列连续控制任务上获得了更高的累积奖励,并且对观测和过渡扰动都具有更强的鲁棒性。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢