【标题】Bootstrapped Transformer for Offline Reinforcement Learning

【作者团队】Kerong Wang, Hanye Zhao, Xufang Luo, Kan Ren, Weinan Zhang, Dongsheng Li

【发表日期】2022.6.17

【论文链接】https://arxiv.org/pdf/2206.08569.pdf

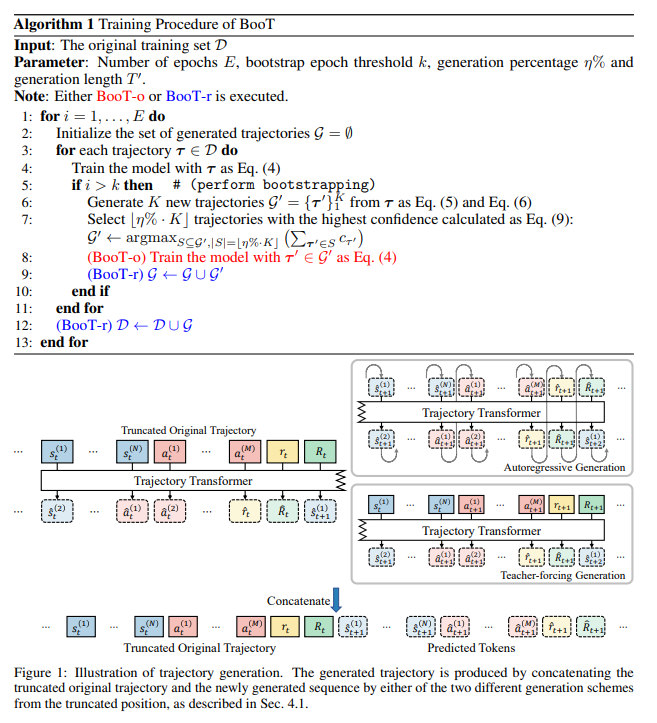

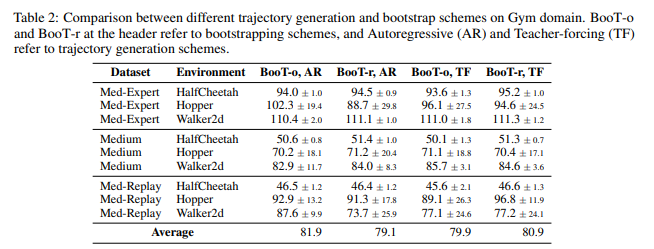

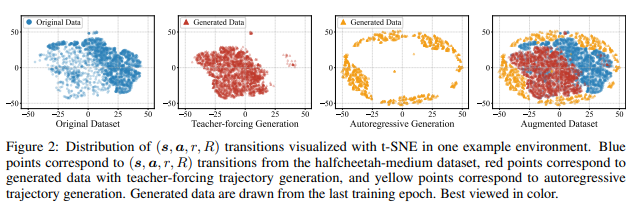

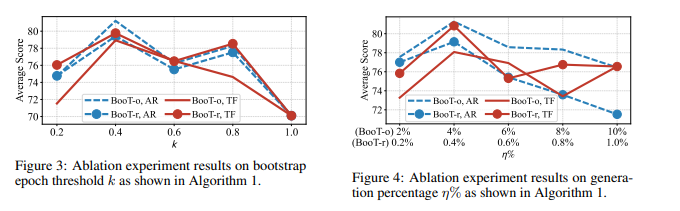

【推荐理由】离线强化学习 (RL) 旨在从先前收集的静态轨迹数据中学习策略,而无需与真实环境进行交互。现有研究提供了一个新颖视角,将离线 RL 视为通用序列生成问题,采用 Transformer 架构等序列模型对轨迹上的分布进行建模,并将波束搜索重新用作规划算法。然而,一般离线 RL 任务中使用的训练数据集非常有限,并且经常存在分布覆盖不足的问题,这可能对训练序列生成模型有害,但在先前研究中并未引起足够的重视。本文提出了一种名为 Bootstrapped Transformer 的新算法,它结合了自举的思想,利用学习到的模型自行生成更多的离线数据,进一步推动序列模型的训练。通过对两个离线 RL 基准进行了大量实验证明了该模型可以在很大程度上弥补现有的离线 RL 训练的局限性,并击败其他强大的基线方法。还分析了生成的伪数据,所揭示的特征可能会对离线 RL 训练提供一些启示。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢