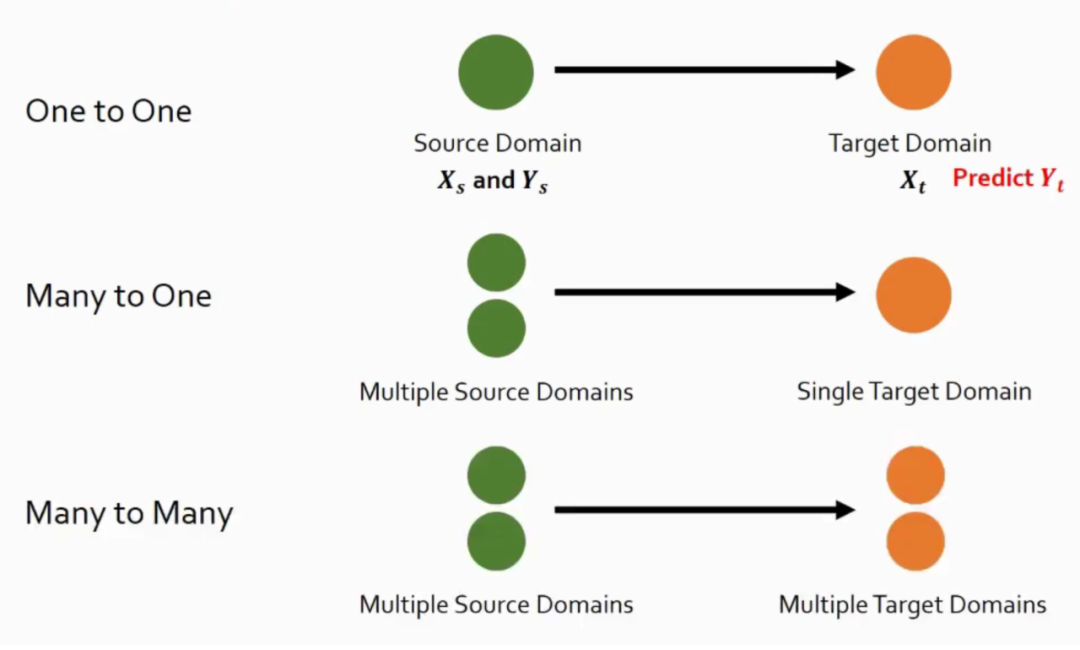

Domain Adaptation(DA:域自适应),Domain Generalization(DG:域泛化)一直以来都是各大顶会的热门研究方向。DA 假设我们有有一个带标签的训练集(源域),这时候我们想让模型在另一个数据集上同样表现很好(目标域),利用目标域的无标签数据,提升模型在域间的适应能力是 DA 所强调的。以此为基础,DG 进一步弱化了假设,我们只有多个源域的数据,根本不知道目标域是什么,这个时候如何提升模型泛化性呢?核心在于如何利用多个源域带来的丰富信息。本文挑选了四篇 CVPR 2022 域泛化相关的文章来研究最新的进展。

BIRM

论文标题:Bayesian Invariant Risk Minimization

论文链接:

https://openaccess.thecvf.com/content/CVPR2022/papers/Lin_Bayesian_Invariant_Risk_Minimization_CVPR_2022_paper.pdf

1.1 Motivation

分布偏移下的泛化是机器学习的一个开放挑战。不变风险最小化(IRM)通过提取不变特征来解决这个问题。虽然 IRM 有着完备的理论体系,但是在深度模型上表现往往不是很好,本文认为这种失败主要是深度模型容易过拟合引起的,并理论验证了当模型过拟合时,IRM 退化为传统的 ERM。本文将 Bayesian inference 引入 IRM 提出了 Bayesian Invariant Risk Min-imization(BIRM)来一定程度上缓解这个问题并取得了不错的效果。

1.2 Background

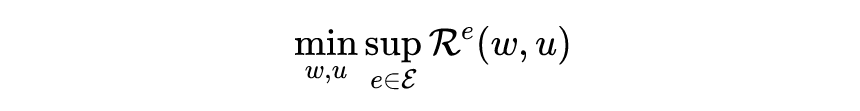

这里简单介绍一下 OOD 问题与 IRM,所谓的 OOD 问题可以写为如下形式

即寻找最优的分类器,encoder 参数 使得模型在表现最差的域都有比较好的性能,i.e., 。这里的 是域 中数据的负对数似然:

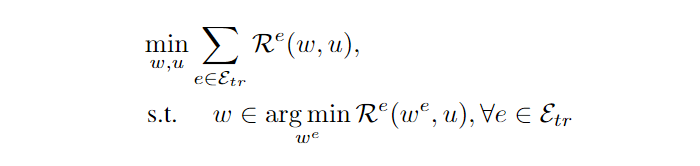

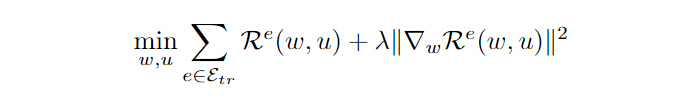

Invariant Risk Minimization(IRM). IRM 要解决如下问题:

Invariant Risk Minimization(IRM). IRM 要解决如下问题:

即他要学习一个 encoder 参数 ,这个 encoder 对所有的分类器参数 都同时是最优的。为了完成这个目标,encoder 需要抛弃掉 spurious feature。但是这个优化形式 bi-level 的,非常难解决,因此他又提出了一个近似的 target。

DARLING

论文标题:Towards Unsupervised Domain Generalization

论文链接:

https://arxiv.org/abs/2107.06219

2.1 Motivation

目前的 DG 算法大多采用在大数据集上预训练的 backbone,然后开发算法在下游数据集上进行 finetune,最后在 unseen 的数据集上进行测试。但是预训练的数据集会引入认为的 bias,比如 imagenet 的图像大多来自于真实世界,因此其预训练的模型在下游任务上非真实数据(手绘图像,漫画图像)表现就会很差。本文考虑了一个新的 setting,即模型先在多个源域上进行无监督的预训练,然后进行传统 DG 的过程,抹去传统 pretrain 引入的 bias。

2.2 Method

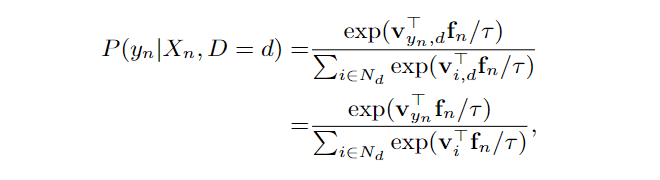

本文的方法名称为 Domain-Aware Representation Learn-ING(DARLING),这个方法尝试使用自监督学习的技术来提升多域预训练的方法从而提升泛化性能。传统的自监督学习损失即:

这里的 是自监督中的 anchor 和 positive 特征, 和 是两个独立的 encoder, 是温度参数。但是这种方法没办法建模域信心,因为 在不同域实际上是不一样的。每个域 的条件分布可以写作:

模型架构如下所示,这里的 是下面 similarity predictor 的输出。也就是说变成了各个 domain 对比学习损失的加权形式:

PCL

论文标题:PCL: Proxy-based Contrastive Learning for Domain Generalization

论文链接:

https://openaccess.thecvf.com/content/CVPR2022/papers/Yao_PCL_Proxy-Based_Contrastive_Learning_for_Domain_Generalization_CVPR_2022_paper.pdf

3.1 Motivation

本文也是与 contrastive learning 相关的一篇文章,一个简单的方法是将不同域的正样本对拉得更近,同时将其他负样本对推得更远。本文发现直接采用这种有监督的对比学习效果并不好,本文认为域之间存在的显著的分布差距,使得直接拉近正样本对的距离反而阻碍了模型的泛化。因此本文提出了一个新的基于原型(proxy)的对比学习方法。

3.2 Method: Proxy-based Contrastive Learning

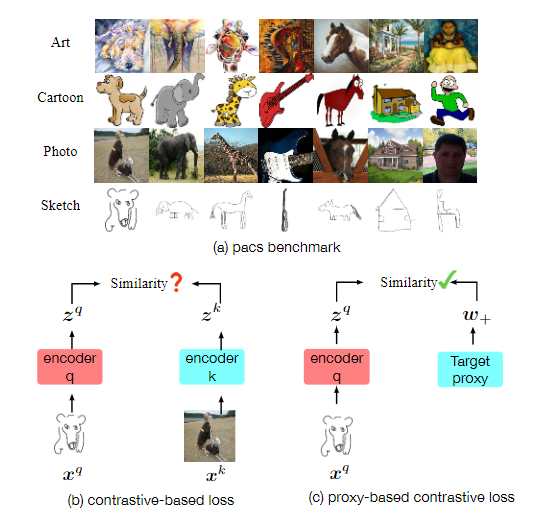

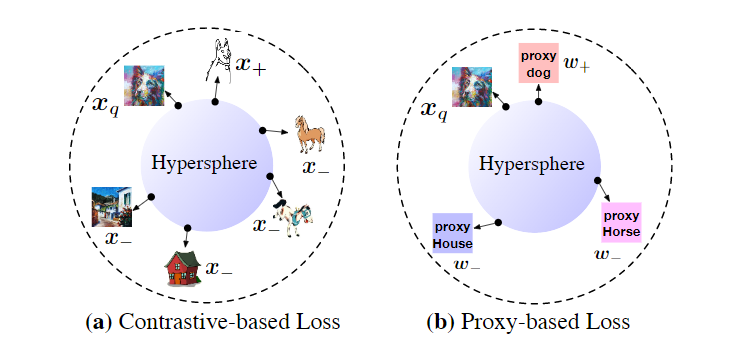

首先我们来看一下,基于原型的自监督学习方法与传统自监督学习方法有什么差别。如下图所示:

PACS 数据集是一个典型的领域泛化基准,它包含四个领域:艺术、漫画、照片和素描,每个领域有七个类别。DG 从多个源域(如艺术、照片、素描)训练模型,并在目标领域(如漫画)上进行测试。在训练阶段,目标数据集不能被访问。

传统的基于对比的损失(例如,监督对比损失)利用其样本到样本的关系,其中来自同一类的不同域样本可以被视为正对。我们认为,优化一些难正样本对可能会恶化模型的泛化能力。本文称之为正对齐问题( positive alignment problem)。因为各个域之间的 gap 有可能会非常大,因此直接对齐不同域的正样本反而可能对模型有害。本文提出了基于原型的对比损失来解决这个问题。二者的具体区别如下所示:

Style Neophile

论文标题:Style Neophile: Constantly Seeking Novel Styles for Domain Generalization

论文链接:

https://openaccess.thecvf.com/content/CVPR2022/papers/Kang_Style_Neophile_Constantly_Seeking_Novel_Styles_for_Domain_Generalization_CVPR_2022_paper.pdf

4.1 Motivation

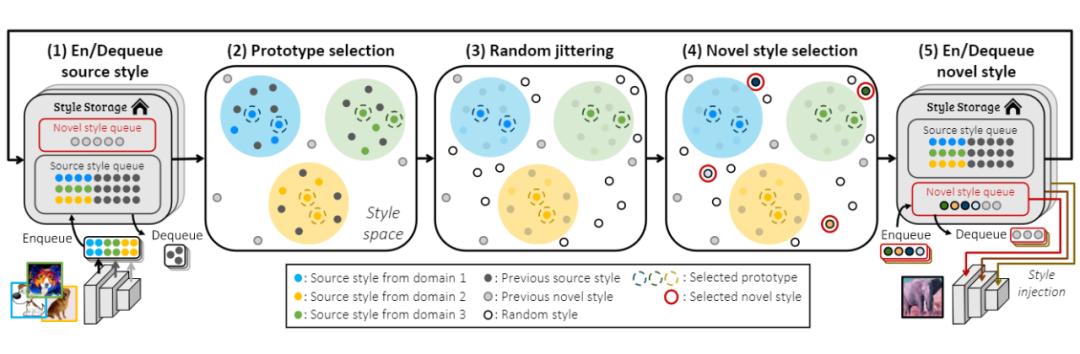

目前大多数 DG 方法都提到要学一个 domain-invariant 的特征,这类方法通常假设每个域有不同的图像风格,然后 enforce 同一个类的图像在不同风格下的特征是尽可能相似的。而,这些方法被限制在一个有限的风格集合上(我们得到的域的数目是有限的),因为它们从一组固定的训练图像或通过插值训练数据获得增强的样式。本文提出了一种新的方法,能够产生更多风格的数据,这些风格甚至是完全没有在训练集出现过的。

4.2 Method

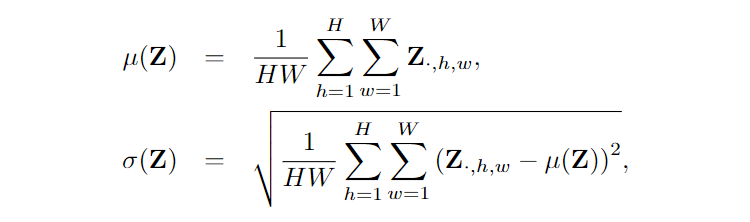

本文刻画所谓图像风格的方式即使用图像的均值和方差,对于图像的 feature map ,我们有 。

本文的整体框架如下所示,我们来依次介绍每个部分。

总结

本文挑选了四篇 CVPR 与 DG 相关的文章,他们分别从因果不变性,预训练方式,自监督学习 +DG 以及数据增强四个方面提出了新的方法,克服了以往的缺陷。但就目前而言,仍然没有一个里程碑式的方法可以在绝大多数 OOD 的 benchmark 上展现出压倒性效果,更好更快更强的方法仍然是目前所缺少的。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢