作者:JunYu Lu, Ping Yang, JiaXing Zhang,等

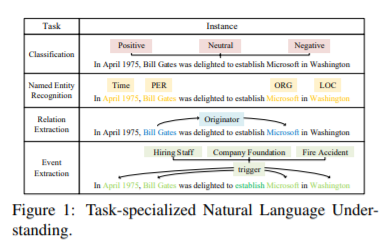

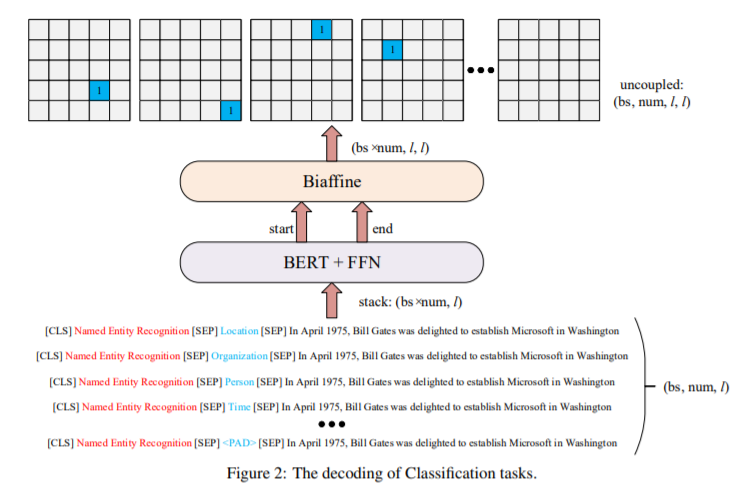

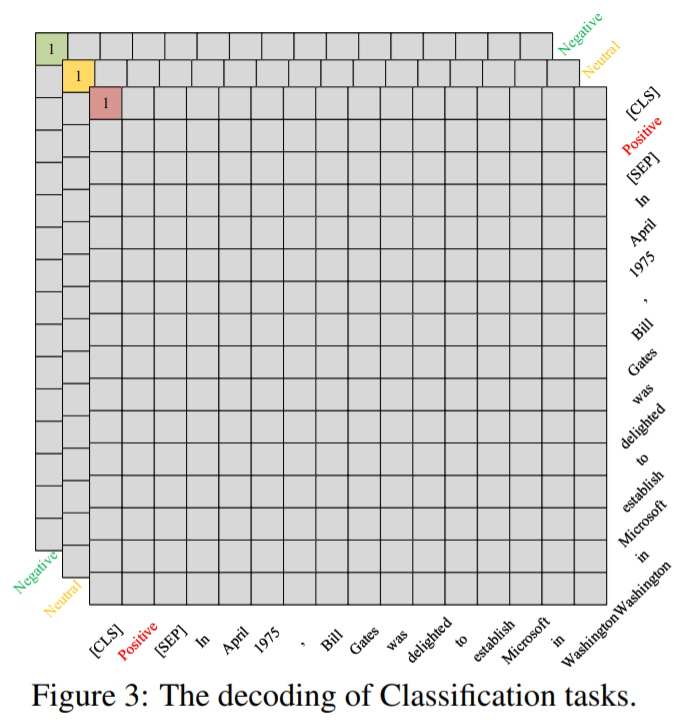

简介:本文研究预训练模型Bert在语言理解(NLU)领域的统一框架及小样本场景下的实践。即使预训练的语言模型共享一个语义编码器,自然语言理解也会受到多种输出模式的影响。在本文中,作者提出了基于BERT的统一双向语言理解模型 UBERT框架,可以通过双仿射网络对不同 NLU 任务的训练对象进行通用建模。具体来说,UBERT 从各个方面对先验知识进行编码,跨多个 NLU 任务统一构建学习表示,有利于增强捕获共同语义理解的能力。使用双仿射对原始文本的开始和结束位置的分数对进行建模,可以将各种分类和提取结构转换为通用的跨度解码方法。实验表明:UBERT 在 7 个 NLU 任务、14 个数据集的小样本和零样本设置上实现了最先进的性能,并实现了广泛信息提取和语言推理任务的统一。

论文下载:https://arxiv.org/pdf/2206.12094.pdf

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢