论文标题:Flowformer: Linearizing Transformers with Conservation Flows

论文链接:https://arxiv.org/pdf/2202.06258.pdf

代码链接:https://github.com/thuml/Flowformer

本文深入研究了注意力机制存在的二次复杂度问题,通过将网络流中的守恒原理引入设计,自然地将竞争机制引入到注意力计算中,有效避免了平凡注意力问题。

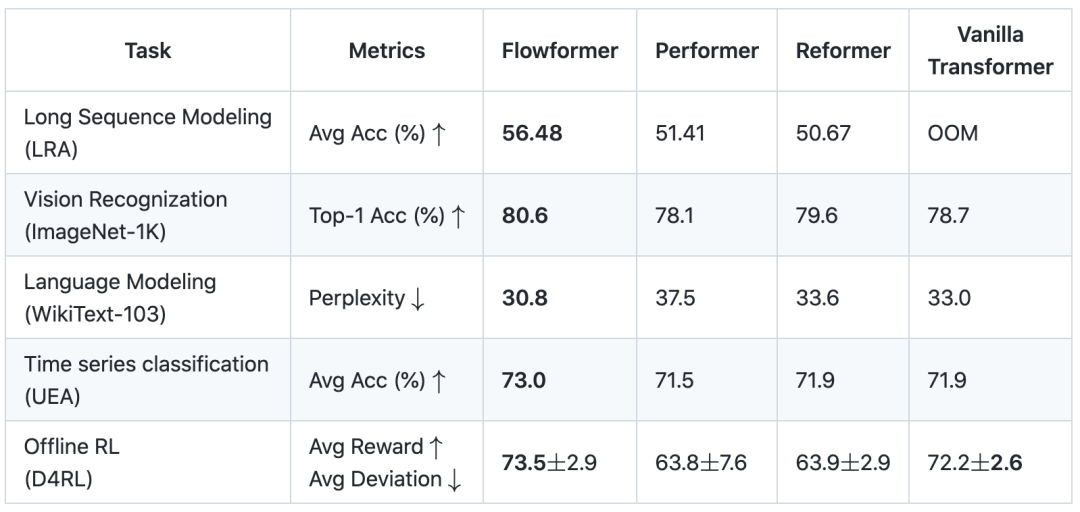

我们提出的任务通用的骨干网络Flowformer,实现了线性复杂度,同时在长序列、视觉、自然语言、时间序列、强化学习五大任务上取得优秀效果。

在长序列建模应用上,如蛋白质结构预测、长文本理解等,Flowformer具有良好的应用潜力。此外,Flowformer中“无特殊归纳偏好”的设计理念也对通用基础架构的研究具有良好的启发意义。

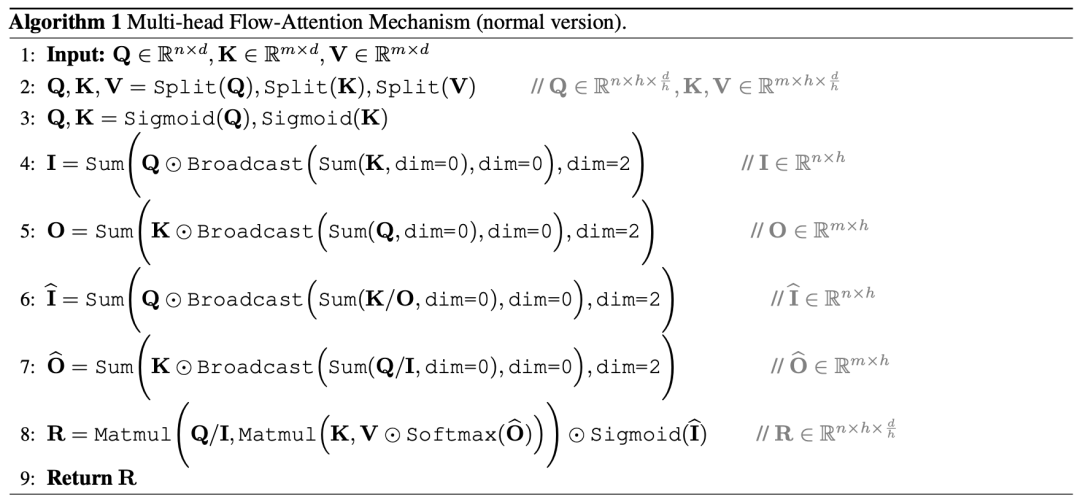

Flow-Attention的伪代码如下:

主要实验结果:

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢