【标题】An Empirical Study of Implicit Regularization in Deep Offline RL

【作者团队】Caglar Gulcehre, Srivatsan Srinivasan, Jakub Sygnowski, Georg Ostrovski, Mehrdad Farajtabar, Matt Hoffman, Razvan Pascanu, Arnaud Doucet

【发表日期】2022.7.7

【论文链接】https://arxiv.org/pdf/2207.02099v2.pdf

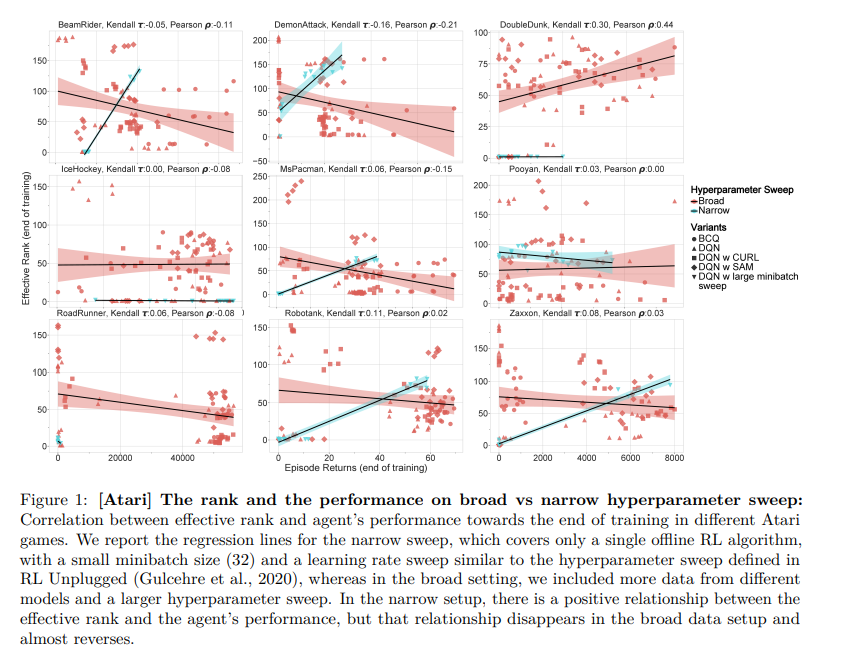

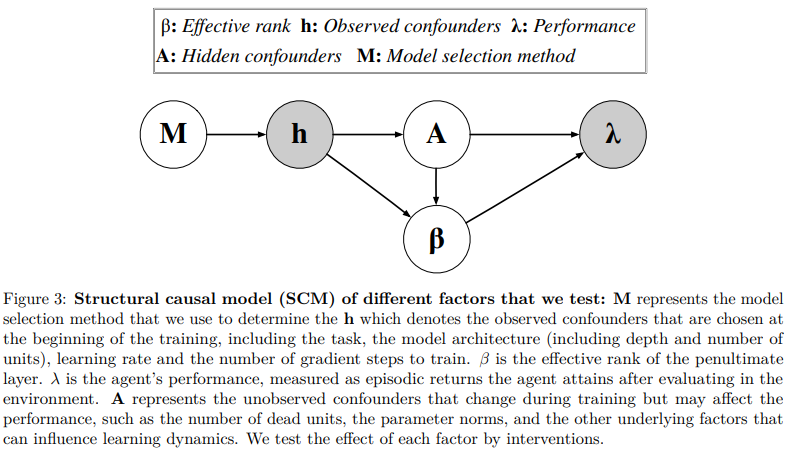

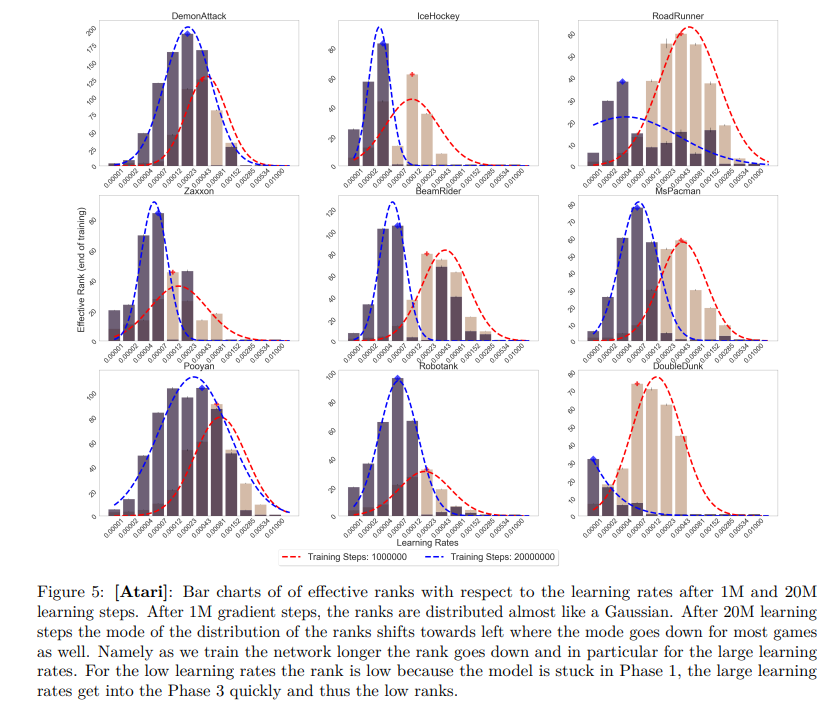

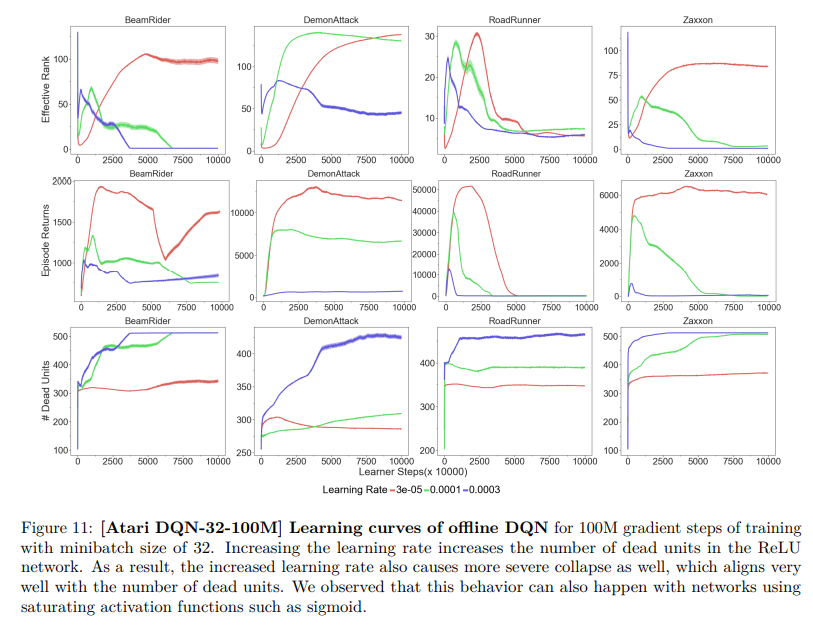

【推荐理由】深度神经网络是离线强化学习中最常用的函数逼近器。先前的研究表明,使用 TD 学习和梯度下降训练的神经网络可以表现出隐式正则化,其特征在于这些网络的参数化不足。即观察到倒数第二个特征层的排名,也称为 \textit{有效排名},在训练期间急剧下降。有效排名和性能之间的这种关联使得有效排名对离线 RL 具有吸引力,主要用于离线策略评估。本文对三个离线 RL 数据集:bsuite、Atari 和 DeepMind 实验室的有效排名和性能之间的关系进行了仔细的实证研究。其观察到直接关联仅存在于受限设置中,并在更广泛的超参数扫描中消失。此外,凭经验确定了三个学习阶段,这些阶段解释了隐式正则化对学习动态的影响,并发现单独的引导不足以解释有效排名的崩溃。最后表明其他几个因素可能会混淆有效排名和绩效之间的关系,并得出结论,在简单的假设下研究这种关联可能会产生高度误导。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢