作者:Cem Anil , Yuhuai Wu , Anders Andreassen ,等

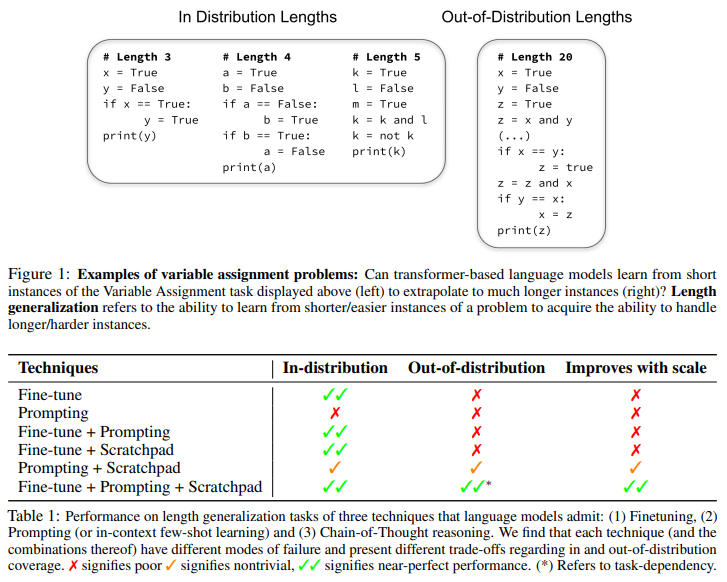

简介:从短问题实例推断到较长问题实例的能力是推理任务中分布外泛化的一种重要形式,并且在从很少有较长问题实例的数据集中学习时至关重要。其中包括定理证明、解决定量数学问题以及阅读/总结小说。在本文中,作者进行了细致的实证研究,探索基于transformer的语言模型的长度泛化能力。作者首先确定:在长度泛化任务上简单地微调transformer、可以显示出与模型规模无关的显着泛化缺陷。然后作者展示了结合预训练的大型语言模型的上下文学习能力与暂存提示(要求模型在产生答案之前输出解决方案步骤)导致长度泛化的显着改进。作者对每种学习方式都进行了细致的失败分析,并确定了常见的错误来源,这些错误突出了使语言模型具备泛化到更长问题的能力的机会。

论文下载:https://arxiv.org/pdf/2207.04901.pdf

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢