论文链接:https://arxiv.org/pdf/2207.05340.pdf

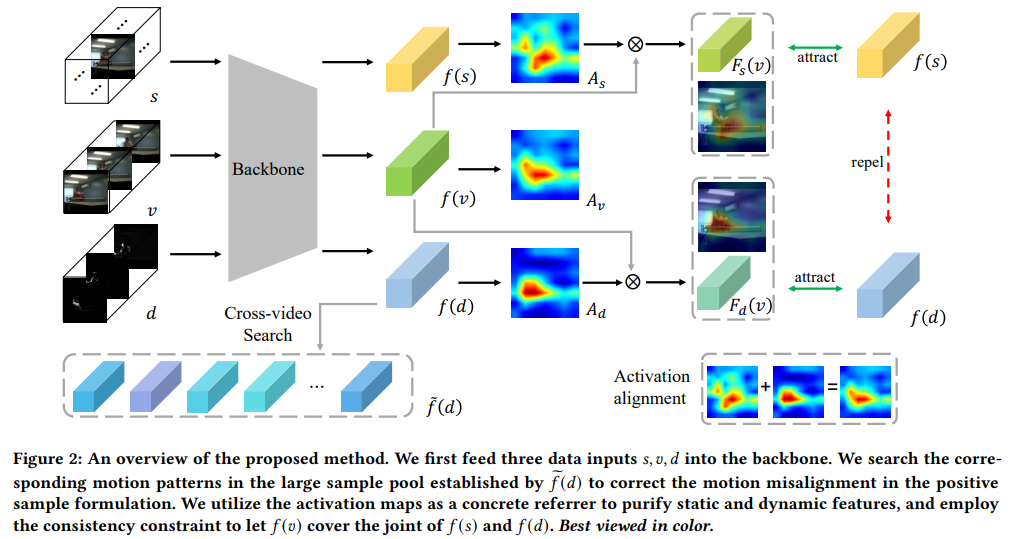

对比学习在自我监督的时空表征学习中显示出巨大的潜力。 大多数作品天真地采样不同的剪辑来构建正负对。 然而,我们观察到这个公式使模型倾向于背景场景偏差。 根本原因是双重的。 首先,场景差异通常比运动差异更明显且更容易区分。 其次,从同一视频中采样的片段通常具有相似的背景,但具有不同的动作。 简单地将它们视为正对将模型绘制到静态背景而不是运动模式。 为了应对这一挑战,本文提出了一种新颖的双重对比公式。 具体来说,我们将输入的 RGB 视频序列解耦为两种互补模式,静态场景和动态运动。 然后,将原始 RGB 特征分别拉近静态特征和对齐的动态特征。 通过这种方式,静态场景和动态运动同时被编码为紧凑的 RGB 表示。 我们进一步通过激活图进行特征空间解耦,以提取静态和动态相关的特征。 我们将我们的方法称为时空表示的双对比学习 (DCLR)。 大量实验表明,DCLR 学习了有效的时空表示,并在 UCF-101、HMDB-51 和 Diving-48 数据集上获得了最先进或相当的性能。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢