的确,孩子们通过模仿父母来学习语言,但这只是故事的一小部分。

近日,Gary Marcus在个人博客发文,继续抨击预训练语言模型,并认为学习语言的过程远远不是复制粘贴那么简单。

摘要如下:

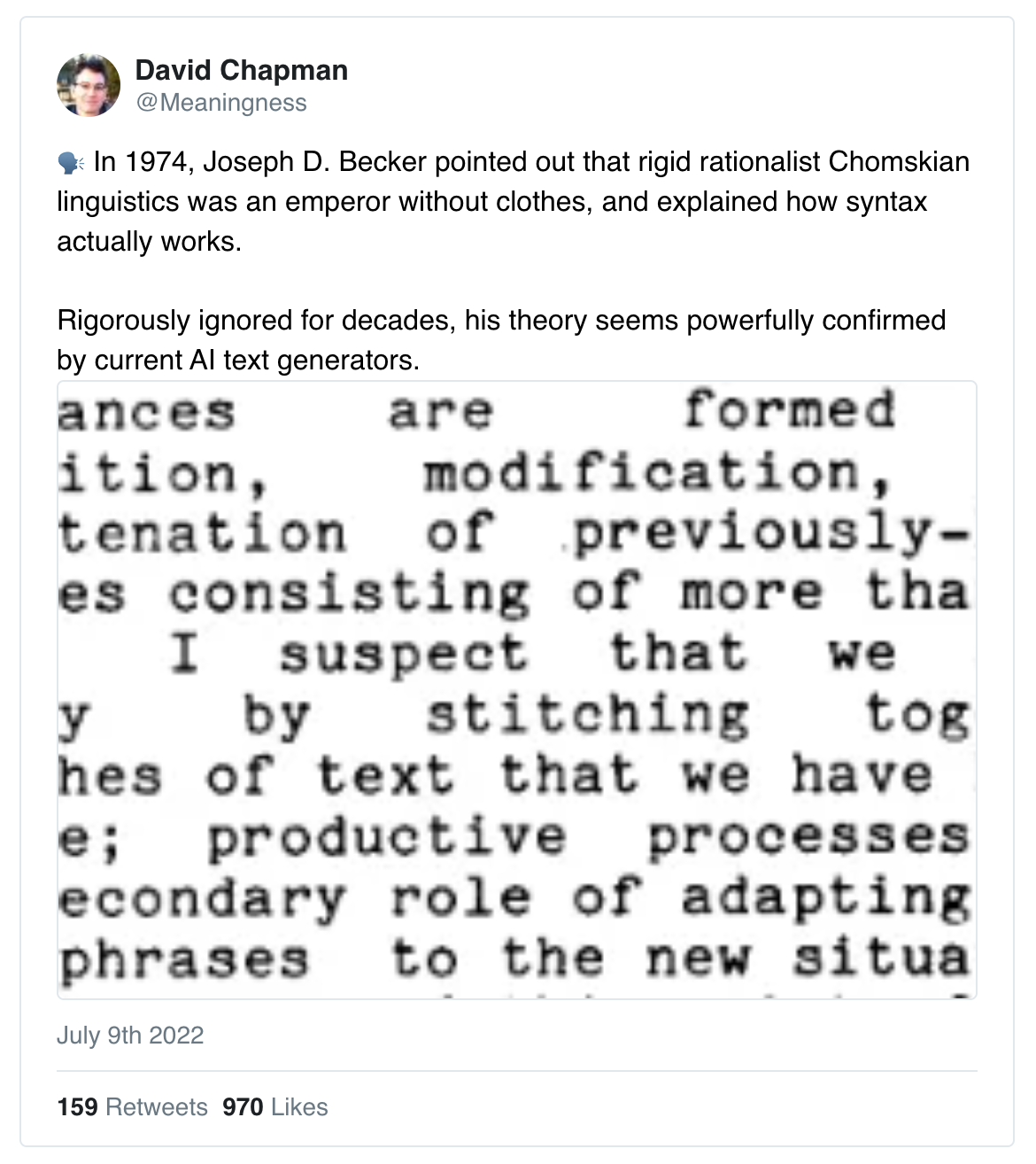

AI推特宇宙中的一些人似乎认为,如果只是获得语言是很容易的。前几天,来自大卫查普曼的这条推特:

大约 1,000 人喜欢 Twitter 中的第一条推文,可能是因为他们想感觉自己比诺姆·乔姆斯基更聪明。剧透警告:他们可能不是。

正如推特系列贴的其余部分继续解释的那样,吸引人的前提是学习语言很简单。孩子真正需要做的就是记住一堆东西,然后复制并粘贴记住的部分。 (隐含的好处:像 GPT-3 这样的系统非常擅长记忆东西,所以我们必须非常接近解开语言习得的奥秘。)

该推特似乎暗示,你不需要所有这些复杂的系统,例如乔姆斯基和他的其他语言学家努力理解的语法规则和句法(语法)树。

问题是,当前的人工智能系统(粗略地说)在没有那些语法规则和树的情况下进行大量剪切和粘贴,并不能真正接近理解人类语言。而且,更糟糕的是,这条推特本身,以及它关于什么是语言以及如何学习它的想法,结果证明得有点像火车残骸(即“惨不忍睹”)。

部分原因是该推特主要针对一个稻草人(乔姆斯基在 1974 年所相信的漫画,在许多相关的语言学分支以现代形式发展之前),但主要是因为它忽略了两件至关重要的事情:语言的复杂性,以及孩子在获得语言的过程中实际做了什么。

更多内容请阅读博客原文。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢