本文介绍一篇IJCAI2022浙大和阿里联合出品的采用对比学习的字典描述知识增强的预训练语言模型-DictBERT。

论文标题:

Dictionary Description Knowledge Enhanced Language Model Pre-training via Contrastive Learning

论文链接:

https://arxiv.org/pdf/2208.00635.pdf

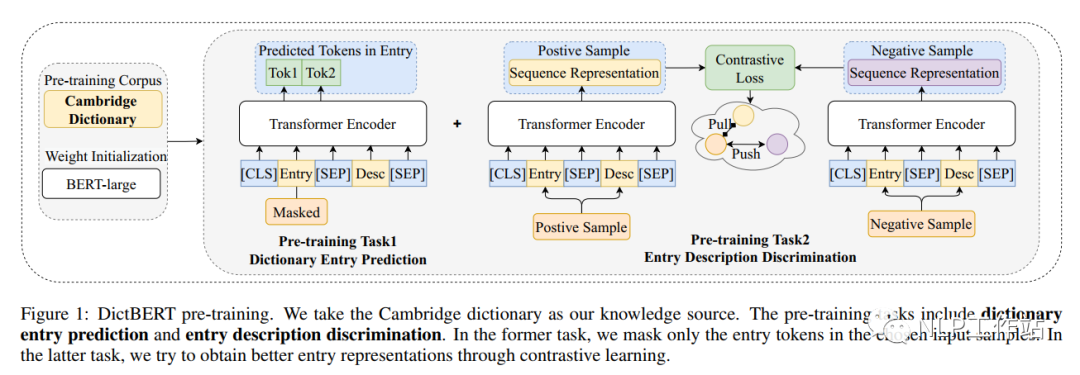

预训练语言模型(PLMs)目前在各种自然语言处理任务中均取得了优异的效果,并且部分研究学者将外部知识(知识图谱)融入预训练语言模型中后获取了更加优异的效果,但具体场景下的知识图谱信息往往是不容易获取的,因此,我们提出一种新方法DictBert,将字典描述信息作为外部知识增强预训练语言模型,相较于知识图谱的信息增强,字典描述更容易获取。

在预训练阶段,提出来两种新的预训练任务来训练DictBert模型,通过掩码语言模型任务和对比学习任务将字典知识注入到DictBert模型中,其中,掩码语言模型任务为字典中词条预测任务(Dictionary Entry Prediction);对比学习任务为字典中词条描述判断任务(Entry Description Discrimination)。

在微调阶段,我们将DictBert模型作为可插拔的外部知识库,对输入序列中所包含字典中的词条信息作为外部隐含知识内容,注入到输入中,并通过注意机制来增强输入的表示,最终提升模型表征效果。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢