作者:Jason Phang, Yao Zhao, Peter J. Liu

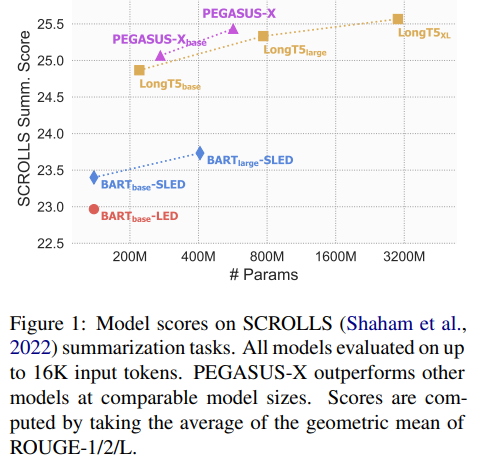

简介:本文研究长文本输入摘要的扩展。虽然大型预训练 Transformer 模型已被证明在处理自然语言任务方面非常有能力,但处理长序列输入仍然是一个重大挑战。其中一项任务是长输入摘要,其中输入长于大多数预训练模型的最大输入上下文。通过一系列广泛的实验,作者研究了哪些模型架构变化和预训练范式可以最有效地使预训练的 Transformer 适应长输入摘要。作者发现,具有全局编码器令牌的交错块局部 Transformer 在性能和效率之间取得了良好的平衡,并且对长序列的额外预训练阶段有意义地提高了下游摘要性能。根据实验的发现,作者提出了 PEGASUS-X(PEGASUS 模型的扩展),具有额外的长输入预训练以处理多达 16K 令牌的输入。PEGASUS-X 在长输入摘要任务上实现了强大的性能,可与更大的模型相媲美,同时添加很少的额外参数并且不需要模型并行性来训练。

论文下载:https://arxiv.org/pdf/2208.04347.pdf

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢