作者:Guy Rotman, Roi Reichart

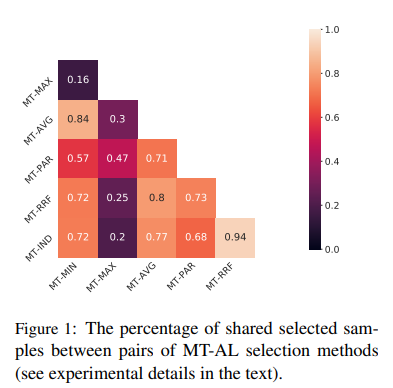

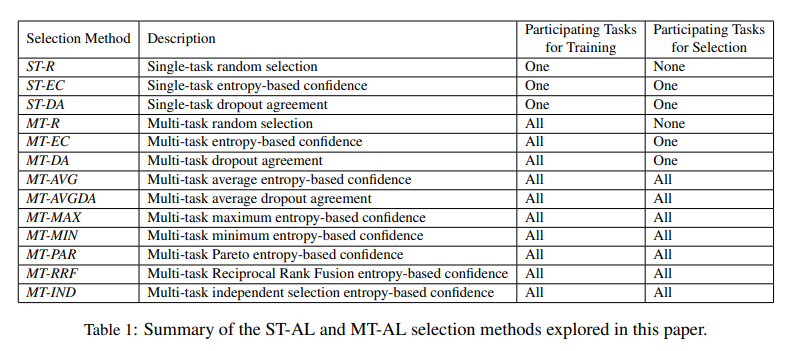

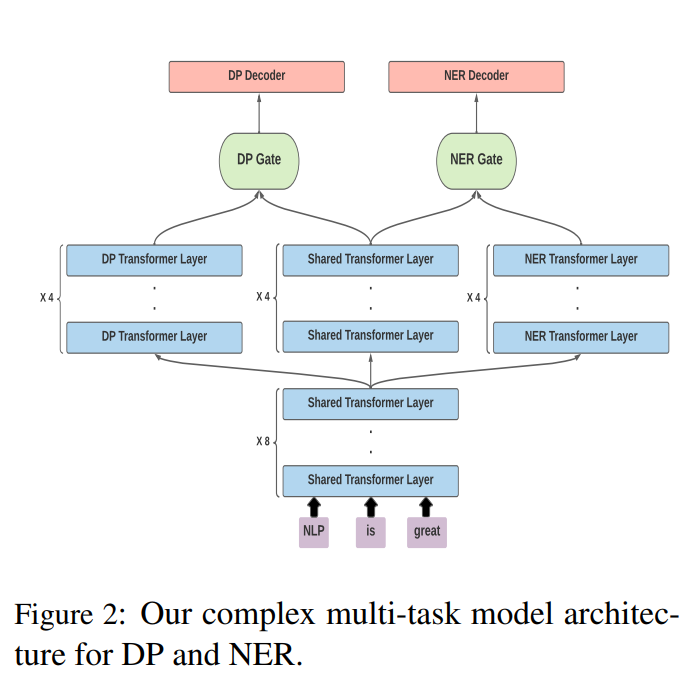

简介:本文研究多任务主动学习在基于 Transformer 的预训练NLP模型的应用。多任务学习,其中多个任务由单个模型共同学习,允许 NLP 模型共享来自多个注释的信息,并且可以在任务相互关联时促进更好的预测。然而,这种技术需要使用多个注释方案来注释相同的文本,这可能既昂贵又费力。主动学习 (AL) 已被证明可以通过迭代选择其注释对 NLP 模型最有价值的未标记示例来优化注释过程。然而,多任务主动学习 (MT-AL) 尚未应用于最先进的基于 Transformer 的预训练 NLP 模型。本文旨在缩小这一差距。作者在三个现实的多任务场景中探索了各种多任务选择标准,反映了参与任务之间的不同关系,并证明与单任务选择相比,多任务的有效性。作者的结果表明,可以有效地使用 MT-AL,以最大限度地减少多任务 NLP 模型的注释工作。

论文下载:https://arxiv.org/pdf/2208.05379.pdf

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢