作者:Jiyang Zhang, Sheena Panthaplackel, Pengyu Nie,等

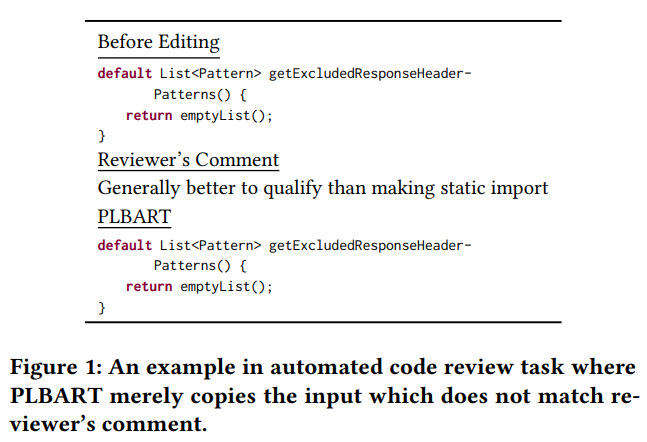

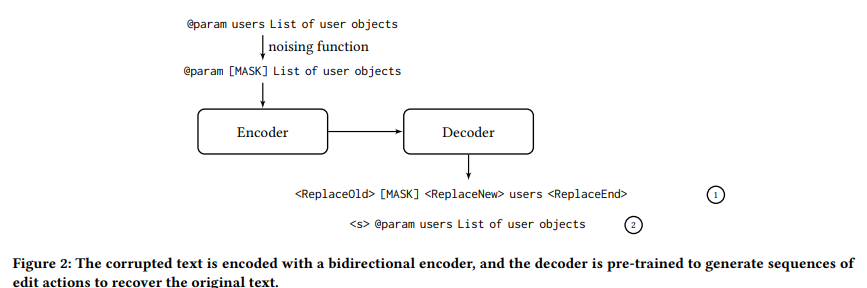

简介:本文研究代码生成领域基于编辑的模型创新。预训练的语言模型已被证明在许多与软件相关的生成任务中是有效的;但是,它们并不适合编辑任务,因为它们并非旨在推理编辑。为了解决这个问题,作者提出了一个新的预训练目标,它明确地对编辑进行建模并使用它来构建 CoditT5,这是一种用于软件相关编辑任务的大型语言模型,它在大量源代码和自然语言注释上进行了预训练。作者在各种下游编辑任务上对其进行微调,包括评论更新、错误修复和自动代码审查。通过优于纯基于生成的模型,作者证明了其方法的普遍性及其对编辑任务的适用性。作者还展示了纯生成模型和作者基于编辑的模型如何通过简单的重新排序策略相互补充,

论文下载:https://arxiv.org/pdf/2208.05446.pdf

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢